Linux: Docker

TAGS: Linux

内容概述

docker 基本操作

容器镜像制作和管理

数据卷管理

网络管理

镜像仓库管理

容器编排管理工具docker compose

容器资源限制

可视化容器管理工具Portainer

容器多进程管理

容器排查

镜像加速

docker 基本操作

Container 即容器,但今天我们所说的容器是一种 IT 技术。容器其实是一种沙盒技术。顾名思义,沙盒就是能够像一个集装箱一样,把你的应用装起来。这样,应用与应用之间就有了边界而不会相互干扰;同时装在沙盒里面的应用,也可以很方便的被搬来搬去,这也是 PaaS 想要的最理想的状态(可移植性,标准化,隔离性)。

Docker 介绍

容器历史

docker八卦

虽然 docker 把容器技术推向了巅峰,但容器技术却不是从 docker 诞生的。实际上,容器技术连新技术都算不上,因为它的诞生和使用确实有些年头了。下面的一串名称可能有的你都没有听说过,但它们的确都是容器技术的应用:

- 1、Chroot Jail

就是我们常见的 chroot 命令的用法。它在 1979 年的时候就出现了,被认为是最早的容器化技术之一。它可以把一个进程的文件系统隔离起来。

- 2、The FreeBSD Jail

Freebsd Jail (监狱)实现了操作系统级别的虚拟化,它是操作系统级别虚拟化技术的先驱之一。2000年,伴随FreeBSD4.0版的发布

- 3、Linux VServer

使用添加到 Linux 内核的系统级别的虚拟化功能实现的专用虚拟服务器。允许创建许多独立的虚拟专用服务器(VPS),这些虚拟专用服务器在单个物理服务器上全速同时运行,从而有效地共享硬件资源。VPS提供与传统Linux服务器几乎相同的操作环境。可以在这样的VPS上启动所有服务(例如ssh,邮件,Web和数据库服务器),而无需(或者在特殊情况下只需进行很少的修改),就像在任何真实服务器上一样。

每个VPS都有自己的用户帐户数据库和root密码,并且与其他虚拟服务器隔离,但它们共享相同的硬件资源

2003年11月1日 VServer 1.0 发布官网:http://linux-vserver.org/

- 4、Solaris Containers

它也是操作系统级别的虚拟化技术,专为 X86 和 SPARC 系统设计。Solaris 容器是系统资源控制和通过"区域" 提供边界隔离的组合。

- 5、OpenVZ

OpenVZ 是一种 Linux 中操作系统级别的虚拟化技术。 它允许创建多个安全隔离的 Linux 容器,即VPS。

- 6、Process Containers

Process 容器由 Google 的工程师开发,一般被称为 cgroups。

- 7、LXC

LXC为Linux Container的简写。可以提供轻量级的虚拟化,以便隔离进程和资源,而且不需要提供指令解释机制以及全虚拟化的其他复杂性。容器有效地将由单个操作系统管理的资源划分到孤立的组中,以更好地在孤立的组之间平衡有冲突的资源使用需求。

Linux Container提供了在单一可控主机节点上支持多个相互隔离的server container同时执行的机制。

Linux Container有点像chroot,提供了一个拥有自己进程和网络空间的虚拟环境,但又有别于虚拟机,因为lxc是一种操作系统层次上的资源的虚拟化。

- 8、Warden

在最初阶段,Warden 使用 LXC 作为容器运行时。 如今已被 CloudFoundy 取代。

- 9、LMCTFY

LMCTY 是 Let me contain that for you 的缩写。它是 Google 的容器技术栈的开源版本。Google 的工程师一直在与 docker 的 libertainer 团队合作,并将 libertainer 的核心概念进行抽象并移植到此项目中。该项目的进展不明,估计会被 libcontainer 取代。

- 10、Docker

Docker 是一个可以将应用程序及其依赖打包到几乎可以在任何服务器上运行的容器的工具。

- 11、RKT

RKT 是 Rocket 的缩写,它是一个专注于安全和开放标准的应用程序容器引擎。

综上所述正如我们所看到的,docker 并不是第一个容器化技术,但它的确是最知名的一个。

Docker 是什么

Docker (码头工人)是一个开源项目,诞生于 2013 年初,最初是 dotCloud 公司(后由于 Docker 开源后大受欢迎就将公司改名为 Docker Inc ,总部位于美国加州的旧金山)内部的一个开源的 PAAS 服

务 (Platform as a ServiceService )的业余项目。它基于 Google 公司推出的 Go 语言实现。 项目后来加入了 Linux 基金会,遵从了 Apache 2.0 协议,项目代码在 GitHub 上进行维护。

Docker 是基于 linux 内核实现,Docker 最早采用 LXC 技术 ,LXC 是 Linux 原生支持的容器技术 ,可以提供轻量级的虚拟化 ,可以说 docker 就是基于 LXC 发展起来 的,提供 LXC 的高级封装,标准的配置方法,在LXC的基础之上,docker提供了一系列更强大的功能。而虚拟化技术 KVM(KernelKernelbased Virtual Machine Machine) 基于 模块实现, 后来Docker 改为自己研发并开源的 runc 技术运行

容器,彻底抛弃了LXC。

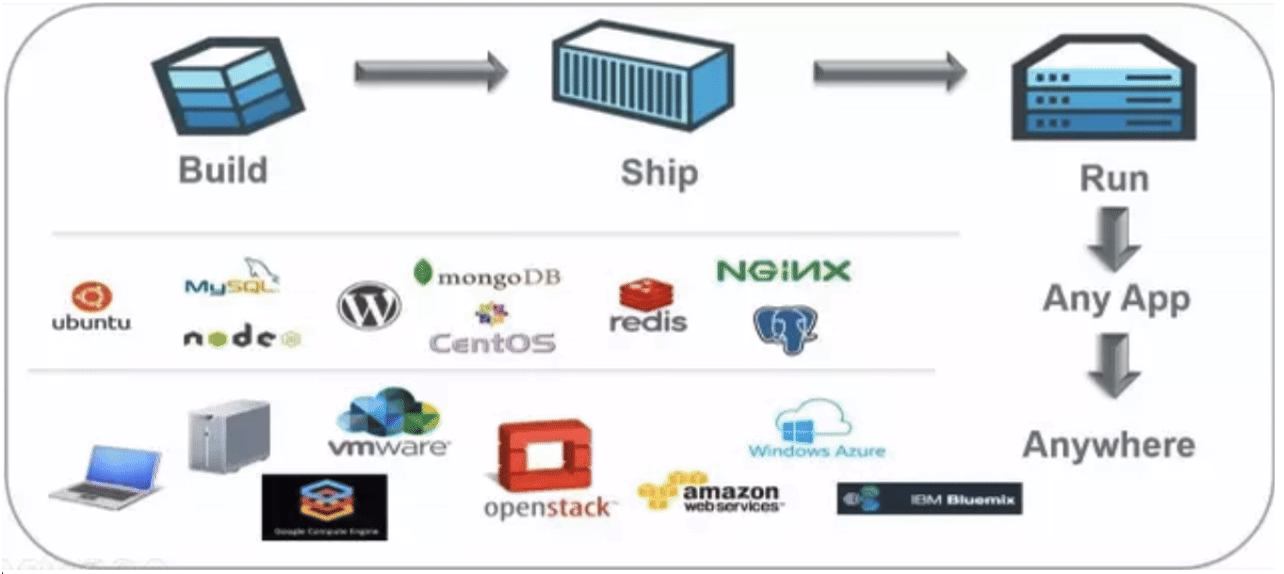

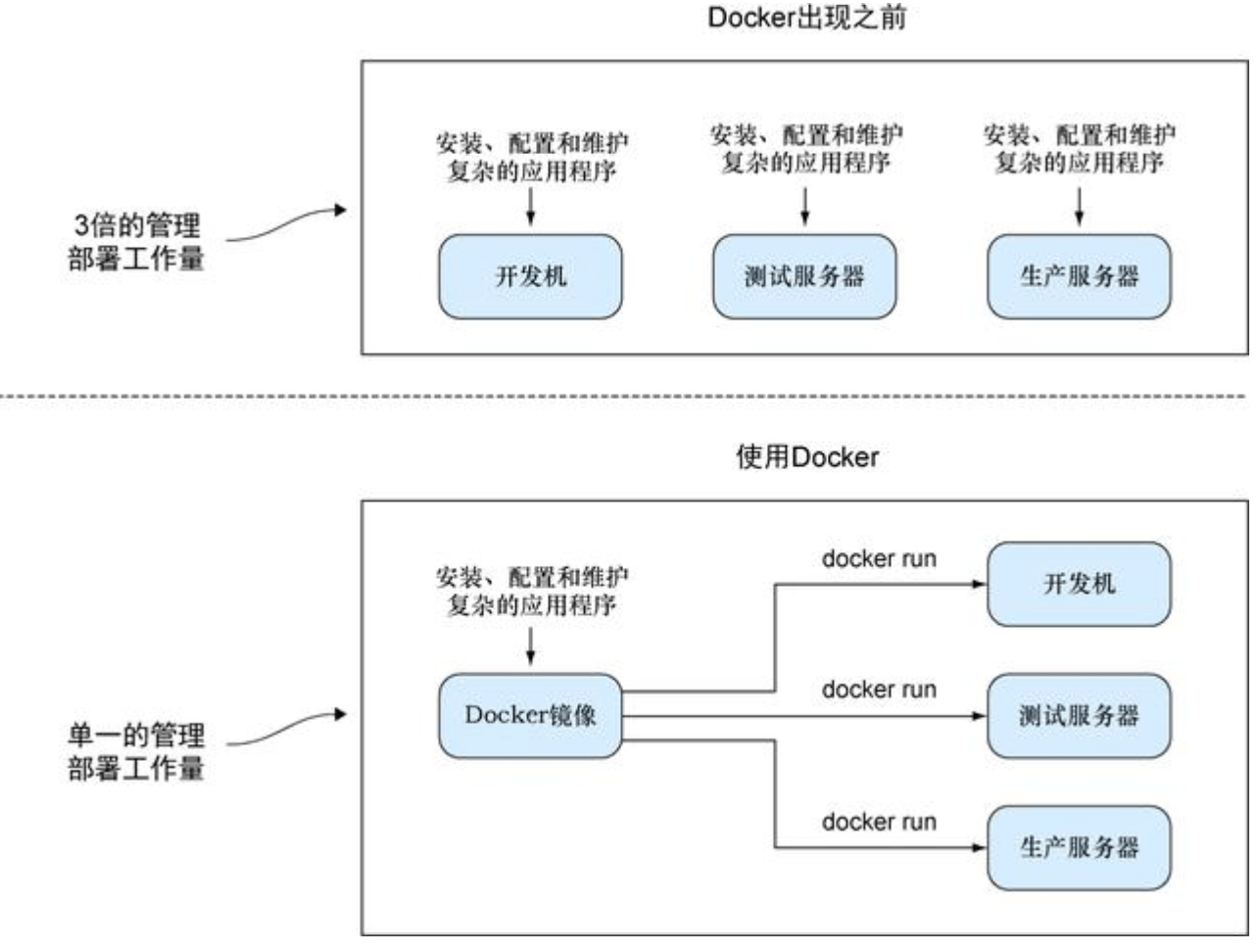

Docker 相比虚拟机的交付速度更快,资源消耗更低,Docker 采用客户端/服务端架构,使用远程API来管理和创建容器,其可以轻松的创建一个轻量级的、可移植的、自给自足的容器,docker 的三大理念是build(构建)、ship(运输)、 run(运行),Docker遵从apache 2.0协议,并通过(namespace及cgroup等)来提供容器的资源隔离与安全保障等,所以Docke容器在运行时不需要类似虚拟机(空运行的虚拟机占用物理机6-8%性能)的额外资源开销,因此可以大幅提高资源利用率,总而言之Docker是一种用了新颖方式实现的轻量级虚拟机.类似于VM但是在原理和应用上和VM的差别还是很大的,并且docker的专业叫法是应用容器(Application Container)。

Docker的主要目标

Build, Ship and Run Any App, Anywhere,即通过对应用组件的封装(Packaging)、分发(Distribution)、部署(Deployment)、运行(Runtime)等生命周期的管理,达到应用组件级别的“一次封装,到处运行”。这里的应用组件,既可以是一个Web应用,也可以是一套数据库服务,甚至是一个操作系统。将应用运行在Docker 容器上,可以实现跨平台,跨服务器,只需一次配置准备好相关的应用环境,即可实现到处运行,保证研发和生产环境的一致性,解决了应用和运行环境的兼容性问题,从而极大提升了部署效率,减少故障的可能性

使用Docker 容器化封装应用程序的意义:

- 统一基础设施环境-docker环境

- 硬件的组成配置

- 操作系统的版本运行时环境的异构

- 硬件的组成配置

- 统一程序打包(装箱)方式-docker镜像

- java程序

- python程序

- nodejs程序

- java程序

- 统一程序部署(运行)方式-docker容器

- java-jar…→ docker run…

- python manage.py runserver… → docker run…

- npm run dev … → docker run…

- java-jar…→ docker run…

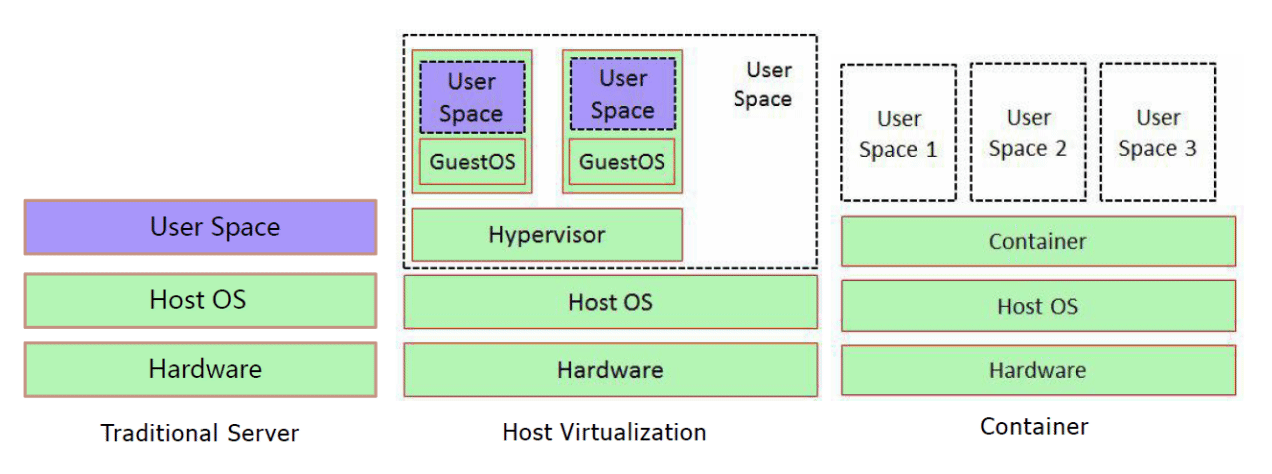

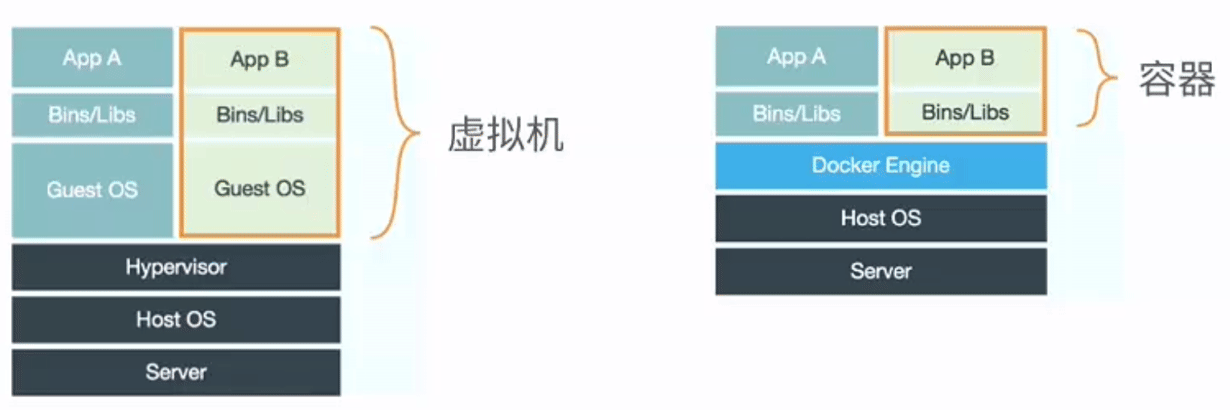

Docker 和虚拟机,物理主机

容器和虚拟机技术比较

- 传统虚拟机是虚拟出一个主机硬件,并且运行一个完整的操作系统 ,然后在这个系统上安装和运行软件

- 容器内的应用直接运行在宿主机的内核之上,容器并没有自己的内核,也不需要虚拟硬件,相当轻量化

- 每个容器间是互相隔离,每个容器内都有一个属于自己的独立文件系统,独立的进程空间,网络空间,用户空间等,所以在同一个宿主机上的多个容器之间彼此不会相互影响

容器和虚拟机表现比较

- 资源利用率更高: 开销更小,不需要启动单独的虚拟机OS内核占用硬件资源,可以将服务器性能压榨至极致.虚拟机一般会有5-20%的损耗,容器运行基本无损耗,所以生产中一台物理机只能运行数十个虚拟机,但是一般可以运行数百个容器

- 启动速度更快: 可以在数秒内完成启动

- 占用空间更小: 容器一般占用的磁盘空间以MB为单位,而虚拟机以GB

- 集成性更好: 和CI/CD(持续集成/持续部署)相关技术结合性更好,实现打包镜像发布测试可以一键运行,做到自动化并快速的部署管理,实现高效的开发生命周期

使用虚拟机是为了更好的实现服务运行环境隔离,每个虚拟机都有独立的内核,虚拟化可以实现不同操作系统的虚拟机,但是通常一个虚拟机只运行一个服务,很明显资源利用率比较低且造成不必要的性能损耗,我们创建虚拟机的目的是为了运行应用程序,比如Nginx、PHP、Tomcat等web程序,使用虚拟机无疑带来了一些不必要的资源开销,但是容器技术则基于减少中间运行环节带来较大的性能提升。

根据实验,一个运行着CentOS的KVM虚拟机启动后,在不做优化的情况下,虚拟机自己就需要占用100~200 MB内存。此外,用户应用运行在虚拟机里面,它对宿主机操作系统的调用就不可避免地要经过虚拟化软件的拦截和处理,这本身又是一层性能损耗,尤其对计算资源、网络和磁盘I/O的损耗非常大。

比如: 一台96G内存的物理服务器,为了运行java程序的虚拟机一般需要分配8G内存/4核的资源,只能运行13台左右虚拟机,但是改为在docker容器上运行Java程序,每个容器只需要分配4G内存即可,同样的物理服务器就可以运行25个左右容器,运行数量相当于提高一倍,可以大幅节省IT支出,通常情况下至少可节约一半以上的物理设备

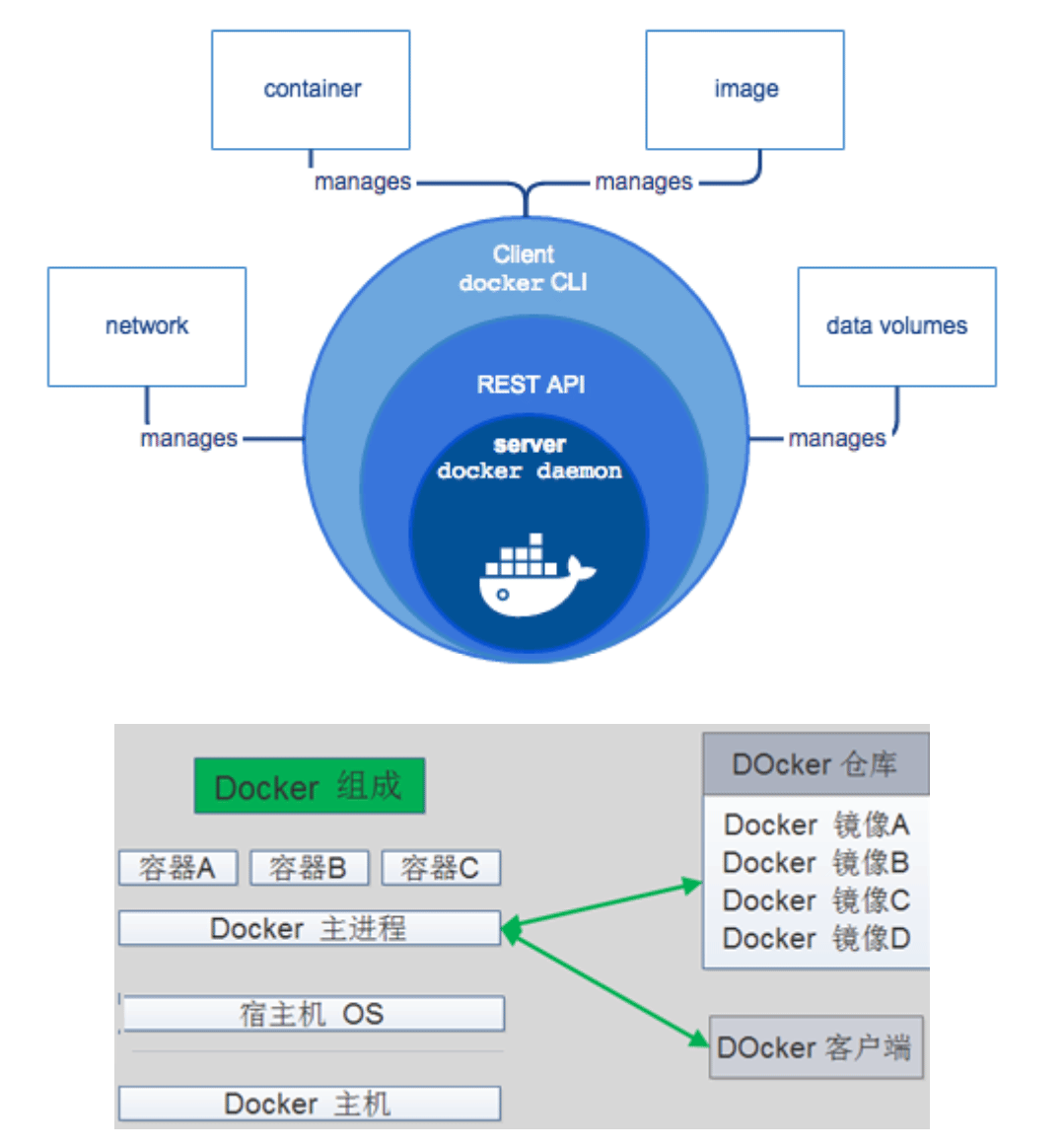

Docker 的组成

docker 官网: http://www.docker.com

帮助文档链接: https://docs.docker.com/

docker 镜像: https://hub.docker.com/

docker 中文网站: http://www.docker.org.cn/Docker

- Docker 主机(Host): 一个物理机或虚拟机,用于运行Docker服务进程和容器,也称为宿主机,node节点

- Docker 服务端(Server): Docker守护进程,运行docker容器

- Docker 客户端(Client): 客户端使用 docker 命令或其他工具调用docker API

- Docker 镜像(Images): 镜像可以理解为创建实例使用的模板,本质上就是一些程序文件的集合

- Docker 仓库(Registry): 保存镜像的仓库,官方仓库: https://hub.docker.com/ ,可以搭建私有仓库harbor

- Docker 容器(Container): 容器是从镜像生成对外提供服务的一个或一组服务,其本质就是将镜像中的程序启动后生成的进程

Namespace

一个宿主机运行了N个容器,多个容器共用一个 OS,必然带来的以下问题:

- 怎么样保证每个容器都有不同的文件系统并且能互不影响?

- 一个docker主进程内的各个容器都是其子进程,那么如果实现同一个主进程下不同类型的子进程?各个容器子进程间能相互通信(内存数据)吗?

- 每个容器怎么解决IP及端口分配的问题?

- 多个容器的主机名能一样吗?

- 每个容器都要不要有root用户?怎么解决账户重名问题?

namespace是Linux系统的底层概念,在内核层实现,即有一些不同类型的命名空间被部署在核内,各个docker容器运行在同一个docker主进程并且共用同一个宿主机系统内核,各docker容器运行在宿主机的用户空间,每个容器都要有类似于虚拟机一样的相互隔离的运行空间,但是容器技术是在一个进程内实现运行指定服务的运行环境,并且还可以保护宿主机内核不受其他进程的干扰和影响,如文件系统空间、网络空间、进程空间等,目前主要通过以下技术实现容器运行空间的相互隔离:

隔离类型 功能 系统调用参数 内核版本

- MNT Namespace(mount): 提供磁盘挂载点和文件系统的隔离能力 CLONE_NEWNS 2.4.19

- IPC Namespace(InterProcess Communication):提供进程间通信的隔离能力,包括信号量,消息队列和共享内存 CLONE_NEWIPC 2.6.19

- UTS Namespace(UNIX Timesharing System):提供内核,主机名和域名隔离能力 CLONE_NEWUTS 2.6.19

- PID Namespace(ProcessIdentification): 提供进程隔离能力 CLONE_NEWPID 2.6.24

- Net Namespace(network): 提供网络隔离能力,包括网络设备,网络栈,端口等 CLONE_NEWNET 2.6.29

- User Namespace(user):提供用户隔离能力,包括用户和组 CLONE_NEWUSER 3.8

NameSpace是在内核级别完成环境隔离的方法。你可以把它想象成一种change root机制,能模拟一个独立的Linux运行使得用户程序在指定位置运行。

MNT Namespace

每个容器都要有独立的根文件系统有独立的用户空间,以实现在容器里面启动服务并且使用容器的运行环境,即一个宿主机是ubuntu的服务器,可以在里面启动一个centos运行环境的容器并且在容器里面启动一个Nginx服务,此Nginx运行时使用的运行环境就是centos系统目录的运行环境,但是在容器里面是不能访问宿主机的资源,宿主机是使用了chroot技术把容器锁定到一个指定的运行目录里面。

例如:

/var/lib/containerd/io.containerd.runtime.v1.linux/moby/容器ID

根目录:

/var/lib/docker/overlay2/ID

范例: 容器和宿主机共享内核

[root@centos8 ~]#podman exec nginx uname -r 4.18.0-147.el8.x86_64 [root@centos8 ~]#uname -r 4.18.0-147.el8.x86_64

IPC Namespace

一个容器内的进程间通信,允许一个容器内的不同进程的(内存、缓存等)数据访问,但是不能跨容器直接访问其他容器的数据

UTS Namespace

UTS namespace(UNIX Timesharing System包含了运行内核的名称、版本、底层体系结构类型等信息)用于系统标识,其中包含了主机名hostname 和域名domainname ,它使得一个容器拥有属于自己主机名标识,这个主机名标识独立于宿主机系统和其上的其他容器。

PID Namespace

Linux系统中,有一个PID为1的进程(init/systemd)是其他所有进程的父进程,那么在每个容器内也要有一个父进程来管理其下属的子进程,那么多个容器的进程通PID namespace进程隔离(比如PID编号重复、器内的主进程生成与回收子进程等)。

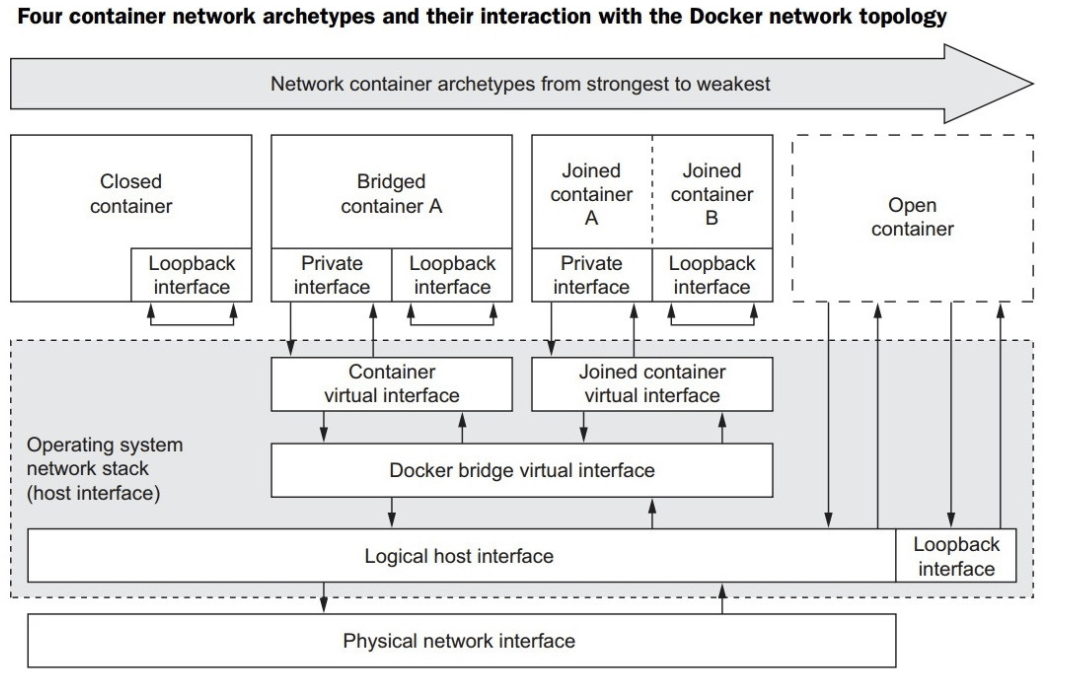

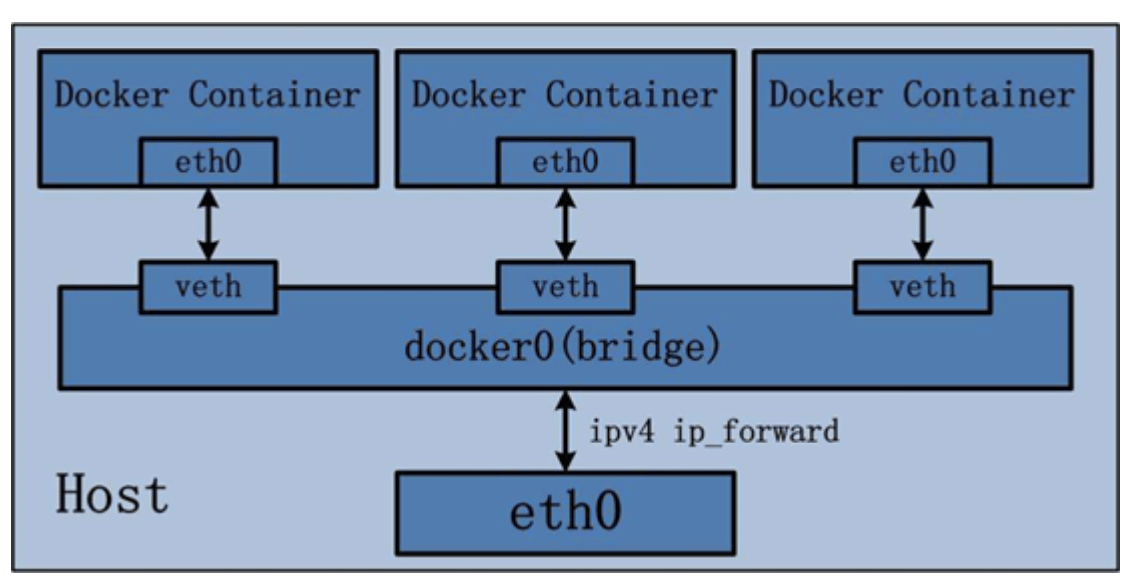

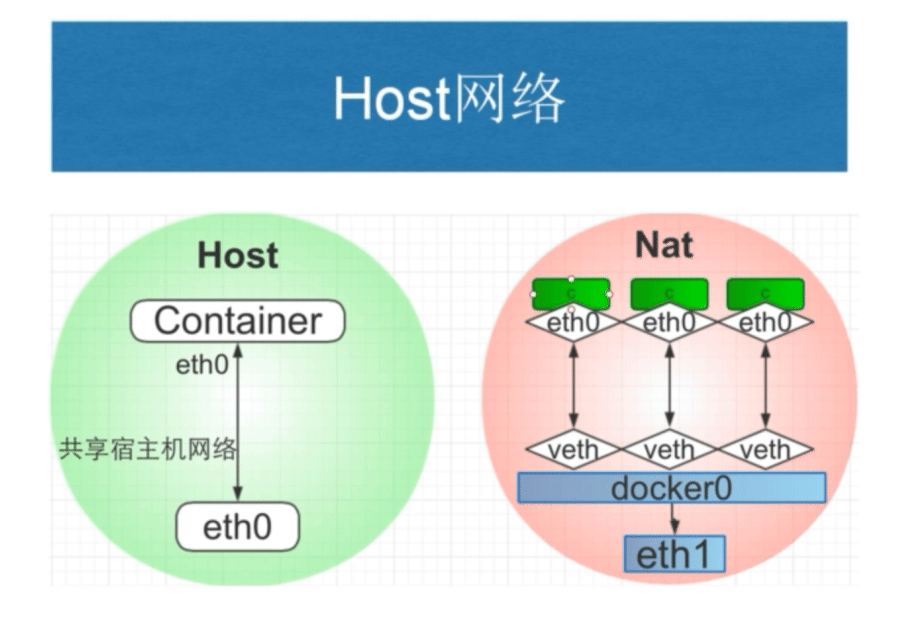

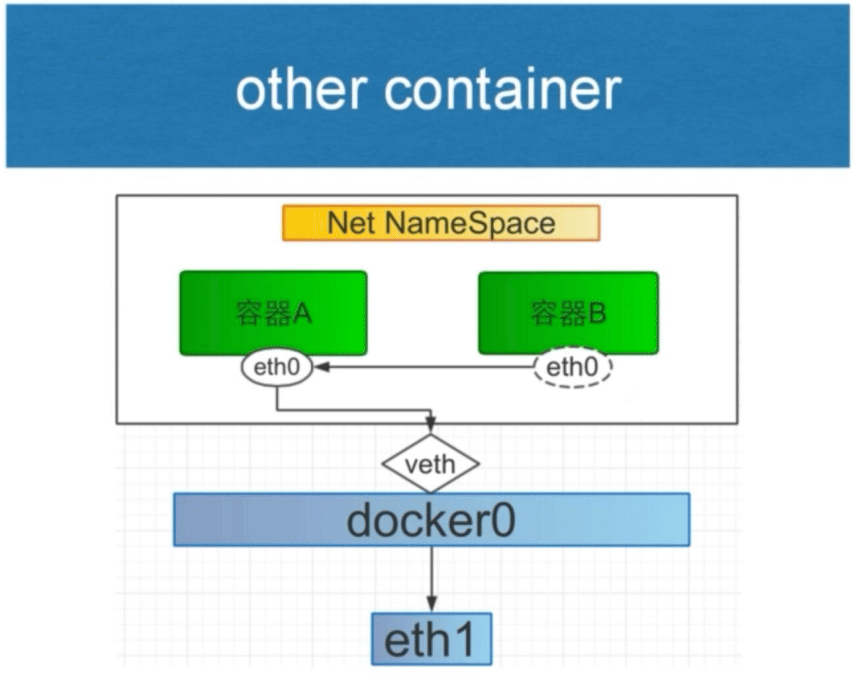

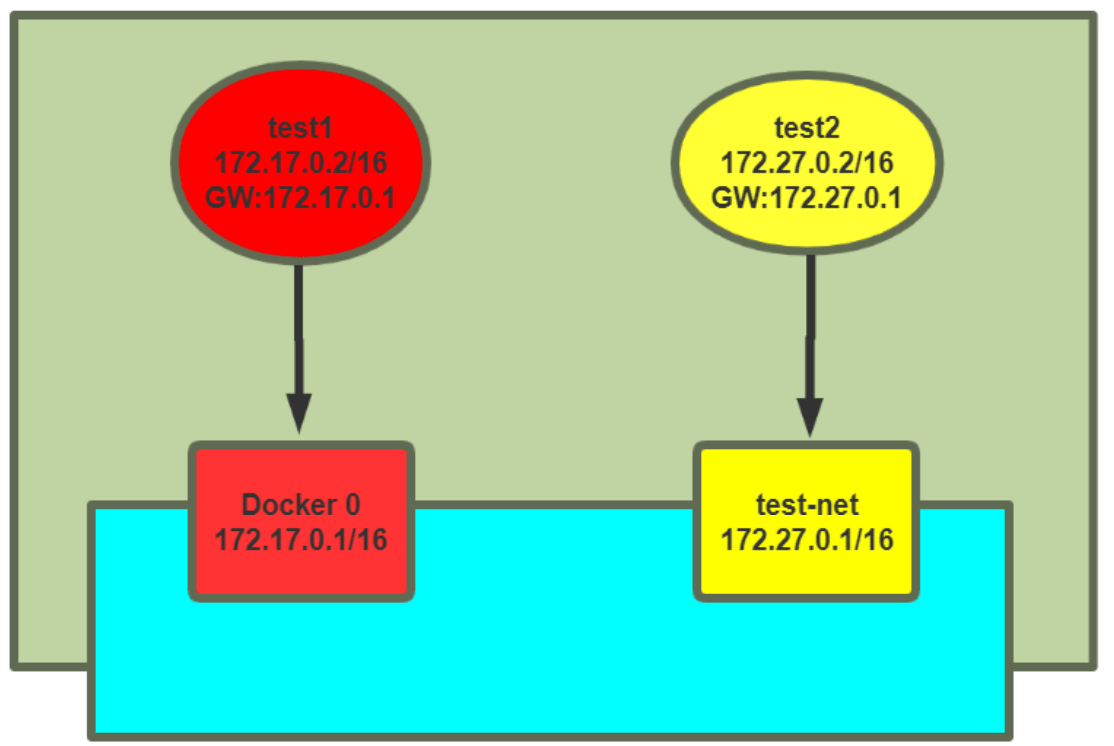

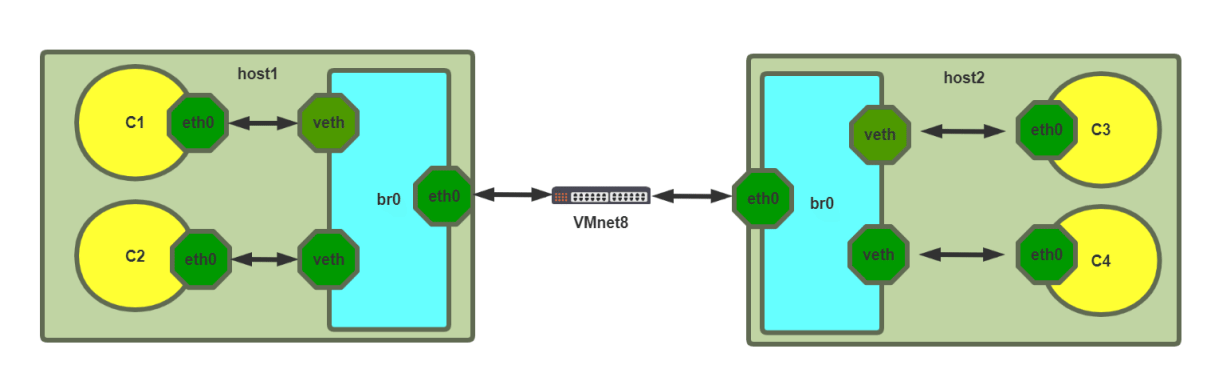

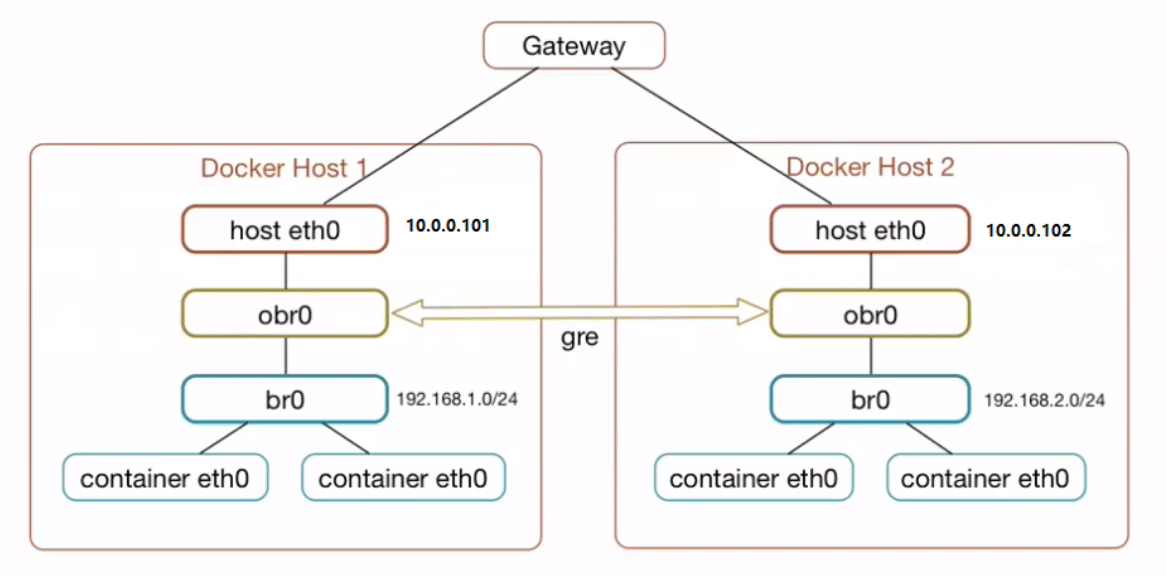

NET Namespace

每一个容器都类似于虚拟机一样有自己的网卡、监听端口、TCP/IP协议栈等,

Docker使用network namespace启动一个vethX接口,这样你的容器将拥有它自己的桥接ip地址,通常是docker0,而docker0实质就是Linux的虚拟网桥,网桥是在OSI七层模型的数据链路层的网络设备,通过mac地址对网络进行划分,并且在不同网络直接传递数据。

演示:2)ip netns:管理网络名称空间

将接口移动到指定的网络名称空间

[root@centos7 ~]# ip netns add mynet [root@centos7 ~]# ip link set eno16777736 netns mynet [root@centos7 ~]# ip netns list [root@centos7 ~]# ip netns exec mynet ip link show #在虚拟网络中的使用命令查看或 ip netns exec mynet netstat -ntlp [root@centos7 ~]# ip netns del mynet #删除虚拟网络空间后,其里网卡设备也就还原原位置了;

User Namespace

各个容器内可能会出现重名的用户和用户组名称,或重复的用户UID或者GID,那么怎么隔离各个容器内的用户空间呢?

User Namespace允许在各个宿主机的各个容器空间内创建相同的用户名以及相同的用户UID和GID,只是会把用户的作用范围限制在每个容器内,即A容器和B容器可以有相同的用户名称和ID的账户,但是此用户的有效范围仅是当前容器内,不能访问另外一个容器内的文件系统,即相互隔离、互不影响、永不相见。

Control groups

Linux Cgroups的全称是Linux Control Groups,是Linux内核的一个功能.最早是由Google的工程师(主要是Paul Menage和Rohit Seth)在2006年发起,最早的名称为进程容器(process containers)。在2007年时,因为在Linux内核中,容器(container)这个名词有许多不同的意义,为避免混乱,被重命名为cgroup,并且被合并到2.6.24版的内核中去。自那以后,又添加了很多功能。

如果不对一个容器做任何资源限制,则宿主机会允许其占用无限大的内存空间,有时候会因为代码bug程序会一直申请内存,直到把宿主机内存占完,为了避免此类的问题出现,宿主机有必要对容器进行资源分配限制,比如CPU、内存等

Cgroups 最主要的作用,就是限制一个进程组能够使用的资源上限,包括CPU、内存、磁盘、网络带宽等等。此外,还能够对进程进行优先级设置,资源的计量以及资源的控制(比如:将进程挂起和恢复等操作)。

验证系统 cgroups

Cgroups在内核层默认已经开启,从CentOS 和 Ubuntu 不同版本对比,显然内核较新的支持的功能更多。

Centos 8.1 cgroups:

[root@centos8 ~]#cat /etc/redhat-release CentOS Linux release 8.1.1911 (Core) [root@centos8 ~]#grep CGROUP /boot/config-4.18.0-147.el8.x86_64 CONFIG_CGROUPS=y CONFIG_BLK_CGROUP=y # CONFIG_DEBUG_BLK_CGROUP is not set CONFIG_CGROUP_WRITEBACK=y CONFIG_CGROUP_SCHED=y CONFIG_CGROUP_PIDS=y CONFIG_CGROUP_RDMA=y CONFIG_CGROUP_FREEZER=y CONFIG_CGROUP_HUGETLB=y CONFIG_CGROUP_DEVICE=y CONFIG_CGROUP_CPUACCT=y CONFIG_CGROUP_PERF=y CONFIG_CGROUP_BPF=y # CONFIG_CGROUP_DEBUG is not set CONFIG_SOCK_CGROUP_DATA=y # CONFIG_BLK_CGROUP_IOLATENCY is not set CONFIG_NETFILTER_XT_MATCH_CGROUP=m CONFIG_NET_CLS_CGROUP=y CONFIG_CGROUP_NET_PRIO=y CONFIG_CGROUP_NET_CLASSID=y [root@centos8 ~]#

Centos 7.6 cgroups:

[root@centos7 ~]#cat /etc/redhat-release CentOS Linux release 7.6.1810 (Core) [root@centos7 ~]#grep CGROUP /boot/config-3.10.0-957.el7.x86_64 CONFIG_CGROUPS=y # CONFIG_CGROUP_DEBUG is not set CONFIG_CGROUP_FREEZER=y CONFIG_CGROUP_PIDS=y CONFIG_CGROUP_DEVICE=y CONFIG_CGROUP_CPUACCT=y CONFIG_CGROUP_HUGETLB=y CONFIG_CGROUP_PERF=y CONFIG_CGROUP_SCHED=y CONFIG_BLK_CGROUP=y # CONFIG_DEBUG_BLK_CGROUP is not set CONFIG_NETFILTER_XT_MATCH_CGROUP=m CONFIG_NET_CLS_CGROUP=y CONFIG_NETPRIO_CGROUP=y

ubuntu cgroups:

[root@ubuntu1804 ~]#grep CGROUP /boot/config-4.15.0-29-generic CONFIG_CGROUPS=y CONFIG_BLK_CGROUP=y # CONFIG_DEBUG_BLK_CGROUP is not set CONFIG_CGROUP_WRITEBACK=y CONFIG_CGROUP_SCHED=y CONFIG_CGROUP_PIDS=y CONFIG_CGROUP_RDMA=y CONFIG_CGROUP_FREEZER=y CONFIG_CGROUP_HUGETLB=y CONFIG_CGROUP_DEVICE=y CONFIG_CGROUP_CPUACCT=y CONFIG_CGROUP_PERF=y CONFIG_CGROUP_BPF=y # CONFIG_CGROUP_DEBUG is not set CONFIG_SOCK_CGROUP_DATA=y CONFIG_NETFILTER_XT_MATCH_CGROUP=m CONFIG_NET_CLS_CGROUP=m CONFIG_CGROUP_NET_PRIO=y CONFIG_CGROUP_NET_CLASSID=y

cgroups 中内存模块:

[root@ubuntu1804 ~]#grep MEMCG /boot/config-4.15.0-29-generic CONFIG_MEMCG=y CONFIG_MEMCG_SWAP=y # CONFIG_MEMCG_SWAP_ENABLED is not set CONFIG_SLUB_MEMCG_SYSFS_ON=y

cgroups 具体实现

- blkio: 块设备IO限制

- cpu: 使用调度程序为 cgroup 任务提供 cpu 的访问

- cpuacct: 产生 cgroup 任务的 cpu 资源报告

- cpuset: 如果是多核心的 cpu,这个子系统会为 cgroup 任务分配单独的 cpu 和内存

- devices: 允许或拒绝 cgroup 任务对设备的访问

- freezer: 暂停和恢复 cgroup 任务

- memory: 设置每个 cgroup 的内存限制以及产生内存资源报告

- net_cls: 标记每个网络包以供 cgroup 方便使用

- ns: 命名空间子系统

- perf_event: 增加了对每 group 的监测跟踪的能力,可以监测属于某个特定的 group 的所有线程以及运行在特定CPU上的线程

查看系统 cgroups

[root@ubuntu1804 ~]#ll /sys/fs/cgroup/ total 0 drwxr-xr-x 15 root root 380 Jan 22 16:20 ./ drwxr-xr-x 10 root root 0 Jan 22 16:20 ../ dr-xr-xr-x 5 root root 0 Jan 22 16:20 blkio/ lrwxrwxrwx 1 root root 11 Jan 22 16:20 cpu -> cpu,cpuacct/ lrwxrwxrwx 1 root root 11 Jan 22 16:20 cpuacct -> cpu,cpuacct/ dr-xr-xr-x 5 root root 0 Jan 22 16:20 cpu,cpuacct/ dr-xr-xr-x 3 root root 0 Jan 22 16:20 cpuset/ dr-xr-xr-x 5 root root 0 Jan 22 16:20 devices/ dr-xr-xr-x 3 root root 0 Jan 22 16:20 freezer/ dr-xr-xr-x 3 root root 0 Jan 22 16:20 hugetlb/ dr-xr-xr-x 5 root root 0 Jan 22 16:20 memory/ lrwxrwxrwx 1 root root 16 Jan 22 16:20 net_cls -> net_cls,net_prio/ dr-xr-xr-x 3 root root 0 Jan 22 16:20 net_cls,net_prio/ lrwxrwxrwx 1 root root 16 Jan 22 16:20 net_prio -> net_cls,net_prio/ dr-xr-xr-x 3 root root 0 Jan 22 16:20 perf_event/ dr-xr-xr-x 5 root root 0 Jan 22 16:20 pids/ dr-xr-xr-x 2 root root 0 Jan 22 16:20 rdma/ dr-xr-xr-x 6 root root 0 Jan 22 16:20 systemd/ dr-xr-xr-x 5 root root 0 Jan 22 16:20 unified/ [root@ubuntu1804 ~]#cat /sys/fs/cgroup/cpu/docker/5dee9be9afdbab8c2f6c4c5eb0f956c9579efe93110daf638f8fd15f43d961e2/cpuacct.usage 4751336886 [root@ubuntu1804 ~]#cat /sys/fs/cgroup/memory/docker/5dee9be9afdbab8c2f6c4c5eb0f956c9579efe93110daf638f8fd15f43d961e2/cpuacct.usage [root@ubuntu1804 ~]#cat /sys/fs/cgroup/memory/docker/5dee9be9afdbab8c2f6c4c5eb0f956c9579efe93110daf638f8fd15f43d961e2/memory.limit_in_bytes 9223372036854771712 [root@ubuntu1804 ~]#cat /sys/fs/cgroup/memory/docker/5dee9be9afdbab8c2f6c4c5eb0f956c9579efe93110daf638f8fd15f43d961e2/memory.max_usage_in_bytes 79278080

容器管理工具

有了以上的chroot、namespace、cgroups就具备了基础的容器运行环境,但是还需要有相应的容器创建与删除的管理工具、以及怎么样把容器运行起来、容器数据怎么处理、怎么进行启动与关闭等问题需要解决,于是容器管理技术出现了。目前主要是使用docker,早期使用 LXC

LXC

LXC: Linux Container。可以提供轻量级的虚拟化功能,以便隔离进程和资源,包括一系列容器的管理工具软件,如,lxc-create,lxc-start,lxc-attach等,但这技术功能不完善,目前较少使用

官方网站: https://linuxcontainers.org/

案例: Ubuntu安装 和使用 LXC

[root@ubuntu1804 ~]#apt install lxc lxd [root@ubuntu1804 ~]#lxc-checkconfig #检查内核对lcx的支持状况,必须全部为lcx Kernel configuration not found at /proc/config.gz; searching... Kernel configuration found at /boot/config-4.15.0-29-generic --- Namespaces --- Namespaces: enabled Utsname namespace: enabled Ipc namespace: enabled Pid namespace: enabled User namespace: enabled Network namespace: enabled ...... [root@ubuntu1804 ~]#lxc-create -t download --name alpine1 -- --dist alpine --release 3.9 --arch amd64 Setting up the GPG keyring Downloading the image index Downloading the rootfs Downloading the metadata The image cache is now ready Unpacking the rootfs [root@ubuntu1804 ~]#lxc-start alpine1 #启动lxc容器 [root@ubuntu1804 ~]#lxc-attach alpine1 #进入lxc容器 ~ # ifconfig eth0 Link encap:Ethernet HWaddr 00:16:3E:DF:9E:45 lo Link encap:Local Loopback ~ # uname -r 4.15.0-29-generic ~ # uname -a Linux alpine12 4.15.0-29-generic #31-Ubuntu SMP Tue Jul 17 15:39:52 UTC 2018x86_64 Linux ~ # cat /etc/issue Welcome to Alpine Linux 9 Kernel \r on an \m (\l) ~ # exit

命令选项说明:

-t 模板: -t 选项后面跟的是模板,模式可以认为是一个原型,用来说明需要一个什么样的容器(比如容器里面需不需要有vim, apache等软件).模板实际上就是一个脚本文件(位于/usr/share/lxc/templates目录),我们这里指定download模板(lxc-create会调用lxc-download脚本,该脚本位于刚说的模板目录中)是说明我们目前没有自己模板,需要下载官方的模板 --name 容器名称: 为创建的容器命名 -- : --用来说明后面的参数是传递给download脚本的,告诉脚本需要下载什么样的模板 --dist 操作系统名称: 指定操作系统 --release 操作系统: 指定操作系统,可以是各种Linux的变种 --arch 架构: 指定架构,是x86还是arm,是32位还是64位1.1.7.3 pouch

lxc启动容器依赖于模板,清华模板源: https://mirrors.tuna.tsinghua.edu.cn/help/lxc-images/ ,但是做模板相对较难,需要手动一步步创构建文件系统、准备基础目录及可执行程序等,而且在大规模使用容器的场景很难横向扩展,另外后期代码升级也需要重新从头构建模板,基于以上种种原因便有了docker

docker

Docker 相当于增强版的LXC,功能更为强大和易用,也是当前最主流的容器前端管理工具

Docker 先启动一个容器也需要一个外部模板,也称为镜像,docke的镜像可以保存在一个公共的地方共享使用,只要把镜像下载下来就可以使用,最主要的是可以在镜像基础之上做自定义配置并且可以再把其提交为一个镜像,一个镜像可以被启动为多个容器。

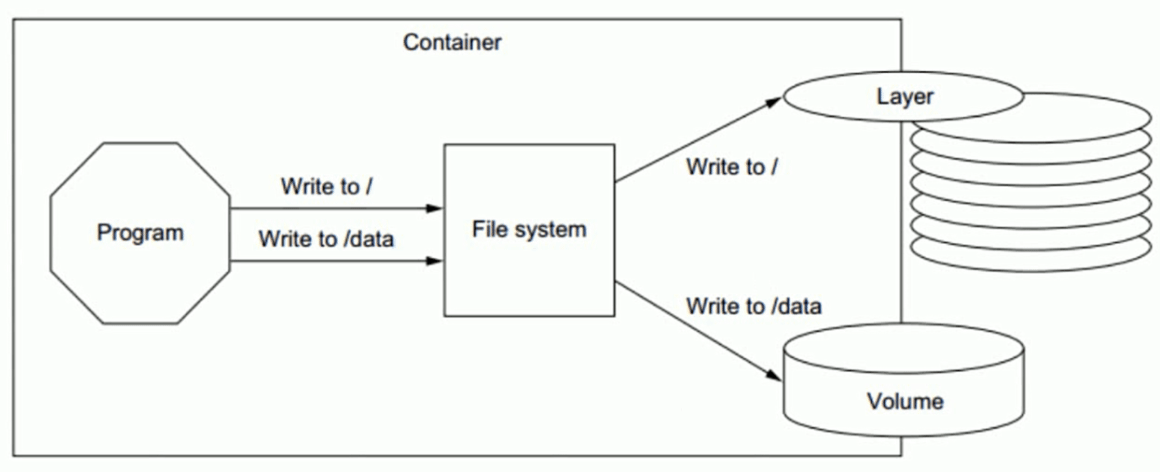

Docker的镜像是分层的,镜像底层为库文件且只读层即不能写入也不能删除数据,从镜像加载启动为一个容器后会生成一个可写层,其写入的数据会复制到宿主机上对应容器的目录,但是容器内的数据在删除容器后也会被随之删除。

pouch

项目网点: https://github.com/alibaba/pouch

Pouch (小袋子)起源于 2011 年,并于2017年11月19日上午,在中国开源年会现场,阿里巴巴正式开源了基于 Apache 2.0 协议的容器技术 Pouch。Pouch 是一款轻量级的容器技术,拥有快速高效、可移植性高、资源占用少等特性,主要帮助阿里更快的做到内部业务的交付,同时提高超大规模下数据中心的物理资源利用率

目前的容器方案大多基于 Linux 内核提供的 cgroup 和 namespace 来实现隔离,然后这样轻量级方案

存在弊端:

- 容器间,容器与宿主间,共享同一个内核

- 内核实现的隔离资源,维度不足

面对如此的内核现状,阿里巴巴采取了三个方面的工作,来解决容器的安全问题:

- 用户态增强容器的隔离维度,比如网络带宽、磁盘使用量等

- 给内核提交 patch,修复容器的资源可见性问题,cgroup 方面的 bug

- 实现基于 Hypervisor 的容器,通过创建新内核来实现容器隔离

Podman

虽然目前 Docker 是管理 Linux 容器最好的工具,注意没有之一,但是podman的横空出现即将改变这一点

什么是Podman?

Podman即Pod Manager tool,从名称上可以看出和kubernets的pod的密切联系,不过就其功能来说,简而言之: `alias docker = podman` ,是CentOS 8 新集成的功能,或许不久的未来会代替docker

Podman是一个 为 Kubernetes 而生的开源的容器管理工具,原来是 CRI-O(即容器运行时接口CRI 和开放容器计划OCI) 项目的一部分,后来被分离成一个单独的项目叫 libpod。其可在大多数Linux平台上使用,它是一种无守护程序的容器引擎,用于在Linux系统上开发,管理和运行任何符合OpenContainer Initiative(OCI)标准的容器和容器镜像。

Podman 提供了一个与Docker兼容的命令行前端,Podman 里面87%的指令都和Docker CLI 相同,因此可以简单地为Docker CLI别名,即“ alias docker = podman”,事实上,podman使用的一些库也是docker的一部分。

官网地址: https://podman.io/

项目地址: https://github.com/containers/libpod

Podman 和docker不同之处

- docker 需要在系统上运行一个守护进程(docker daemon),这会产生一定的开销,而podman 不需要

- 启动容器的方式不同:

- docker cli 命令通过API跟 Docker Engine(引擎) 交互告诉它我想创建一个container,然后docker Engine 才会调用 OCI container runtime(runc) 来启动一个container。这代表container的process(进程)不会是 Docker CLI 的 child process(子进程) ,而是 DockerEngine 的 child process 。

- Podman 是直接给 OCI containner runtime(runc) 进行交互来创建container的,所以container process 直接是 podman 的 child process 。

- docker cli 命令通过API跟 Docker Engine(引擎) 交互告诉它我想创建一个container,然后docker Engine 才会调用 OCI container runtime(runc) 来启动一个container。这代表container的process(进程)不会是 Docker CLI 的 child process(子进程) ,而是 DockerEngine 的 child process 。

- 因为docke有docker daemon,所以docker启动的容器支持 –restart 策略,但是podman不支持

- docker需要使用root用户来创建容器。 这可能会产生安全风险,尤其是当用户知道docker run命令的–privileged选项时。podman既可以由root用户运行,也可以由非特权用户运行

- docker在Linux上作为守护进程运行扼杀了容器社区的创新。 如果要更改容器的工作方式,则需要更改docker守护程序并将这些更改推送到上游。 没有守护进程,容器基础结构更加模块化,更容易进行更改。 podman的无守护进程架构更加灵活和安全。

Docker 的优势

- 快速部署: 短时间内可以部署成百上千个应用,更快速交付到线上

- 高效虚拟化: 不需要额外hypervisor支持,基于linux内核实现应用虚拟化,相比虚拟机大幅提高性能和效率

- 节省开支: 提高服务器利用率,降低IT支出

- 简化配置: 将运行环境打包保存至容器,使用时直接启动即可

- 环境统一: 将开发,测试,生产的应用运行环境进行标准化和统一,减少环境不一样带来的各种问题

- 快速迁移和扩展: 可实现跨平台运行在物理机、虚拟机、公有云等环境,良好的兼容性可以方便将应用从A宿主机迁移到B宿主机,甚至是A平台迁移到B平台

- 更好的实现面向服务的架构,推荐一个容器只运行一个应用,实现分布的应用模型,可以方便的进行横向扩展,符合开发中高内聚,低耦合的要求,减少不同服务之间的相互影响

Docker 的缺点

- 多个容器共用宿主机的内核,各应用之间的隔离不如虚拟机彻底

- 由于和宿主机之间的进程也是隔离的,需要进入容器查看和调试容器内进程等资源,变得比较困难和繁琐

- 如果容器内进程需要查看和调试,需要在每个容器内都需要安装相应的工具,这也造成存储空间的重复浪费

容器的核心技术

容器规范

OCI 官网:https://opencontainers.org/

容器技术除了的docker之外,还有coreOS的rkt,还有阿里的Pouch,为了保证容器生态的标准性和健康可持续发展,包括Linux 基金会、Docker、微软、红帽谷歌和、IBM、等公司在2015年6月共同成立了一个叫Open Container Initiative(OCI)的组织,其目的就是制定开放的标准的容器规范,目前OCI一共发布了两个规范,分别是runtime spec和 image format spec,有了这两个规范,不同的容器公司开发的容器只要兼容这两个规范,就可以保证容器的可移植性和相互可操作性。

容器 runtime

runtime是真正运行容器的地方,因此为了运行不同的容器runtime需要和操作系统内核紧密合作相互在支持,以便为容器提供相应的运行环境

runtime 类型:

- Lxc: linux上早期的runtime,在 2013 年 Docker 刚发布的时候,就是采用lxc作为runtime, Docker把 LXC 复杂的容器创建与使用方式简化为 Docker 自己的一套命令体系。随着Docker的发展,原有的LXC不能满足Docker的需求,比如跨平台功能

- Libcontainer: 随着 Docker 的不断发展,重新定义容器的实现标准,将底层实现都抽象化到

- Libcontainer 的接口。这就意味着,底层容器的实现方式变成了一种可变的方案,无论是使用namespace、cgroups 技术抑或是使用 systemd 等其他方案,只要实现了 Libcontainer 定义的一组接口,Docker 都可以运行。这也为 Docker 实现全面的跨平台带来了可能。

- runc: 早期libcontainer是Docker公司控制的一个开源项目,OCI的成立后,Docker把libcontainer项目移交给了OCI组织,runC就是在libcontainer的基础上进化而来,目前Docker默认的runtime,runc遵守OCI规范

- rkt: 是CoreOS开发的容器runtime,也符合OCI规范,所以使用rktruntime也可以运行Docker容器

范例: 查看docker的 runtime

[root@ubuntu1804 ~]#docker info Runtimes: runc #Runtimes Default Runtime: runc #runtime

容器管理工具

管理工具连接runtime与用户,对用户提供图形或命令方式操作,然后管理工具将用户操作传递给runtime执行。

- lxc 是lxd 的管理工具

- Runc的管理工具是docker engine,docker engine包含后台deamon和cli两部分,大家经常提到的Docker就是指的docker engine

- Rkt的管理工具是rkt cli

容器定义工具

容器定义工具允许用户定义容器的属性和内容,以方便容器能够被保存、共享和重建。

Docker image: 是docker 容器的模板,runtime依据docker image创建容器

Dockerfile: 包含N个命令的文本文件,通过dockerfile创建出docker image

ACI(App container image): 与docker image类似,是CoreOS开发的rkt容器的镜像格式

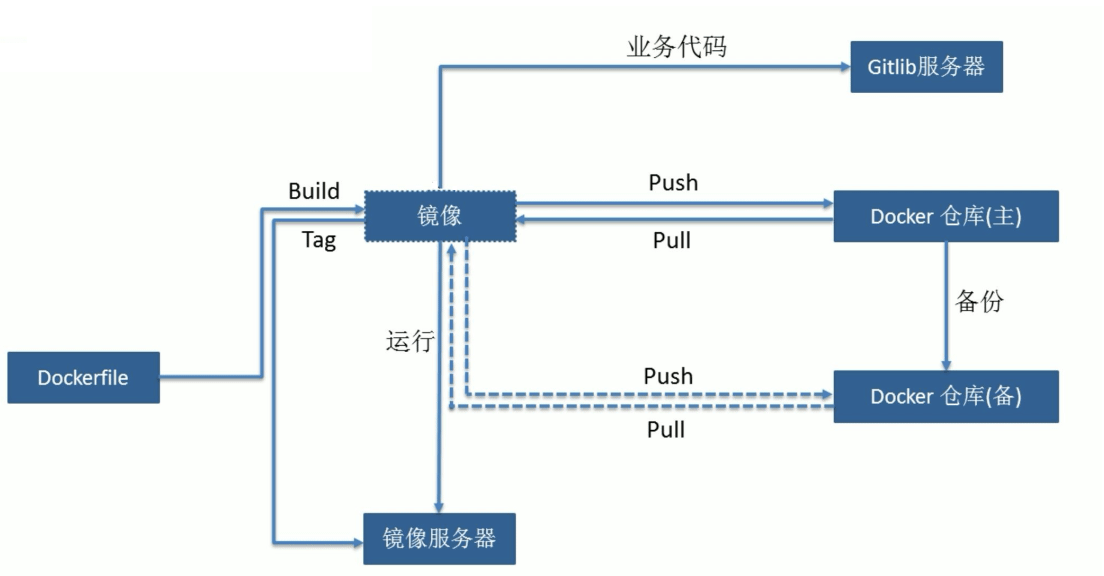

镜像仓库 Registry

- 统一保存镜像而且是多个不同镜像版本的地方,叫做镜像仓库

- Docker hub: docker官方的公共仓库,已经保存了大量的常用镜像,可以方便大家直接使用

- 阿里云,网易等第三方镜像的公共仓库

- Image registry: docker 官方提供的私有仓库部署工具,无web管理界面,目前使用较少

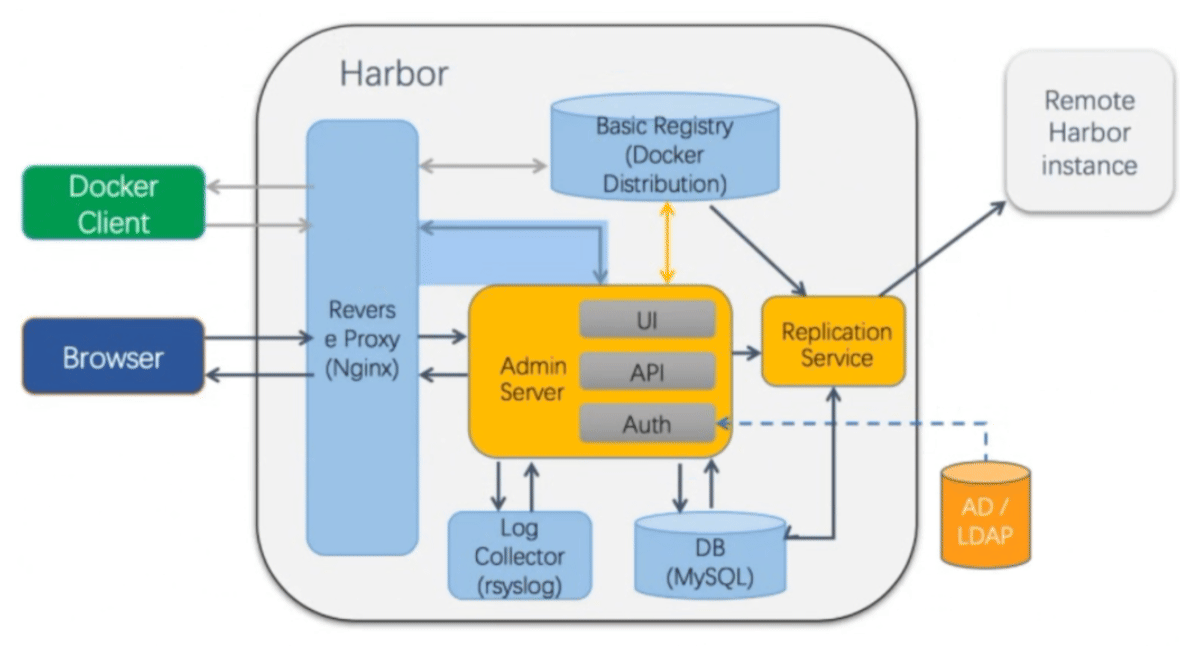

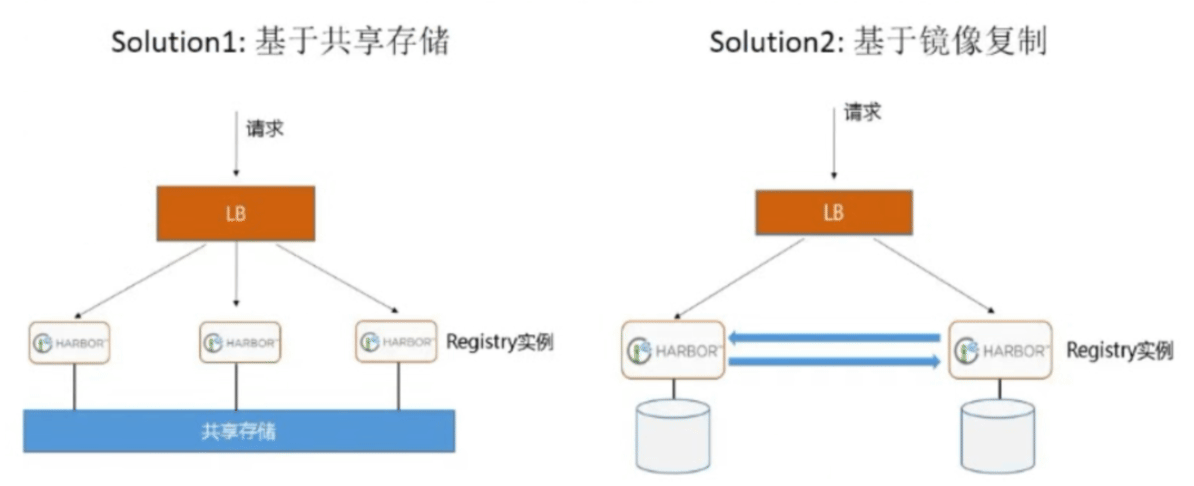

- Harbor: vmware 提供的自带web界面自带认证功能的镜像私有仓库,目前有很多公司使用

容器编排工具

当多个容器在多个主机运行的时候,单独管理容器是相当复杂而且很容易出错,而且也无法实现某一台主机宕机后容器自动迁移到其他主机从而实现高可用的目的,也无法实现动态伸缩的功能,因此需要有一种工具可以实现统一管理、动态伸缩、故障自愈、批量执行等功能,这就是容器编排引擎

容器编排通常包括容器管理、调度、集群定义和服务发现等功能

- Docker compose : docker 官方实现单机的容器的编排工具

- Docker swarm: docker 官方开发的容器编排引擎,支持overlay network

- Mesos+Marathon: Mesos是Apache下的开源分布式资源管理框架,它被称为是分布式系统的内核。Mesos最初是由加州大学伯克利分校的AMPLab开发的,后在Twitter得到广泛使用。通用的集群组员调度平台,mesos(资源分配)与marathon(容器编排平台)一起提供容器编排引擎功能

- Kubernetes: google领导开发的容器编排引擎,内部项目为Borg,且其同时支持 docker 和CoreOS,当前已成为容器编排工具事实上的标准

docker(容器)的依赖技术

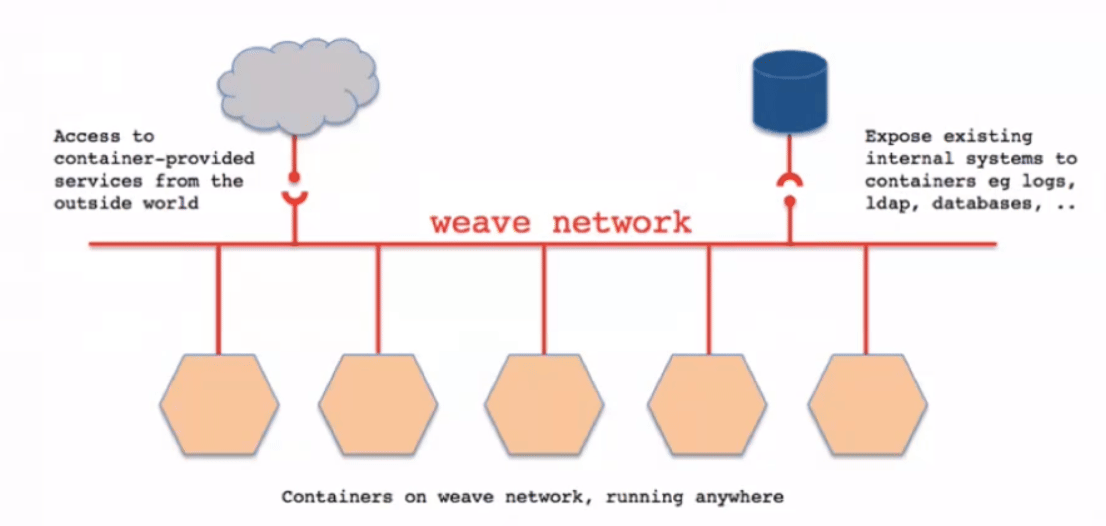

- 容器网络:

docker自带的网络docker network仅支持管理单机的容器网络,当多主机运行的时候需要使用第三方开源网络,例如:calico、flannel等

- 服务发现:

容器的动态扩容特性决定了容器IP也会随之变化,因此需要有一种机制开源自动识别并将用户请求动态转发到新创建的容器上,kubernetes自带服务发现功能,需要结合kube-dns服务解析内部域名

- 容器监控:

可以通过原生命令docker ps/top/stats 查看容器运行状态,另外也可以使用Prometheus 、heapster等第三方监控工具监控容器的运行状态

- 数据管理:

容器的动态迁移会导致其在不同的Host之间迁移,因此如何保证与容器相关的数据也能随之迁移或随时访问,可以使用逻辑卷/存储挂载等方式解决

- 日志收集:

docker 原生的日志查看工具docker logs,但是容器内部的日志需要通过ELK等专门的日志收集分析和展示工具进行处理

Docker安装及基础命令介绍

安装和删除方法

安装文档参考

Ubuntu 安装和删除Docker

官方文档: https://docs.docker.com/install/linux/docker-ce/ubuntu/

Ubuntu 14.04/16.04/18.04 安装docker

# step 1: 安装必要的一些系统工具 sudo apt-get update sudo apt-get -y install apt-transport-https ca-certificates curl softwareproperties-common # step 2: 安装GPG证书 curl -fsSL https://mirrors.aliyun.com/docker-ce/linux/ubuntu/gpg | sudo apt-key add - # Step 3: 写入软件源信息 sudo add-apt-repository "deb [arch=amd64] https://mirrors.aliyun.com/dockerce/linux/ubuntu $(lsb_release -cs) stable" # Step 4: 更新并安装Docker-CE sudo apt-get -y update sudo apt-get -y install docker-ce # 安装指定版本的Docker-CE: # Step 1: 查找Docker-CE的版本: apt-cache madison docker-ce docker-ce | 5:19.03.5~3-0~ubuntu-bionic | https://mirrors.aliyun.com/dockerce/linux/ubuntu bionic/stable amd64 Packages docker-ce | 18.06.3~ce~3-0~ubuntu | https://mirrors.aliyun.com/dockerce/linux/ubuntu bionic/stable amd64 Packages # Step 2: 安装指定版本的Docker-CE: (VERSION例如上面的5:17.03.1~ce-0~ubuntu-xenial) sudo apt-get -y install docker-ce=[VERSION] docker-ce-cli=[VERSION] #示例:指定版本安装 apt-get -y install docker-ce=5:18.09.9~3-0~ubuntu-bionic docker-cecli=5:18.09.9~3-0~ubuntu-bionic

删除docker

[root@ubuntu ~]#apt purge docker-ce [root@ubuntu ~]#rm -rf /var/lib/docker

CentOS 安装和删除Docker

官方文档: https://docs.docker.com/install/linux/docker-ce/centos/

CentOS 6 因内核太旧,即使支持安装docker,但会有各种问题,不建议安装

CentOS 7 的 extras 源虽然可以安装docker,但包比较旧,建议从官方源或镜像源站点下载安装

Kali Linux上安装docker

官方文档:https://www.kali.org/docs/containers/installing-docker-on-kali/#installing-docker-ce-on-kali-linux

Kali Linux 基于 Debian,因此我们需要使用 Debian 的当前稳定版本。

#使用debian稳定版docker源 echo "deb [arch=$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.gpg] https://download.docker.com/linux/debian bookworm stable" | \ sudo tee /etc/apt/sources.list.d/docker.list #导入 gpg 密钥 curl -fsSL https://download.docker.com/linux/debian/gpg | sudo gpg --dearmor -o /etc/apt/keyrings/docker.gpg #安装最新版本的 docker-ce sudo apt update sudo apt install -y docker-ce docker-ce-cli containerd.io #安装docker插件 sudo apt install -y docker-buildx-plugin docker-compose-plugin #将自己添加到 docker 组,以便使用 docker 而不需要 sudo. sudo usermod -aG docker $USER #需要 注销并重新登录

EndeavourOS 安装docker

提前确认系统是否有bridge模块,没有安装

lsmod |grep bridge #安装模块 sudo pacman -S linux-headers sudo pacman -Syu sudo pacman -S linux sudo pacman -S mkinitcpio sudo mkinitcpio -P reboot #重启 sudo modprobe bridge sudo modprobe br_netfilter

EndeavourOS 使用 Arch Linux 的包管理器 pacman,直接执行以下命令安装 Docker

sudo pacman -S docker sudo systemctl start docker sudo systemctl enable docker #验证 docker version docker info sudo pacman -S docker-compose

Linux 二进制安装

本方法适用于无法上网或无法通过包安装方式安装的主机上安装docker

安装文档: https://docs.docker.com/install/linux/docker-ce/binaries/

docker 程序环境

环境配置文件:

/etc/sysconfig/docker-network /etc/sysconfig/docker-storage /etc/sysconfig/docker

Unit File:

/usr/lib/systemd/system/docker.service

docker-ce 配置文件

/etc/containers/registries.conf

其它配置

mkdir -p /etc/docker/ cat>/etc/docker/daemon.json<<EOF { "registry-mirrors": [ "https://fz5yth0r.mirror.aliyuncs.com", "http://hub-mirror.c.163.com/", "https://docker.mirrors.ustc.edu.cn/", "https://registry.docker-cn.com" ], "data-root":"/data/docker", "storage-opts": [ "overlay2.override_kernel_check=true" ], "log-driver": "json-file", "log-opts": { "max-size": "100m", "max-file": "3" } } EOF

docker 命令帮助

docker 命令是最常使用的docker 客户端命令,其后面可以加不同的参数以实现不同的功能

docker 命令格式

docker [OPTIONS] COMMAND COMMAND分为 Management Commands #指定管理的资源对象类型,较新的命令用法,将命令按资源类型进行分类,方便使用 Commands #对不同资源操作的命令不分类,使用容易产生混乱

命令有很多子命令,可以用下面方法查看帮助

#docker 命令帮助 man docker docker docker --help #docker 子命令帮助 man docker-COMMAND docker COMMAND --help [root@ubuntu1804 ~]#docker --help

查看 Docker 相关信息

查看 docker 版本

docker version

查看 docker 详解信息

[root@ubuntu1804 ~]#docker info Client: Debug Mode: false #client 端是否开启 debug Server: Containers: 2 #当前主机运行的容器总数 Running: 0 #有几个容器是正在运行的 Paused: 0 #有几个容器是暂停的 Stopped: 2 #有几个容器是停止的 Images: 4 #当前服务器的镜像数 Server Version: 19.03.5 #服务端版本 Storage Driver: overlay2 #正在使用的存储引擎 Backing Filesystem: extfs #后端文件系统,即服务器的磁盘文件系统 Supports d_type: true #是否支持 d_type Native Overlay Diff: true #是否支持差异数据存储 Logging Driver: json-file #日志类型 Cgroup Driver: cgroupfs #Cgroups 类型 Plugins: #插件 Volume: local #卷 Network: bridge host ipvlan macvlan null overlay # overlay 跨主机通信 Log: awslogs fluentd gcplogs gelf journald json-file local logentries splunk syslog # 日志类型 Swarm: inactive #是否支持 swarm Runtimes: runc #已安装的容器运行时 Default Runtime: runc #默认使用的容器运行时 Init Binary: docker-init #初始化容器的守护进程,即 pid 为 1 的进程 containerd version: b34a5c8af56e510852c35414db4c1f4fa6172339 #版本 runc version: 3e425f80a8c931f88e6d94a8c831b9d5aa481657 #runc 版本 init version: fec3683 #init 版本 Security Options: #安全选项 apparmor #安全模块,https://docs.docker.com/engine/security/apparmor/ seccomp #安全计算模块,即制容器操作, https://docs.docker.com/engine/security/seccomp/ Profile: default #默认的配置文件 Kernel Version: 4.15.0-29-generic #宿主机内核版本 Operating System: Ubuntu 18.04.1 LTS #宿主机操作系统 OSType: linux #宿主机操作系统类型 Architecture: x86_64 #宿主机架构 CPUs: 1 #宿主机 CPU 数量 Total Memory: 962MiB #宿主机总内存 Name: ubuntu1804.xxx.org #宿主机 hostname ID: IZHJ:WPIN:BRMC:XQUI:VVVR:UVGK:NZBM:YQXT:JDWB:33RS:45V7:SQWJ #宿主机 ID Docker Root Dir: /var/lib/docker #宿主机关于docker数据的保存目录 Debug Mode: false #server 端是否开启 debug Registry: https://index.docker.io/v1/ #仓库路径 Labels: Experimental: false #是否测试版 Insecure Registries: 127.0.0.0/8 : #非安全的镜像仓库 Registry Mirrors: https://si7y70hh.mirror.aliyuncs.com/ #镜像仓库 Live Restore Enabled: false #是否开启活动重启 (重启docker-daemon 不关闭容器 ) WARNING: No swap limit support #系统警告信息 (没有开启 swap 资源限制 )

范例: 解决上述SWAP报警提示

官方文档: https://docs.docker.com/install/linux/linux-postinstall/#your-kernel-does-not-support-cgroup-swap-limit-capabilities

[root@ubuntu1804 ~]#docker info ...... WARNING: No swap limit support [root@ubuntu1804 ~]# vim /etc/default/grub GRUB_DEFAULT=0 GRUB_TIMEOUT_STYLE=hidden GRUB_TIMEOUT=2 GRUB_DISTRIBUTOR=`lsb_ release -i -s 2> /dev/null || echo Debian` GRUB_CMDLINE_LINUX_DEFAULT="" GRUB_CMDLINE_LINUX="net.ifnames=0 biosdevname=0 swapaccount=1" #修改此行 [root@ubuntu1804 ~]# update-grub [root@ubuntu1804 ~]# reboot

docker 存储引擎

官方文档关于存储引擎的相关文档:

https://docs.docker.com/storage/storagedriver/

https://docs.docker.com/storage/storagedriver/select-storage-driver/

- AUFS:

(Advanced Mult-Layered Unification Filesystem,版本2之前旧称AnotherUnionFS)是一种 Union FS ,是文件级的存储驱动。Aufs是之前的UnionFS的重新实现,2006年由JunjiroOkajima开发所谓 UnionFS就是把不同物理位置的目录合并 mount 到同一个目录中。简单来说就是支持将不同目录挂载到一个虚拟文件系统下的。这种可以层层地叠加修改文件。无论底下有多少都是只读的,最上系统可写的。当需要修改一个文件时, AUFS 创建该文件的一个副本,使用 CoW 将文件从只读层复制到可写进行修改,结果也保存在Docker 中,底下的只读层就是 image,可写层就是Container

aufs 被拒绝合并到主线 Linux 。其代码被批评为"dense, unreadable, uncommented 密集、不可读、未注释"。 相反,OverlayFS被合并到 Linux 内核中。在多次尝试将 aufs 合并到主线内核失败后,作者放弃了

AUFS 是 Docker 18.06 及更早版本的首选存储驱动程序,在内核 3.13 上运行 Ubuntu 14.04 时不支持 overlay2

- Overlay:

一种 Union FS 文件系统, Linux 内核 3.18 后支持Overlay2: Overlay 的升级版,到目前为止,所有 Linux 发行版推荐使用的存储类 型,也是docker默认使用的存储引擎为overlay2,需要磁盘分区支持d-type功能,因此需要系统磁盘的额外支持,相对AUFS来说Overlay2 有以下优势: 更简单地设计; 从3.18开始就进入了Linux内核主线;资源消耗更少

- devicemapper:

因为CentOS 7.2和RHEL 7.2 的之前版本内核版本不支持 overlay2,默认使用的存储驱动程序,最大数据容量只支持100GB且性能不佳,当前较新版本的CentOS 已经支持overlay2, 因此推荐使用 overlay2,另外此存储引擎已在Docker Engine 18.09中弃用

- ZFS

(Sun -2005)/btrfs(Oracle-2007): 目前没有广泛使用

- vfs:

用于测试环境,适用于无法使用 copy-on -writewrite 时的情况。 此存储驱动程序的性能很差,通常不建议用于生产

修改存储引擎参考文档:

https://docs.docker.com/storage/storagedriver/overlayfs-driver/

范例: 在CentOS7.2修改存储引擎

[root@centos7 ~]#vim /lib/systemd/system/docker.service ..... ExecStart=/usr/bin/dockerd -s overlay2 -H fd:// -- containerd=/run/containerd/containerd.sock ...... #创建新的xfs分区,添加ftype特性,否则默认无法启动docker服务 [root@centos7 ~]#mkfs.xfs -n ftype=1 /dev/sdb [root@centos7 ~]#mount /dev/sdb /var/lib/docker [root@centos7 ~]#systemctl daemon-reload [root@centos7 ~]#systemctl restart docker

注意:修改存储引擎会导致所有容器丢失,所以先备份再修改

Docker官方推荐首选存储引擎为overlay2,其次为devicemapper,但是devicemapper存在使用空间方面的一些限制,虽然可以通过后期配置解决,但是官方依然推荐使用overlay2,以下是生产故障事例:

https://www.cnblogs.com/youruncloud/p/5736718.html

如果docker数据目录是一块单独的磁盘分区而且是xfs格式的,那么需要在格式化的时候加上参数-n ftype=1(启用此功能表示节点文件类型存入在目录结构中), 示例: `mkfs.xfs -n ftype=1 devname` ,否则后期在无法启动容器,并会报错不支持 d_type

注意: ext4文件系统无需此d_type特性

范例: aufs 实现联合文件系统挂载

[root@ubuntu1804 ~]#cat /proc/filesystems ... ... nodev overlay nodev aufs [root@ubuntu1804 ~]#grep -i aufs /boot/config-4.15.0-29-generic CONFIG_AUFS_FS=m CONFIG_AUFS_BRANCH_MAX_127=y # CONFIG_AUFS_BRANCH_MAX_511 is not set # CONFIG_AUFS_BRANCH_MAX_1023 is not set # CONFIG_AUFS_BRANCH_MAX_32767 is not set CONFIG_AUFS_SBILIST=y # CONFIG_AUFS_HNOTIFY is not set CONFIG_AUFS_EXPORT=y CONFIG_AUFS_INO_T_64=y CONFIG_AUFS_XATTR=y # CONFIG_AUFS_FHSM is not set # CONFIG_AUFS_RDU is not set CONFIG_AUFS_DIRREN=y # CONFIG_AUFS_SHWH is not set # CONFIG_AUFS_BR_RAMFS is not set # CONFIG_AUFS_BR_FUSE is not set范例: 修改存储引擎 CONFIG_AUFS_BR_HFSPLUS=y CONFIG_AUFS_BDEV_LOOP=y # CONFIG_AUFS_DEBUG is not set [root@ubuntu1804 ~]#mkdir dir{1,2} [root@ubuntu1804 ~]#echo here is dir1 > dir1/file1 [root@ubuntu1804 ~]#echo here is dir2 > dir2/file2 [root@ubuntu1804 ~]#mkdir /data/aufs [root@ubuntu1804 ~]#mount -t aufs -o br=/root/dir1=ro:/root/dir2=rw none /data/aufs [root@ubuntu1804 ~]#ll /data/aufs/ total 16 drwxr-xr-x 4 root root 4096 Jan 25 16:22 ./ drwxr-xr-x 4 root root 4096 Jan 25 16:22 ../ -rw-r--r-- 1 root root 13 Jan 25 16:22 file1 -rw-r--r-- 1 root root 13 Jan 25 16:22 file2 [root@ubuntu1804 ~]#cat /data/aufs/file1 here is dir1 [root@ubuntu1804 ~]#cat /data/aufs/file2 here is dir2 [root@ubuntu1804 ~]#df -T Filesystem Type 1K-blocks Used Available Use% Mounted on udev devtmpfs 462560 0 462560 0% /dev tmpfs tmpfs 98512 10296 88216 11% /run /dev/sda2 ext4 47799020 2770244 42570972 7% / tmpfs tmpfs 492552 0 492552 0% /dev/shm tmpfs tmpfs 5120 0 5120 0% /run/lock tmpfs tmpfs 492552 0 492552 0% /sys/fs/cgroup /dev/sda3 ext4 19091540 45084 18053588 1% /data /dev/sda1 ext4 944120 77112 801832 9% /boot tmpfs tmpfs 98508 0 98508 0% /run/user/0 none aufs 47799020 2770244 42570972 7% /data/aufs [root@ubuntu1804 ~]#echo write to file1 >> /data/aufs/file1 -bash: /data/aufs/file1: Read-only file system [root@ubuntu1804 ~]#echo write to file2 >> /data/aufs/file2 [root@ubuntu1804 ~]#cat /data/aufs/file1 here is dir1 [root@ubuntu1804 ~]#cat /data/aufs/file2 here is dir2 write to file2 [root@ubuntu1804 ~]#umount /data/aufs [root@ubuntu1804 ~]#mv dir1/file1 dir1/file2 [root@ubuntu1804 ~]#cat dir1/file2 here is dir1 [root@ubuntu1804 ~]#cat dir2/file2 here is dir2 write to file2 [root@ubuntu1804 ~]#mount -t aufs -o br=/root/dir1=ro:/root/dir2=rw none /data/aufs [root@ubuntu1804 ~]#ls /data/aufs -l total 4 -rw-r--r-- 1 root root 13 Jan 25 16:22 file2 [root@ubuntu1804 ~]#cat /data/aufs/file2 here is dir1 [root@ubuntu1804 ~]#

范例: 修改存储引擎

[root@ubuntu1804 ~]#docker info |grep "Storage Driver" Storage Driver: overlay2 [root@ubuntu1804 ~]#systemctl stop docker [root@ubuntu1804 ~]#cat /etc/docker/daemon.json { "storage-driver": "aufs" } [root@ubuntu1804 ~]#systemctl restart docker [root@ubuntu1804 ~]#docker info |grep aufs Storage Driver: aufs Root Dir: /var/lib/docker/aufs [root@ubuntu1804 ~]#docker images # 无镜像 [root@ubuntu1804 ~]#docker ps -a [root@ubuntu1804 ~]#ls /var/lib/docker aufs builder buildkit containers image network overlay2 plugins runtimes swarm tmp trust volumes [root@ubuntu1804 ~]#ls /var/lib/docker/aufs/ diff layers mnt [root@ubuntu1804 ~]#cat /etc/docker/daemon.json { "registry-mirrors": ["https://si7y70hh.mirror.aliyuncs.com"] } [root@ubuntu1804 ~]#systemctl restart docker [root@ubuntu1804 ~]#docker ps -a [root@ubuntu1804 ~]#docker images # 镜像恢复

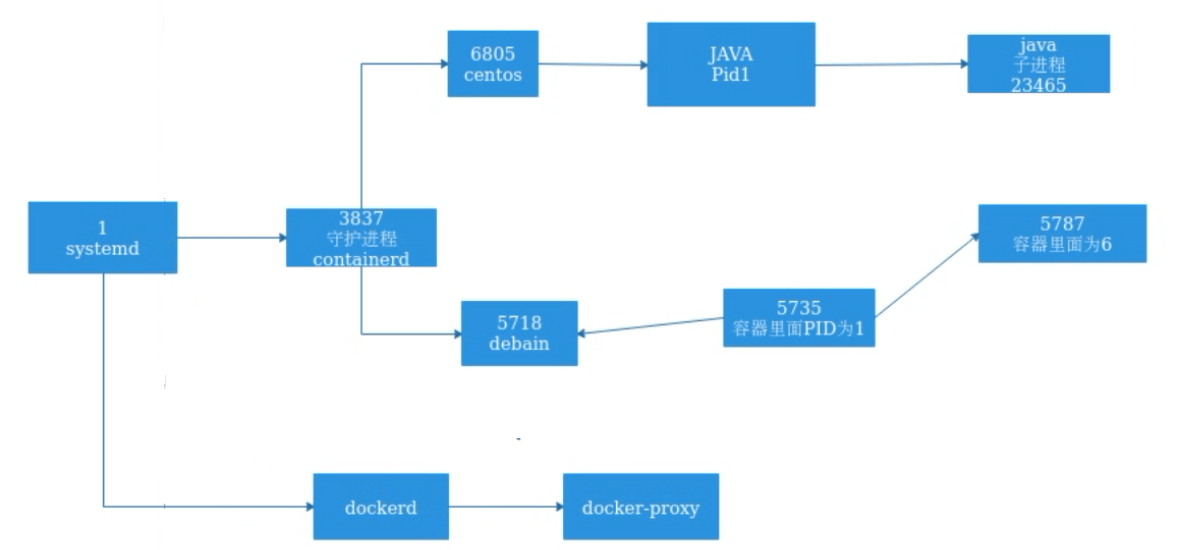

docker 服务进程

通过查看docker进程,了解docker的运行及工作方式

- 查看宿主机进程树

pstree -p

- docker的进程关系

docker 相关的四个进程:

- dockerd: 服务器程序,被client直接访问,其父进程为宿主机的systemd守护进程。

- docker-proxy: 每个进程docker-proxy实现对应一个需要网络通信的容器,管理宿主机和容器的之间端口映射,其父进程为dockerd,如果容器不需要网络则无需启动

- containerd: 被dockerd进程调用以实现与runc交互

- containerd-shim: 真正运行容器的载体,每个容器对应一个containerd-shim进程,其父进程为containerd

- dockerd: 服务器程序,被client直接访问,其父进程为宿主机的systemd守护进程。

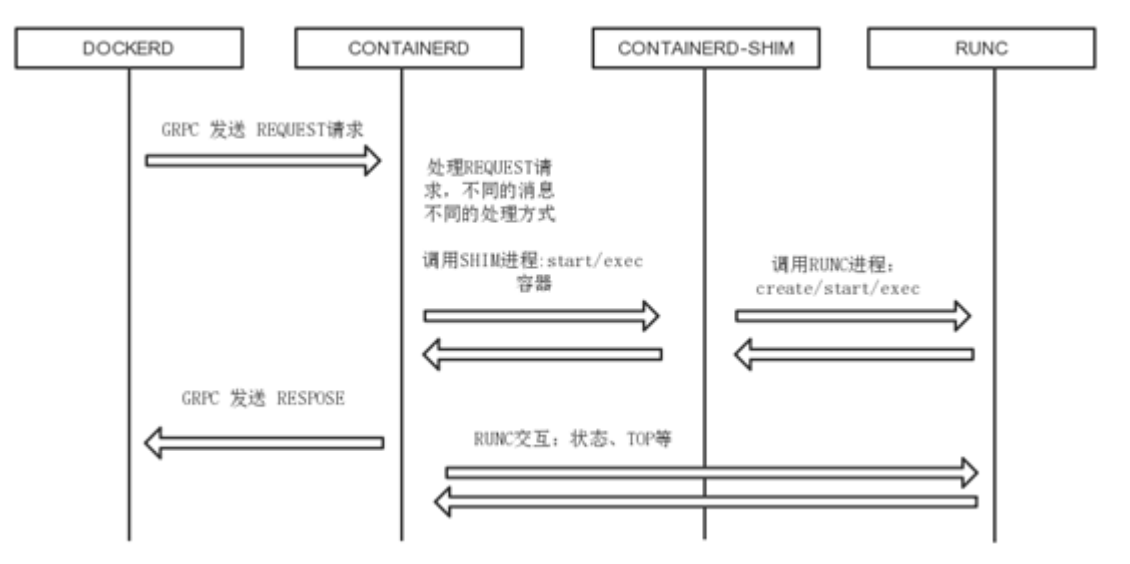

- 容器的创建与管理过程

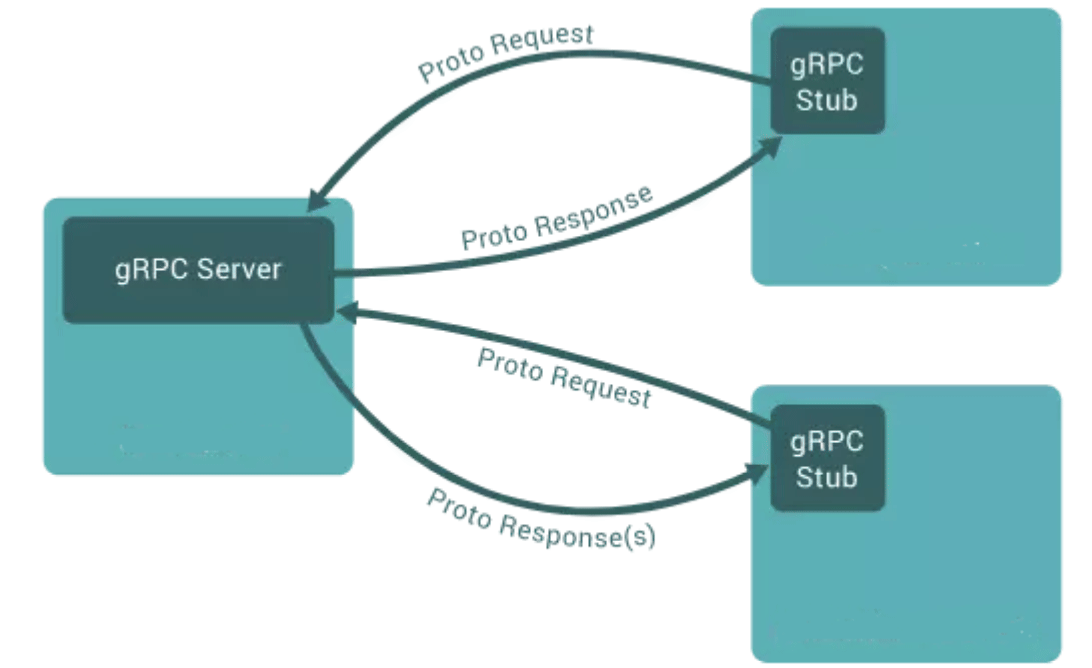

通信流程:

- 1. dockerd通过grpc和 containerd模块通信,dockerd由libcontainerd负责和containerd进行交换,dockerd和containerd 通信socket文件: /run/containerd/containerd.sock

- 2. containerd在dockerd启动时被启动,然后containerd启动grpc请求监听,containerd处理grpc请求,根据请求做相应动作

- 3. 若是run, start或是exec 容器,containerd 拉起一个container-shim , 并进行相应的操作

- 4. container-shim别拉起后,start/exec/create拉起runC进程,通过exit、control文件和containerd通信,通过父子进程关系和SIGCHLD监控容器中进程状态

- 5. 在整个容器生命周期中,containerd通过 epoll 监控容器文件,监控容器事件

- 1. dockerd通过grpc和 containerd模块通信,dockerd由libcontainerd负责和containerd进行交换,dockerd和containerd 通信socket文件: /run/containerd/containerd.sock

- gRPC简介

docker 服务管理

docker 服务基于C/S 结构,可以实现基于本地和远程方式进行管理

#Dockerd守护进程启动选项 -H tcp://host:port unix:///path/to/socket, fd://* or fd://socketfd #守护进程默认配置: -H unix:///var/run/docker.sock #使用Docker客户端命令选项 -H tcp://host:port unix:///path/to/socket, fd://* or fd://socketfd 客户端默认配置: -H unix:///var/run/docker.sock #docker客户端也可以使用环境变量DOCKER_ HOST,代替-H选项 export DOCKER_HOST="tcp://docker-server:2375"

范例: 通过UDS访问docker

[root@ubuntu1804 ~]#cat /lib/systemd/system/docker.service [Unit] Description=Docker Application Container EngineDocumentation=https://docs.docker.com BindsTo=containerd.service After=network-online.target firewalld.service containerd.service Wants=network-online.target Requires=docker.socket [Service] Type=notify ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock ExecReload=/bin/kill -s HUP $MAINPID TimeoutSec=0 RestartSec=2 Restart=always StartLimitBurst=3 StartLimitInterval=60s LimitNOFILE=infinity LimitNPROC=infinity LimitCORE=infinity TasksMax=infinity Delegate=yes KillMode=process [Install] WantedBy=multi-user.target [root@ubuntu1804 ~]#systemctl status docker [root@ubuntu1804 ~]#ll /var/run/docker.sock srw-rw---- 1 root docker 0 Jul 22 20:33 /var/run/docker.sock= [root@ubuntu1804 ~]#nc -U /var/run/docker.sock GET /info HTTP/1.1 host: www.xxx.org HTTP/1.1 200 OK Api-Version: 1.40 Content-Type: application/json Docker-Experimental: false Ostype: linux Server: Docker/19.03.12 (linux) Date: Wed, 22 Jul 2020 11:54:12 GMT Transfer-Encoding: chunked 947

范例: docker服务添加标签

[root@ubuntu1804 ~]#vim /lib/systemd/system/docker.service #修改下面行 ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock --label="name=docker1" [root@ubuntu1804 ~]#systemctl daemon-reload [root@ubuntu1804 ~]#systemctl restart docker [root@ubuntu1804 ~]#docker info Labels: name=docker1 #此处显示添加的标签

范例: 开启docker的远程访问

#方法1 [root@ubuntu1804 ~]#vim /lib/systemd/system/docker.service #修改下面行 ExecStart=/usr/bin/dockerd -H fd:// -H tcp://0.0.0.0:2375 -- containerd=/run/containerd/containerd.sock --label="name=docker1" #方法2 [root@ubuntu1804 ~]#vim /lib/systemd/system/docker.service ExecStart=/usr/bin/dockerd --containerd=/run/containerd/containerd.sock[root@ubuntu1804 ~]#vim /etc/docker/daemon.json { "hosts": ["tcp://0.0.0.0:2375", "fd://"] } [root@ubuntu1804 ~]#systemctl daemon-reload [root@ubuntu1804 ~]#systemctl restart docker [root@ubuntu1804 ~]#ss -tnlp|grep 2375 [root@ubuntu1804 ~]#ps -ef | grep docker #实现远程访问方式1 [root@centos7 ~]#curl http://10.0.0.100:2375/info #实现远程访问方式2 [root@centos7 ~]#docker -H tcp://10.0.0.100:2375 info #实现远程访问方式3 [root@centos7 ~]#export DOCKER_HOST="tcp://10.0.0.100:2375" [root@centos7 ~]#docker info #恢复连接本机 [rootcentos7 ~]#unset DOCKER_HOST

镜像管理

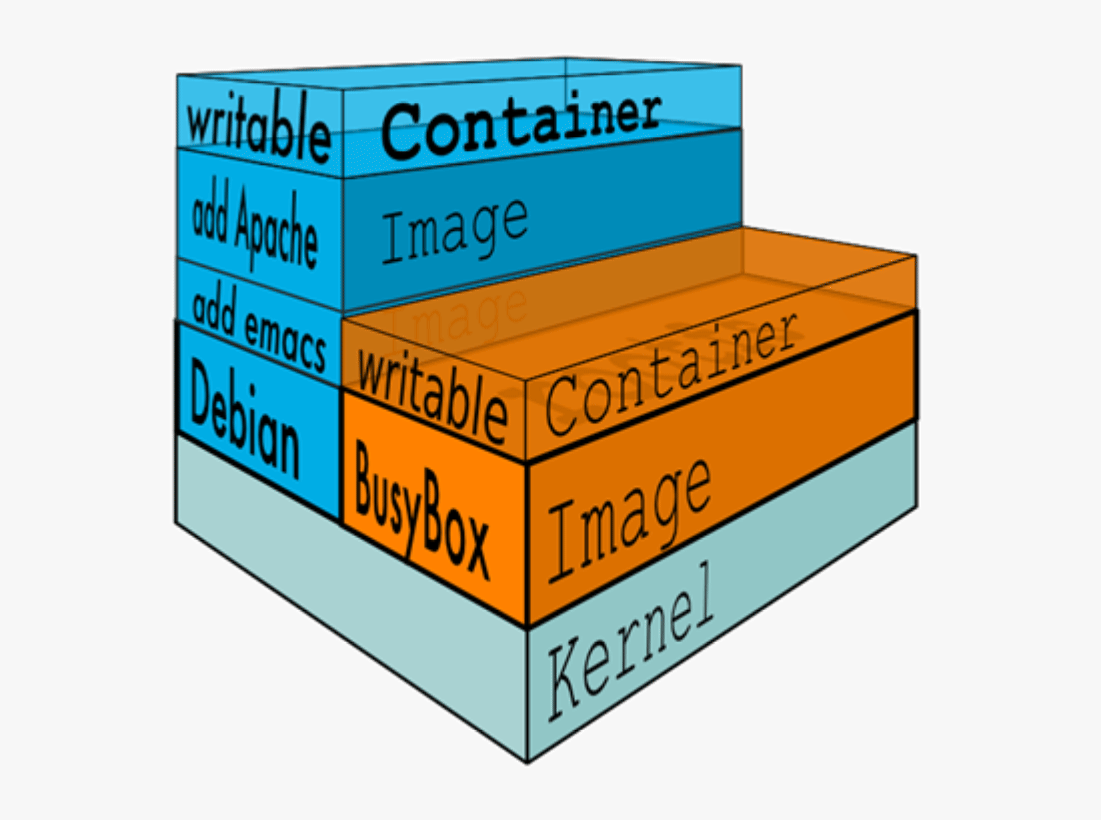

镜像结构和原理

镜像即创建容器的模版,含有启动容器所需要的文件系统及所需要的内容,因此镜像主要用于方便和快速的创建并启动容器

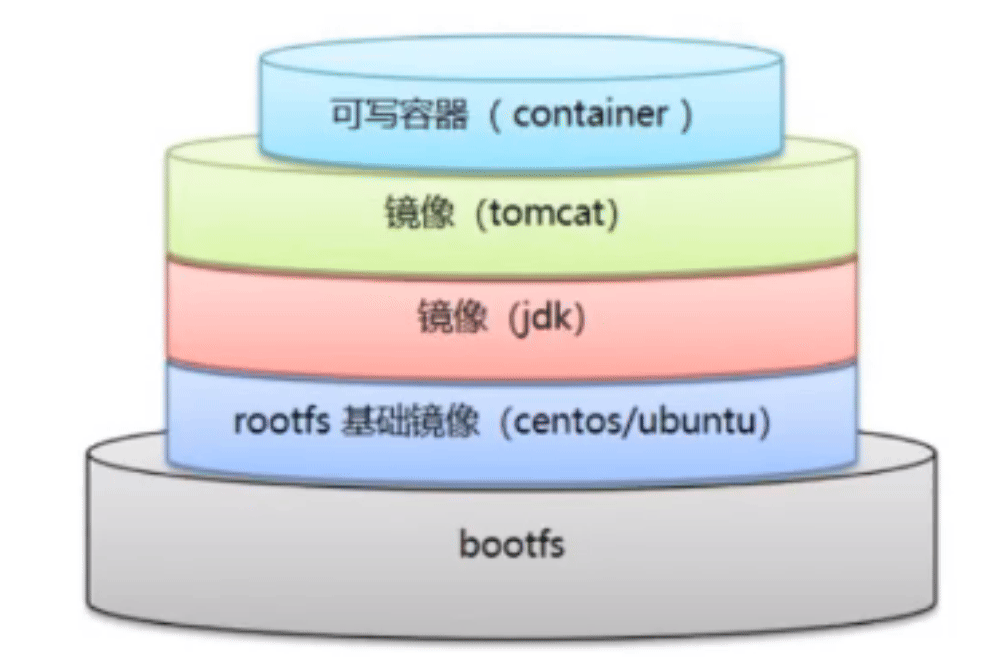

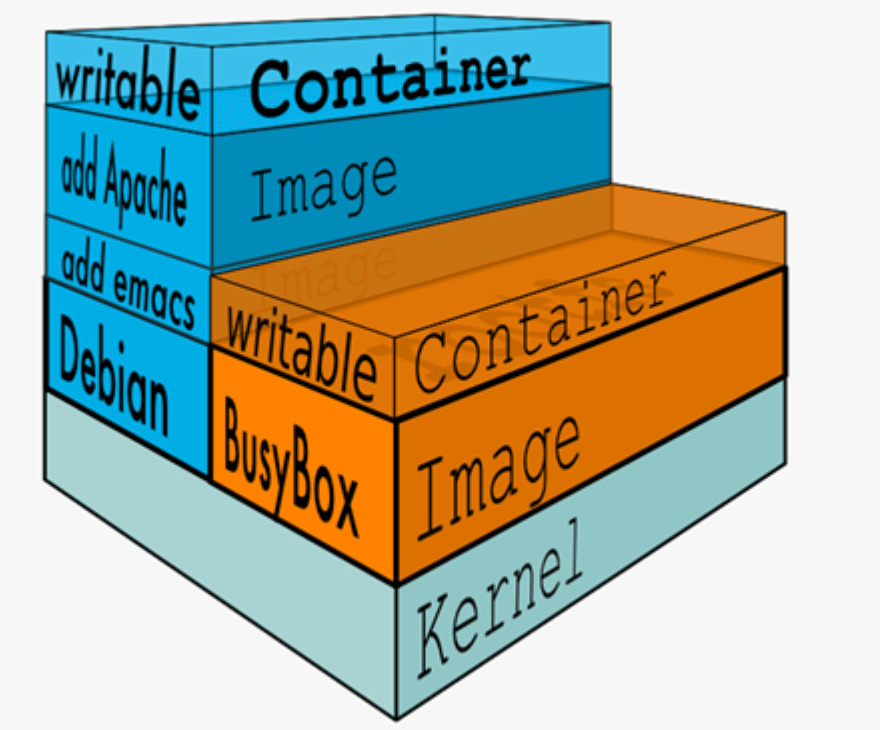

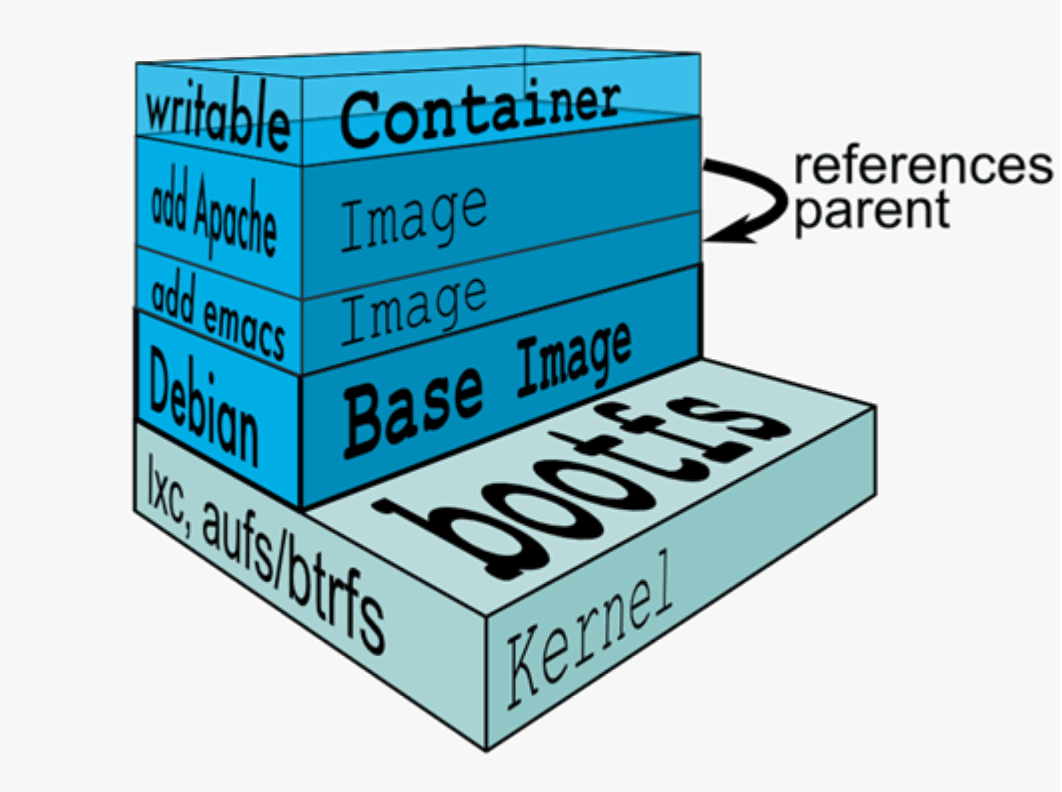

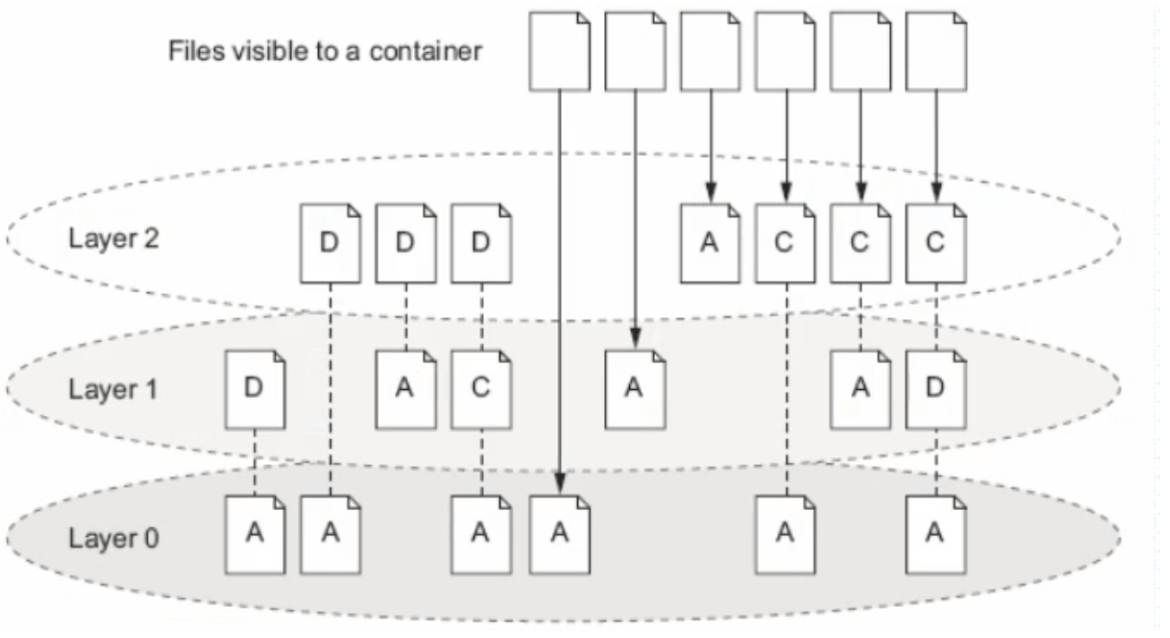

镜像含里面是一层层的文件系统,叫做 Union FS(联合文件系统),联合文件系统,可以将几层目录挂载到一起(就像千层饼,洋葱头,俄罗斯套娃一样),形成一个虚拟文件系统,虚拟文件系统的目录结构就像普通 linux 的目录结构一样,镜像通过这些文件再加上宿主机的内核共同提供了一个 linux 的虚拟环境,每一层文件系统叫做一层 layer,联合文件系统可以对每一层文件系统设置三种权限,只读(readonly)、读写(readwrite)和写出(whiteout-able),但是镜像中每一层文件系统都是只读的,构建镜像的时候,从一个最基本的操作系统开始,每个构建提交的操作都相当于做一层的修改,增加了一层文件系统,一层层往上叠加,上层的修改会覆盖底层该位置的可见性,这也很容易理解,就像上层把底层遮住了一样,当使用镜像的时候,我们只会看到一个完全的整体,不知道里面有几层,实际上也不需要知道里面有几层,结构如下:

一个典型的 Linux文件系统由 bootfs 和 rootfs 两部分组成

bootfs(boot file system) 主要包含bootloader和kernel,bootloader主要用于引导加载 kernel,Linux刚启动时会加载bootfs文件系统,当boot加载完成后,kernel 被加载到内存中后接管系统的控制权,bootfs会被 umount 掉

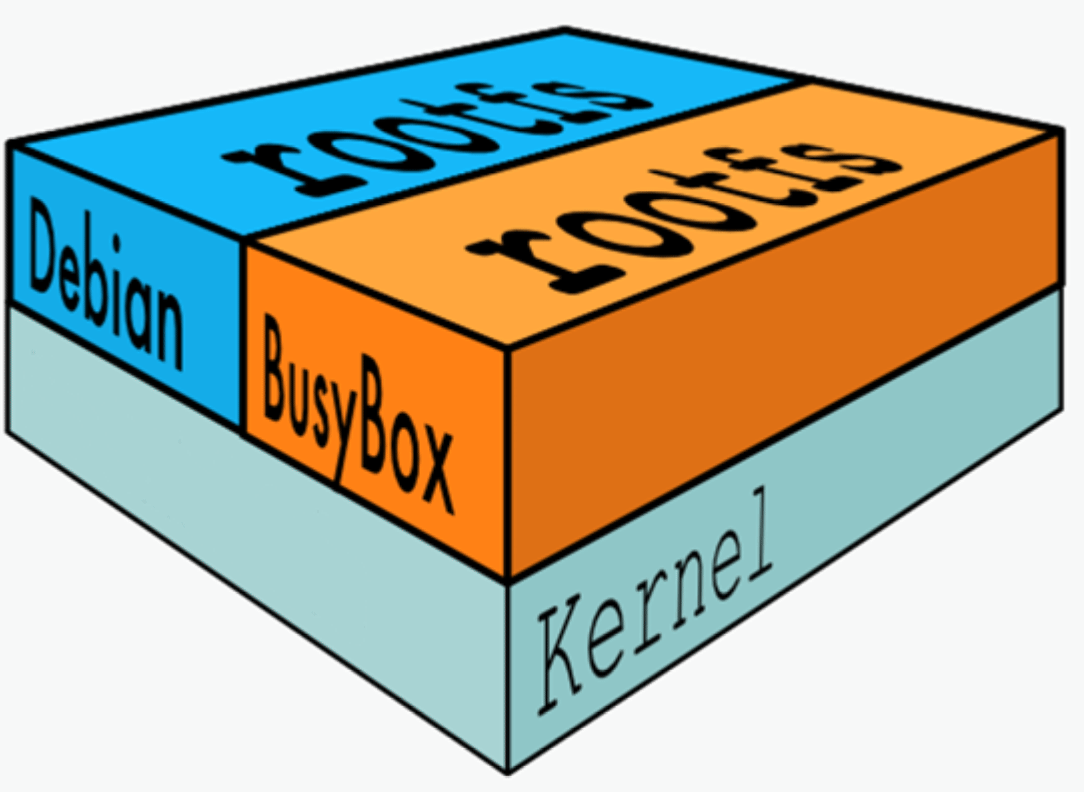

rootfs (root file system) 包含的就是典型 Linux 系统中的/dev,/proc,/bin,/etc 等标准目录和文件,不同的 linux 发行版(如 ubuntu 和 CentOS ) 主要在 rootfs 这一层会有所区别。一般的镜像通常都比较小,官方提供的Ubuntu镜像只有60MB多点,而 CentOS 基础镜像也只有200MB左右,一些其他版本的镜像甚至只有几MB,比如: busybox 才1.22MB,alpine镜像也只有5M左右。镜像直接调用宿主机的内核,镜像中只提供 rootfs,也就是只需要包括最基本的命令,配置文件和程序库等相关文件就可以了。

下图就是有两个不同的镜像在一个宿主机内核上实现不同的rootfs。

容器、镜像和父镜像关系:

范例: 查看镜像的分层结构

[root@ubuntu1804 ~]#docker pull nginx

#查看镜像分层历史

[root@ubuntu1804 ~]#docker image history nginx

IMAGE CREATED CREATED BY

SIZE COMMENT

0901fa9da894 9 days ago /bin/sh -c #(nop) CMD ["nginx" "-g"

"daemon… 0B

<missing> 9 days ago /bin/sh -c #(nop) STOPSIGNAL SIGTERM

0B

<missing> 9 days ago /bin/sh -c #(nop) EXPOSE 80

0B

<missing> 9 days ago /bin/sh -c #(nop) ENTRYPOINT ["/dockerentr… 0B

<missing> 9 days ago /bin/sh -c #(nop) COPY

0fd5fca330dcd6a7… 1.04kB

<missing> 9 days ago /bin/sh -c #(nop) COPY

1d0a4127e78a26c1… 1.96kB

<missing> 9 days ago /bin/sh -c #(nop) COPY

e7e183879c35719c… 1.2kB

<missing> 9 days ago /bin/sh -c set -x && addgroup –

system -… 63.3MB

<missing> 9 days ago /bin/sh -c #(nop) ENV

PKG_RELEASE=1~buster 0B

<missing> 9 days ago /bin/sh -c #(nop) ENV NJS_VERSION=0.4.2

0B

<missing> 9 days ago /bin/sh -c #(nop) ENV

NGINX_VERSION=1.19.1 0B

<missing> 5 weeks ago /bin/sh -c #(nop) LABEL

maintainer=NGINX Do… 0B

<missing> 5 weeks ago /bin/sh -c #(nop) CMD ["bash"]

0B

<missing> 5 weeks ago /bin/sh -c #(nop) ADD

4d35f6c8bbbe6801c… 69.2MB

搜索镜像

搜索镜像

- 官方网站进行镜像的搜索

官方的docker 仓库中搜索指定名称的docker镜像,也会有很多三方镜像。

- 执行docker search命令进行搜索

格式如下:

范例:

Usage: docker search [OPTIONS] TERM Options: -f, --filter filter Filter output based on conditions provided --format string Pretty-print search using a Go template --limit int Max number of search results (default 25) --no-trunc Don't truncate output说明:

OFFICIAL: 官方

AUTOMATED: 使用第三方docker服务来帮助编译镜像,可以在互联网上面直接拉取到镜像,减少了繁琐的编译过程

范例:搜索点赞100个以上的镜像

docker search --filter=stars=100 centos

alpine 介绍

Alpine 操作系统是一个面向安全的轻型 Linux 发行版。它不同于通常 Linux 发行版,Alpine 采用了musl libc 和 busybox 以减小系统的体积和运行时资源消耗,但功能上比 busybox 又完善的多,因此得到开源社区越来越多的青睐。在保持瘦身的同时,Alpine 还提供了自己的包管理工具 apk,可以通过 https://pkgs.alpinelinux.org/packages 网站上查询包信息,也可以直接通过 apk 命令直接查询和安装各种软件。

Alpine 由非商业组织维护的,支持广泛场景的 Linux发行版,它特别为资深/重度Linux用户而优化,关注安全,性能和资源效能。Alpine 镜像可以适用于更多常用场景,并且是一个优秀的可以适用于生产的基础系统/环境。

Alpine Docker 镜像也继承了 Alpine Linux 发行版的这些优势。相比于其他 Docker 镜像,它的容量非常小,仅仅只有 5 MB 左右(对比 Ubuntu 系列镜像接近 200 MB),且拥有非常友好的包管理机制。官方镜像来自 docker-alpine 项目。

目前 Docker 官方已开始推荐使用 Alpine 替代之前的 Ubuntu 做为基础镜像环境。这样会带来多个好处。包括镜像下载速度加快,镜像安全性提高,主机之间的切换更方便,占用更少磁盘空间等。

下表是官方镜像的大小比较:

REPOSITORY TAG IMAGE ID VIRTUAL SIZE alpine latest 4e38e38c8ce0 4.799 MB debian latest 4d6ce913b130 84.98 MB ubuntu latest b39b81afc8ca 188.3 MB centos latest 8efe422e6104 210 MB

- Alpine 官网: https://www.alpinelinux.org/

- Alpine 官方仓库: https://github.com/alpinelinux

- Alpine 官方镜像: https://hub.docker.com/_/alpine/

- Alpine 官方镜像仓库: https://github.com/gliderlabs/docker-alpine

- Alpine 阿里云的镜像仓库: https://mirrors.aliyun.com/alpine/

范例: alpine管理软件

#修改源替换成阿里源,将里面 dl-cdn.alpinelinux.org 的 改成 mirrors.aliyun.com vi /etc/apk/repositories http://mirrors.aliyun.com/alpine/v3.8/main/ http://mirrors.aliyun.com/alpine/v3.8/community/ #更新源 apk update #安装软件 apk add vim #删除软件 apk del openssh openntp vim

范例:

/ # apk add nginx / # apk info nginx ~ # apk manifest nginx ~ # ls -l /bin

Debian(ubuntu)系统建议安装的基础包

在很多软件官方提供的镜像都使用的是Debian(ubuntu)的系统,比如:nginx,tomcat,mysql,httpd 等,但镜像内缺少很多常用的调试工具.当需要进入容器内进行调试管理时,可以安装以下常用工具包

# apt update #安装软件前需要先更新索引 # apt install procps #提供top,ps,free等命令 # apt install psmisc #提供pstree,killall等命令 # apt install iputils-ping #提供ping命令 # apt install net-tools #提供netstat网络工具等镜像下载说明

下载镜像

从 docker 仓库将镜像下载到本地,命令格式如下:

docker pull [OPTIONS] NAME[:TAG|@DIGEST]

Options:

-a, --all-tags Download all tagged images in the repository

--disable-content-trust Skip image verification (default true)

--platform string Set platform if server is multi-platform capable

-q, --quiet Suppress verbose output

NAME: 是镜像名,一般的形式 仓库服务器:端口/项目名称/镜像名称

:TAG: 即版本号,如果不指定:TAG,则下载最新版镜像

镜像下载说明

[root@ubuntu1804 ~]#docker pull hello-world Using default tag: latest #默认下载最新版本 latest: Pulling from library/hello-world 1b930d010525: Pull complete #分层下载 Digest: sha256:9572f7cdcee8591948c2963463447a53466950b3fc15a247fcad1917ca215a2f #摘要 Status: Downloaded newer image for hello-world:latest docker.io/library/hello-world:latest #下载的完整地址

镜像下载保存的路径:

/var/lib/docker/overlay2/镜像ID

注意: 镜像下载完成后,会自动解压缩,比官网显示的可能会大很多,如: centos8.1.1911下载时只有70MB,下载完后显示237MB

范例: 指定 TAG下载特定版本的镜像

docker pull centos:centos8.1.1911

范例: 指定DIGEST下载特定版本的镜像

先到 hub.docker.com查到指定版本的DIGEST

docker pull alpine@sha256:156f59dc1cbe233827642e09ed06e259ef6fa1ca9b2e29d52ae14d5e7b79d7f0

docker 镜像加速配置

docker 镜像官方的下载站点是: https://hub.docker.com/

从国内下载官方的镜像站点有时候会很慢,因此可以更改docker配置文件添加一个加速器,可以通过加速器达到加速下载镜像的目的

国内有许多公司都提供了docker 加速镜像,比如: 阿里云,腾讯云,网易云,以下以阿里云为例

阿里云获取加速地址

浏览器打开http://cr.console.aliyun.com , 注册或登录阿里云账号,点击左侧的镜像加速器,将会得到一个专属的加速地址,而且下面有使用配置说明:

镜像加速配置

1. 安装/升级Docker客户端 推荐安装1.10.0以上版本的Docker客户端,参考文档 docker-ce 2. 配置镜像加速器 修改daemon配置文件/etc/docker/daemon.json来使用加速器 mkdir -p /etc/docker tee /etc/docker/daemon.json <<-'EOF' { "registry-mirrors": ["https://si7y70hh.mirror.aliyuncs.com"] } EOF #网易云: http://hub-mirror.c.163.com/ #腾讯云: https://mirror.ccs.tencentyun.com systemctl daemon-reload systemctl restart docker

查看本地镜像

docker images 可以查看下载至本地的镜像

格式:

docker images [OPTIONS] [REPOSITORY[:TAG]] docker image ls [OPTIONS] [REPOSITORY[:TAG]] #常用选项: -q, --quiet Only show numeric IDs -a, --all Show all images (default hides intermediate images) --digests Show digests --no-trunc Don't truncate output -f, --filter filter Filter output based on conditions provided --format string Pretty-print images using a Go template

执行结果的显示信息说明:

REPOSITORY #镜像所属的仓库名称 TAG #镜像版本号(标识符),默认为latest IMAGE ID #镜像唯一ID标识,如果ID相同,说明是同一个镜像有多个名称 CREATED #镜像在仓库中被创建时间 VIRTUAL SIZE #镜像的大小

Repository仓库

- 由某特定的docker镜像的所有迭代版本组成的镜像仓库

- 一个Registry中可以存在多个Repository

- Repository可分为“顶层仓库”和“用户仓库”

- Repository用户仓库名称一般格式为“用户名/仓库名”

- 每个Repository仓库可以包含多个Tag(标签),每个标签对应一个镜像

范例:

#显示完整的ImageID [root@ubuntu1804 ~]#docker images --no-trunc # 查看指定镜像的详细信息 root@centos8 ~]#podman image inspect alpine

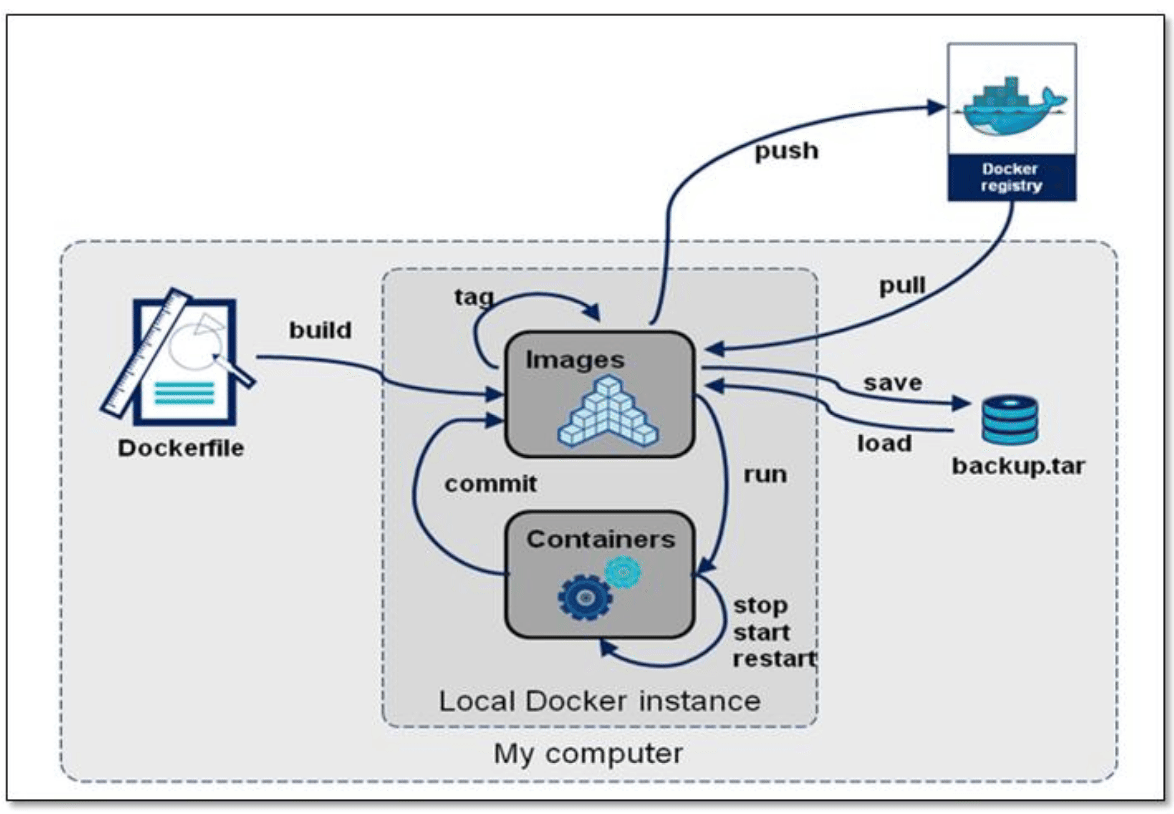

镜像导出

利用docker save命令可以将从本地镜像导出为一个打包 tar文件,然后复制到其他服务器进行导入使用

格式:

docker save [OPTIONS] IMAGE [IMAGE...] 选项: -o, --output string Write to a file, instead of STDOUT

常见用法:

docker save -o /path/file.tar IMAGE1 IMAGE2 ... docker save IMAGE1 IMAGE2 ... > /path/file.tar

镜像导入

利用docker load命令可以将镜像导出的压缩文件再导入

格式:

#选项 -i, --input string Read from tar archive file, instead of STDIN -q, --quiet Suppress the load output范例: 一次导出多个镜像

范例: 镜像导入

[root@centos7 ~]#docker load -i /data/myimages.tar #或者 [root@centos7 ~]#docker load < /data/myimages.tar [root@centos7 ~]#docker images

范例: 一次导出多个镜像

[root@ubuntu1804 ~]#docker save busybox alpine > /all.tar

[root@ubuntu1804 ~]#docker rmi -f `docker images -q`

[root@ubuntu1804 ~]#docker load -i /opt/all.tar

[root@ubuntu1804 ~]#docker images

删除镜像

docker rmi 命令可以删除本地镜像

格式

docker rmi [OPTIONS] IMAGE [IMAGE...] docker image rm [OPTIONS] IMAGE [IMAGE...] #选项: -f, --force Force removal of the image --no-prune Do not delete untagged parents

范例:

#删除多个镜像 [root@ubuntu1804 ~]#docker rmi nginx tomcat # 强制删除正在使用的镜像,也会删除对应的容器 docker rmi -f centos:centos8.1.1911 #删除所有镜像 [root@ubuntu1804 ~]#docker rmi -f `docker images -q`

镜像打标签

docker tag 可以给镜像打标签,类似于起别名,但通常要遵守一定的命名规范,才可以上传到指定的仓库

格式

docker tag SOURCE_IMAGE[:TAG] TARGET_IMAGE[:TAG] #TARGET_IMAGE[:TAG]格式一般形式 仓库主机FQDN或IP[:端口]/项目名(或用户名)/image名字:版本

TAG默认为latest

总结: 企业使用镜像及常见操作: 搜索、下载、导出、导入、删除

docker search centos docker pull alpine docker images docker save > /opt/centos.tar #centos #导出镜像 docker load -i centos-latest.tar.xz #导入本地镜像 docker rmi 镜像ID/镜像名称 #删除指定ID的镜像,此镜像对应容器正启动镜像不能被删除,除非将容器全部关闭

容器操作基础命令

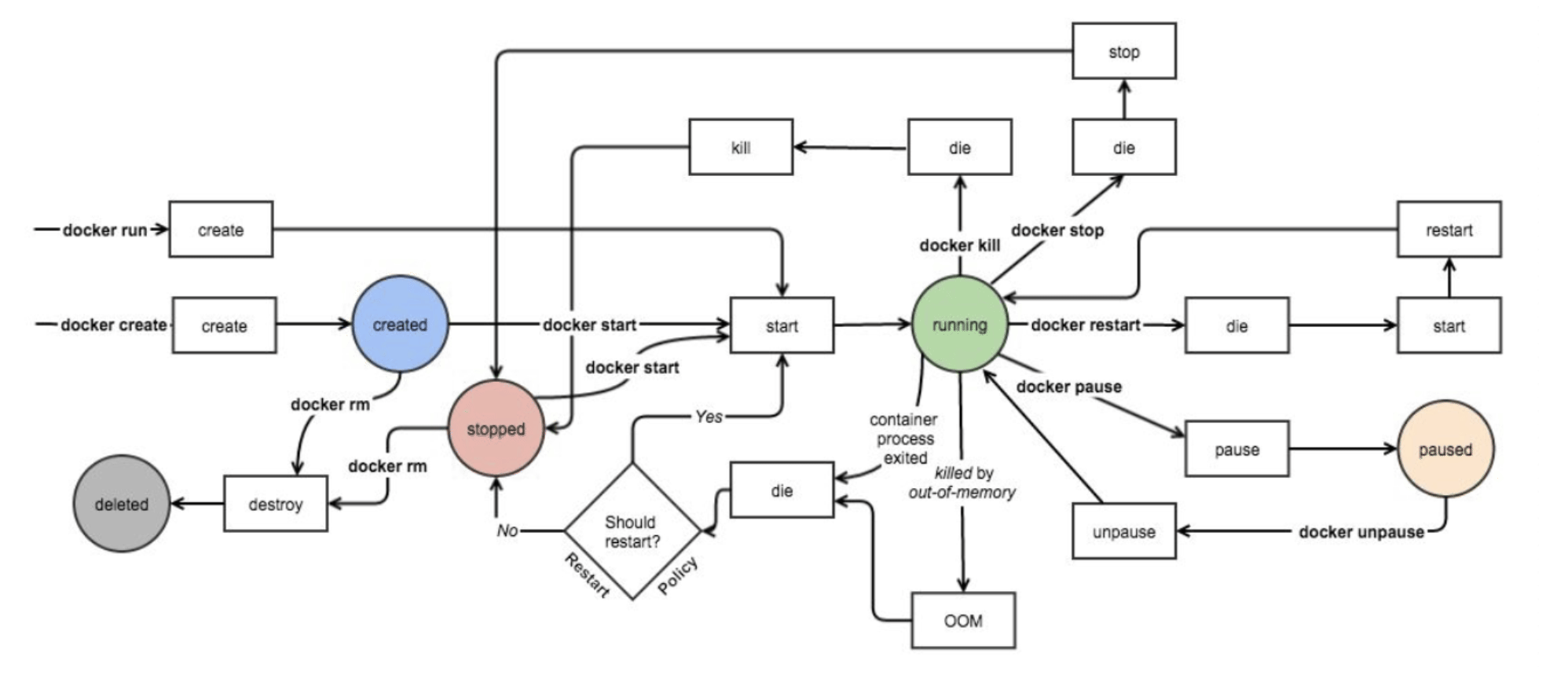

容器生命周期

容器相关命令

[root@ubuntu1804 ~]#docker container Usage: docker container COMMAND Manage containers Commands: attach Attach local standard input, output, and error streams to a running container commit Create a new image from a container's changes cp Copy files/folders between a container and the local filesystem create Create a new container diff Inspect changes to files or directories on a container's filesystem exec Run a command in a running container export Export a container's filesystem as a tar archive inspect Display detailed information on one or more containers kill Kill one or more running containers logs Fetch the logs of a container ls List containers pause Pause all processes within one or more containers port List port mappings or a specific mapping for the container prune Remove all stopped containers rename Rename a container restart Restart one or more containers rm Remove one or more containers run Run a command in a new container start Start one or more stopped containers stats Display a live stream of container(s) resource usage statistics stop Stop one or more running containers top Display the running processes of a container unpause Unpause all processes within one or more containers update Update configuration of one or more containers wait Block until one or more containers stop, then print their exit codes Run 'docker container COMMAND --help' for more information on a command.

启动容器

docker run 可以启动容器,进入到容器,并随机生成容器ID和名称

启动第一个容器

范例: 运行docker 的 hello world

[root@centos8 ~]# docker run hello-world [root@centos8 ~]#docker ps -a

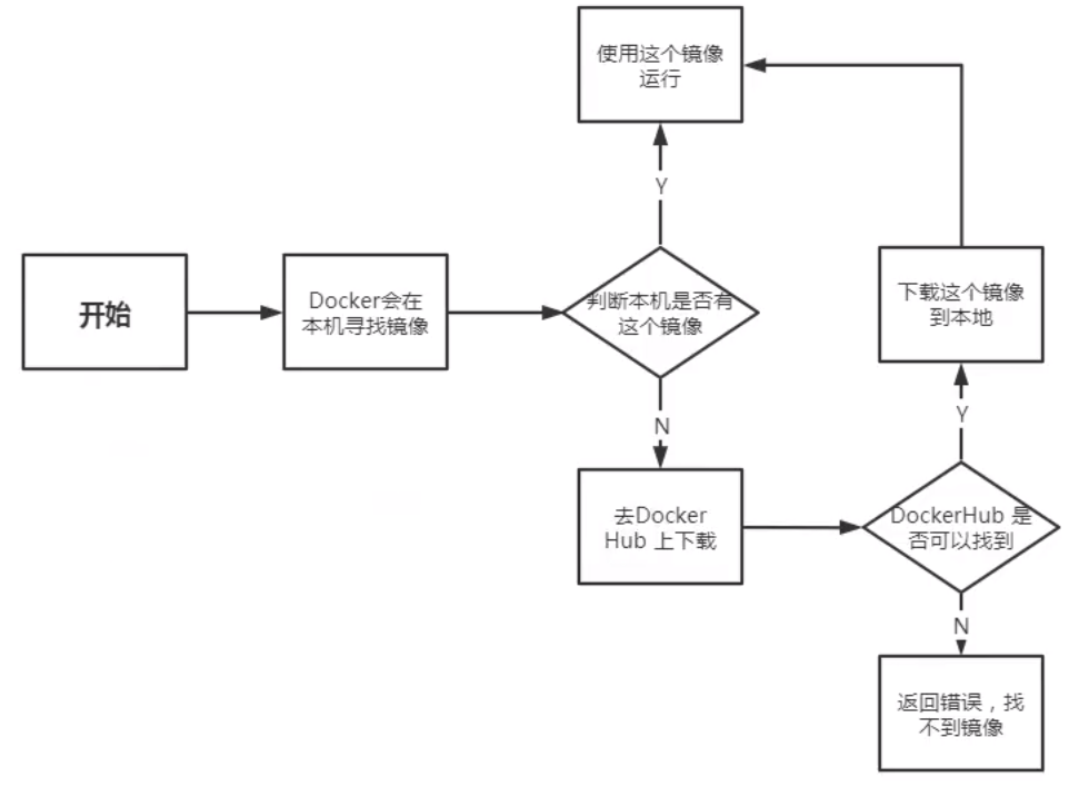

启动容器的流程

启动容器用法

帮助: man docker-run

命令格式:

docker run [选项] [镜像名] [shell命令] [参数] #选项: -i, --interactive Keep STDIN open even if not attached,通常和-t一起使用 -t, --tty 分配pseudo-TTY,通常和-i一起使用,注意对应的容器必须运行shell才支持进入 -d, --detach Run container in background and print container ID,台后运行,默认前台 --name string Assign a name to the container --h, --hostname string Container host name --rm Automatically remove the container when it exits -p, --publish list Publish a container's port(s) to the host -P, --publish-all Publish all exposed ports to random ports --dns list Set custom DNS servers --entrypoint string Overwrite the default ENTRYPOINT of the image --restart policy --privileged Give extended privileges to container -e, --env=[] Set environment variables --env-file=[] Read in a line delimited file of environment variablespolicy 说明

–restart 可以指定四种不同的policy

- no: Default is no,Do not automatically restart the container when it exits.

- on-failure[:maxretries]:on-failure[:max-retries] Restart only if the container exits with a non-zero exit status. Optionally, limit the number of restart retries the Docker daemon attempts.

- always:Always restart the container regardless of the exit status. When you specifyalways, the Docker daemon will try to restart the container indefinitely. The container will also always start on daemon startup, regardless of the current state of the container.

- unlessstopped:Always restart the container regardless of the exit status, but do not start it on daemon startup if the container has been put to a stopped state before.

注意: 容器启动后,如果容器内没有前台运行的进程,将自动退出停止

从容器内退出,并停止容器:exit

从容器内退出,且容器不停止:同时按三个键,ctrl+p+q

docker run –name a1 alpine

#1. 一次性运行容器中命 #启动的容器在执行完shell命令就退出,用于测试 [root@ubuntu1804 ~]#docker run busybox echo "Hello cici" Hello cici #2. 指定容器名称 #注意每个容器的名称要唯一 docker run --name a1 alpine #3. 运行交互式容器并退出 docker run -it docker.io/busybox sh / # exit #用exit退出后容器也停止 #4. 设置容器内的主机名 docker run -it --name a1 -h a1.xxx.org alpine / # hostname / # cat /etc/hosts / # cat /etc/resolv.conf #5. 一次性运行容器,退出后立即删除,用于测试 [root@ubuntu1804 ~]#docker run --rm alpine cat /etc/issue #6. 创建容器后直接进入并退出 退出两种方式: - exit 容器也停止 - 按ctrl+p+q 容器不停止

什么是守护式容器:

- 能够长期运行

- 无需交互式会话

- 适合运行应用程序和服务

范例: 启动前台守护式容器

[root@ubuntu1804 ~]#docker run nginx 172.17.0.4 - - [28/Jul/2020:13:12:49 +0000] "GET / HTTP/1.1" 200 612 "-" "Wget" "-" [root@ubuntu1804 ~]#docker run --rm --name b1 busybox wget -qO - 172.17.0.3

范例: 启动后台守护式容器

[root@ubuntu1804 ~]#docker run -d nginx #有些容器后台启动不会持续运行 [root@ubuntu1804 ~]#docker run -d --name alpine4 alpine [root@ubuntu1804 ~]#docker ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 3a05bbf66dac alpine "/bin/sh" 3 seconds ago Exited (0) 2 seconds ago alpine4 [root@ubuntu1804 ~]#docker run -td --name alpine5 alpine [root@ubuntu1804 ~]#docker ps -a CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 868b33da850c alpine "/bin/sh" 2 seconds ago Up 1 second alpine5

范例: 开机自动运行容器

#默认容器不会自动启动 #设置容器总是运行 [root@ubuntu1804 ~]#docker run -d --name nginx --restart=always -p 80:80 nginx

–privileged 选项

大约在0.6版,–privileged 选项被引入docker。使用该参数,container内的root拥有真正的root权限。

否则,container内的root只是外部的一个普通用户权限。privileged启动的容器,可以看到很多host上的设备,并且可以执行mount。甚至允许你在docker容器中启动docker容器。

范例: 使用–privileged 让容器获取 root 权限

#利用--privileged 选项运行容器 [root@centos8 ~]#podman run -it --privileged centos #可以看到宿主机的设备 [root@a6391a8f82e3 /]# lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 200G 0 disk |-sda1 8:1 0 1G 0 part |-sda2 8:2 0 100G 0 part |-sda3 8:3 0 50G 0 part |-sda4 8:4 0 1K 0 part [root@a6391a8f82e3 /]# mount /dev/sda3 /mnt [root@a6391a8f82e3 /]# touch /mnt/containter.txt [root@a6391a8f82e3 /]# echo container data > /mnt/containter.txt [root@a6391a8f82e3 /]# cat /mnt/containter.txt container data [root@a6391a8f82e3 /]# #在宿主机查看是否生成文件 [root@centos8 ~]#lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 200G 0 disk ├─sda1 8:1 0 1G 0 part /boot ├─sda2 8:2 0 100G 0 part / ├─sda3 8:3 0 50G 0 part /data ├─sda4 8:4 0 1K 0 part └─sda5 8:5 0 2G 0 part [SWAP] sr0 11:0 1 7G 0 rom [root@centos8 ~]#ll /data/containter.txt -rw-r--r-- 1 root root 25 Feb 29 12:26 /data/containter.txt [root@centos8 ~]#cat /data/containter.txt container data [root@centos8 ~]#echo host data >> /data/containter.txt [root@centos8 ~]#cat /data/containter.txt container data host data #在容器内可看文件是否发生变化 [root@a6391a8f82e3 /]# cat /mnt/containter.txt container data

范例: 运行docker官方文档容器

[root@centos8 ~]#podman run -it -d -p 4000:4000 docs/docker.github.io:latest [root@centos8 ~]#podman images docs/docker.github.io REPOSITORY TAG IMAGE ID CREATED SIZE docker.io/docs/docker.github.io latest ffd9131eeee7 2 days ago 1.99 GB #用浏览器访问http://localhost:4000/可以看到下面docker文档资料

查看容器信息

显示当前存在容器

格式

docker ps [OPTIONS] docker container ls [OPTIONS] 选项: -a, --all Show all containers (default shows just running) -q, --quiet Only display numeric IDs -s, --size Display total file sizes -f, --filter filter Filter output based on conditions provided -l, --latest Show the latest created container (includes all states) -n, --last int Show n last created containers (includes all states) (default -1)

范例:

#显示运行的容器 [root@ubuntu1804 ~]#docker ps #显示全部容器,包括退出状态的容器 [root@ubuntu1804 ~]#docker ps -a #只显示容器ID [root@ubuntu1804 ~]#docker ps -a -q d7ece7f62532 dcdf71d17177 #显示容器大小 [root@ubuntu1804 ~]#docker ps -a -s #显示最新创建的容器(停止的容器也能显示) [root@ubuntu1804 ~]#docker ps -l

范例: 显示指定状态的容器

docker ps -f 'status=exited

查看容器内的进程

docker top CONTAINER [ps OPTIONS]

查看容器资源使用情况

docker stats [OPTIONS] [CONTAINER...]

Display a live stream of container(s) resource usage statistics

Options:

-a, --all Show all containers (default shows just running)

--format string Pretty-print images using a Go template

--no-stream Disable streaming stats and only pull the first result

--no-trunc Do not truncate output

查看容器的详细信息

docker inspect 可以查看docker各种对象的详细信息,包括:镜像,容器,网络等

docker inspect [OPTIONS] NAME|ID [NAME|ID...] Options: -f, --format string Format the output using the given Go template -s, --size Display total file sizes if the type is container

范例:

[root@ubuntu1804 ~]#docker inspect 9997 选择性查看 [root@ubuntu1804 ~]#docker inspect -f "{{.Metadata}}" test:v1.0 {2020-07-24 21:56:42.247448035 +0800 CST} [root@ubuntu1804 ~]#docker inspect -f "{{.Created}}" c1 2020-07-24T13:37:11.006574248Z [root@ubuntu1804 ~]#docker inspect --format "{{.Created}}" c1 2020-07-24T13:37:11.006574248Z

删除容器

docker rm 可以删除容器,即使容器正在运行当中,也可以被强制删除掉

格式

docker rm [OPTIONS] CONTAINER [CONTAINER...] docker container rm [OPTIONS] CONTAINER [CONTAINER...] #选项: -f, --force Force the removal of a running container (uses SIGKILL)范例: -v, --volumes Remove the volumes associated with the container #删除停止的容器 docker container prune [OPTIONS] Options: --filter filter Provide filter values (e.g. 'until=<timestamp>') -f, --force Do not prompt for confirmation

范例: 删除所有容器

[root@ubuntu1804 ~]#docker rm -f `docker ps -a -q`

[root@ubuntu1804 ~]#docker ps -a -q | xargs docker rm -f

范例: 删除指定状态的容器

[root@ubuntu1804 ~]#docker rm `docker ps -qf status=exited`

容器的启动和停止

格式

docker start|stop|restart|pause|unpause 容器ID

批量正常启动或关闭所有容器

docker start $(docker ps -a -q) docker stop $(docker ps -a -q)

范例: 启动并进入容器

[root@ubuntu1804 ~]#docker run --name=c1 -it ubuntu bash root@539722b55b76:/# exit exit [root@ubuntu1804 ~]#docker ps -l CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 539722b55b76 ubuntu "bash" 4 seconds ago Exited (0) 1 second ago c1 [root@ubuntu1804 ~]#docker start c1 c1 [root@ubuntu1804 ~]#docker stop c1 c1 #启动并进入容器 [root@ubuntu1804 ~]#docker start -i c1 root@539722b55b76:/# exit exit

范例: 启动和停止所有容器

[root@ubuntu1804 ~]#docker stop `docker ps -a -q` [root@ubuntu1804 ~]#docker start `docker ps -a -q`

范例: 暂停和恢复容器

[root@ubuntu1804 ~]#docker run -d --name n1 nginx [root@ubuntu1804 ~]#docker pause n1 [root@ubuntu1804 ~]#docker unpause n1

给正在运行的容器发信号

docker kill 可以给容器发信号,默认号SIGKILL,即9信号

格式

docker kill [OPTIONS] CONTAINER [CONTAINER...] #选项: -s, --signal string Signal to send to the container (default "KILL")

进入正在运行的容器

使用attach命令

docker attach 容器名,不推荐使用

attach 类似于vnc,操作会在同一个容器的多个会话界面同步显示,所有使用此方式进入容器的操作都是同步显示的,且使用exit退出后容器自动关闭,不推荐使用,需要进入到有shell环境的容器

使用exec命令

在运行中的容器启动新进程,可以执行单次命令,以及进入容器测试环境使用此方式,使用exit退出,但容器还在运行,此为推荐方式

格式:

docker exec [OPTIONS] CONTAINER COMMAND [ARG...] 常用选项: -d, --detach Detached mode: run command in the background -e, --env list Set environment variables -i, --interactive Keep STDIN open even if not attached -t, --tty Allocate a pseudo-TTY #常见用法 docker exec -it 容器ID sh|bash

使用nsenter命令

nsenter命令需要通过PID进入到容器内部,且退出后仍然正常运行: 不过需要事先使用docker inspect 获取到容器的PID, 目前此方式使用较少,此工具来自于util-linux包

#安装nsenter命令 yum -y install util-linux #CentOS apt -y install util-linux #Ubuntu #获取容器的IP docker inspect -f "{{.NetworkSettings.IPAddress}}" 容器ID #获取到某个docker容器的PID,可以通过PID进入到容器内 docker inspect -f "{{.State.Pid}}" 容器ID nsenter -t PID -m -u -i -n -p

脚本方式

将nsenter命令写入到脚本进行调用,方便进入容器看日志或排错

如下:

cat docker-in.sh #!/bin/bash docker_in(){ NAME_ID=$1 PID=$(docker inspect -f "{{.State.Pid}}" ${NAME_ID}) nsenter -t ${PID} -m -u -i -n -p } docker_in $1

暴露所有容器端口

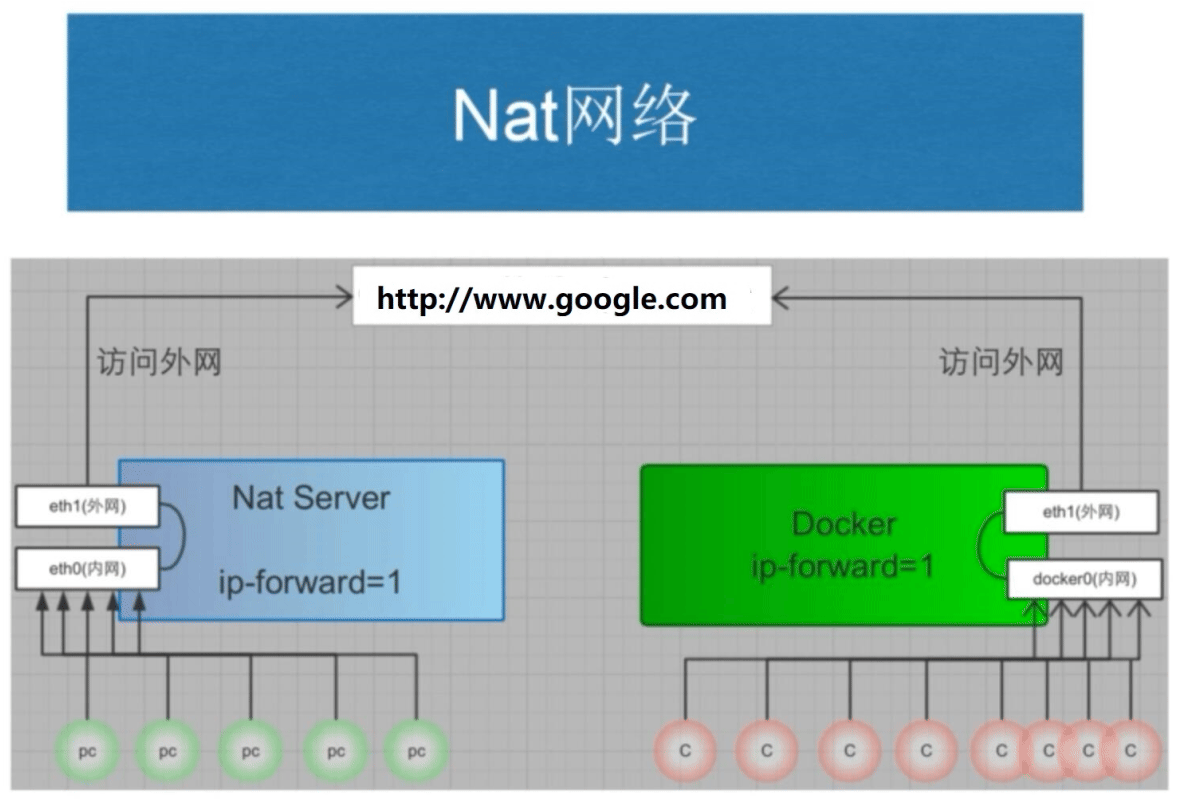

容器启动后,默认处于预定义的NAT网络中,所以外部网络的主机无法直接访问容器中网络服务

docker run -P 可以将事先容器预定义的所有端口映射宿主机的网卡的随机端口,默认从32768开始

使用随机端口 时,当停止容器后再启动可能会导致端口发生变化

-P , --publish-all= true | false默认为false #示例: docker run -P docker.io/nginx #映射容器所有暴露端口至随机本地端口

docker port 可以查看容器的端口映射关系

格式

docker port CONTAINER [PRIVATE_PORT[/PROTO]]

范例:

[root@centos7 ~]#docker port nginx-c1 443/tcp -> 0.0.0.0:8443 53/udp -> 0.0.0.0:8053 80/tcp -> 0.0.0.0:8080 [root@centos7 ~]#docker port nginx-c1 53/udp 0.0.0.0:8053

端口映射的本质就是利用NAT技术实现的

范例: 端口映射和iptables

#端口映射前的iptables规则 [root@ubuntu1804 ~]#iptables -S [root@ubuntu1804 ~]#iptables -S -t nat [root@ubuntu1804 ~]#iptables -S > pre.filter [root@ubuntu1804 ~]#iptables -S -t nat > pre.nat #实现端口映射 [root@ubuntu1804 ~]#docker run -d -P --name nginx1 nginx [root@ubuntu1804 ~]#docker exec -it nginx1 hostname -i 172.17.0.2 [root@ubuntu1804 ~]#docker port nginx1 80/tcp -> 0.0.0.0:32769 #端口映射后的iptables规则 [root@ubuntu1804 ~]#iptables -S #对比端口映射前后的变化 [root@ubuntu1804 ~]#iptables -S > post.filter [root@ubuntu1804 ~]#iptables -S -t nat > post.nat [root@ubuntu1804 ~]#diff pre.filter post.filter 13a14 > -A DOCKER -d 172.17.0.2/32 ! -i docker0 -o docker0 -p tcp -m tcp --dport 80 -j ACCEPT [root@ubuntu1804 ~]#diff pre.nat post.nat 8a9 > -A POSTROUTING -s 172.17.0.2/32 -d 172.17.0.2/32 -p tcp -m tcp --dport 80 -jMASQUERADE 9a11 > -A DOCKER ! -i docker0 -p tcp -m tcp --dport 32769 -j DNAT --to-destination 172.17.0.2:80 #本地和选程都可以访问 [root@ubuntu1804 ~]#curl 127.0.0.1:32769 #利用iptables 阻止同一个宿主机的其它容器CentOS8的访问 [root@ubuntu1804 ~]#iptables -I DOCKER -s 10.0.0.8 -d 172.17.0.2 -p tcp --dport 80 -j REJECT [root@ubuntu1804 ~]#iptables -S #测试访问 [root@centos8 ~]#curl 10.0.0.100:32769 curl: (7) Failed to connect to 10.0.0.100 port 32769: Connection refused [root@centos7 ~]#curl -I 10.0.0.100:32769 HTTP/1.1 200 OK

指定端口映射

docker run -p 可以将容器的预定义的指定端口映射到宿主机的相应端口

注意: 多个容器映射到宿主机的端口不能冲突,但容器内使用的端口可以相同

方式1: 容器80端口映射宿主机本地随机端口 docker run -p 80 --name nginx-test-port1 nginx 方式2: 容器80端口映射到宿主机本地端口81 docker run -p 81:80 --name nginx-test-port2 nginx 方式3: 宿主机本地IP:宿主机本地端口:容器端口 docker run -p 10.0.0.100:82:80 --name nginx-test-port3 docker.io/nginx 方式4: 宿主机本地IP:宿主机本地随机端口:容器端口,默认从32768开始 docker run -p 10.0.0.100::80 --name nginx-test-port4 docker.io/nginx 方式5: 宿主机本机ip:宿主机本地端口:容器端口/协议,默认为tcp协议 docker run -p 10.0.0.100:83:80/udp --name nginx-test-port5 docker.io/nginx 方式6: 一次性映射多个端口+协议 docker run -p 8080:80/tcp -p 8443:443/tcp -p 53:53/udp --name nginx-test-port6 nginx

查看容器的日志

docker logs 可以查看容器中运行的进程在控制台输出的日志信息

格式

docker logs [OPTIONS] CONTAINER

选项:

--details Show extra details provided to logs

-f, --follow Follow log output

--since string Show logs since timestamp (e.g. 2013-01-02T13:23:37) or relative (e.g. 42m for 42 minutes)

--tail string Number of lines to show from the end of the logs (default "all")

-t, --timestamps Show timestamps

--until string Show logs before a timestamp (e.g. 2013-01-02T13:23:37) or relative (e.g. 42m for 42 minutes)

范例: 查看容器日志

[root@ubuntu1804 ~]#docker run -d alpine /bin/sh -c 'i=1;while true;do echo hello$i;let i++;sleep 2;done' [root@ubuntu1804 ~]#docker logs 5126 hello1 hello2 hello3 hello4 hello5 hello6 [root@ubuntu1804 ~]#docker logs --tail 3 5126 hello8 hello9 hello10 #显示时间 [root@ubuntu1804 ~]#docker logs --tail 0 -t 5126 2020-02-25T13:30:07.321390731Z hello17 #持续跟踪 [root@ubuntu1804 ~]#docker logs -f 5126

传递运行命令

容器需要有一个前台运行的进程才能保持容器的运行,通过传递运行参数是一种方式,另外也可以在构建镜像的时候指定容器启动时运行的前台命令

容器里的PID为1的守护进程的实现方式

- 服务类: 如: Nginx,Tomcat,Apache ,但服务不能停

- 命令类: 如: tail -f /etc/hosts ,主要用于测试环境,注意: 不要tail -f <服务访问日志> 会产生不必要的磁盘IO

范例:

docker run -d alpine tail -f /etc/hosts

容器内部的hosts文件

容器会自动将容器的ID加入自已的/etc/hosts文件中,并解析成容器的IP

[root@ubuntu1804 ~]#docker run -it centos /bin/bash [root@598262a87c46 /]# cat /etc/hosts 127.0.0.1 localhost ::1 localhost ip6-localhost ip6-loopback fe00::0 ip6-localnet ff00::0 ip6-mcastprefix ff02::1 ip6-allnodes ff02::2 ip6-allrouters 172.17.0.2 598262a87c46 #默认会将实例的ID 添加到自己的hosts文件 [root@598262a87c46 /]# hostname 598262a87c46 [root@598262a87c46 /]# ping 598262a87c46 PING 598262a87c46 (172.17.0.2) 56(84) bytes of data. 64 bytes from 598262a87c46 (172.17.0.2): icmp_seq=1 ttl=64 time=0.118 ms 64 bytes from 598262a87c46 (172.17.0.2): icmp_seq=2 ttl=64 time=0.085 ms

范例: 修改容器的 hosts文件

docker run -it --rm --add-host www.xxx.com:6.6.6.6 --add-host www.ttt.org:8.8.8.8 busybox / # cat /etc/hosts 127.0.0.1 localhost ::1 localhost ip6-localhost ip6-loopback fe00::0 ip6-localnet ff00::0 ip6-mcastprefix ff02::1 ip6-allnodes ff02::2 ip6-allrouters 6.6.6.6 www.xxx.com 8.8.8.8 www.ttt.org 172.17.0.2 449bf0468efd

指定容器DNS

容器的dns服务器,默认采用宿主机的dns 地址,可以用下面方式指定其它的DNS地址

- 将dns地址配置在宿主机

- 在容器启动时加选项 –dns=x.x.x.x

- 在/etc/docker/daemon.json 文件中指定

#范例: 容器的DNS默认从宿主机的DNS获取 [root@ubuntu1804 ~]#systemd-resolve --status|grep -A1 -i "DNS Servers" DNS Servers: 180.76.76.76 223.6.6.6 [root@ubuntu1804 ~]#docker run -it --rm centos bash [root@1364f98c4227 /]# cat /etc/resolv.conf nameserver 180.76.76.76 nameserver 223.6.6.6 search xxx.com xxx.org [root@1364f98c4227 /]# exit exit #范例: 指定DNS地址 [root@ubuntu1804 ~]#docker run -it --rm --dns 1.1.1.1 --dns 8.8.8.8 centos bash #范例: 指定domain名 [root@ubuntu1804 ~]#docker run -it --rm --dns 1.1.1.1 --dns 8.8.8.8 --dns-search a.com --dns-search b.com busybox / # cat /etc/resolv.conf search a.com b.com nameserver 1.1.1.1 nameserver 8.8.8.8 #范例: 配置文件指定DNS和搜索domain名 [root@ubuntu1804 ~]#cat /etc/docker/daemon.json { "storage-driver": "overlay2", "registry-mirrors": ["https://si7y70hh.mirror.aliyuncs.com"], "dns" : [ "114.114.114.114", "119.29.29.29"], "dns-search": [ "xxx.com", "xxx.org"] } [root@ubuntu1804 ~]#systemctl restart docker [root@ubuntu1804 ~]#docker run -it --rm centos bash [root@7a2d8fac6f6b /]# cat /etc/resolv.conf #用--dns指定优先级更高 [root@ubuntu1804 ~]#docker run -it --rm --dns 8.8.8.8 --dns 8.8.4.4 centos bash [root@80ffe3547b87 /]# cat /etc/resolv.conf search xxx.com xxx.org nameserver 8.8.8.8 nameserver 8.8.4.4

容器内和宿主机之间复制文件

docker cp [OPTIONS] CONTAINER:SRC_PATH DEST_PATH|-

docker cp [OPTIONS] SRC_PATH|- CONTAINER:DEST_PATH

Options:

-a, --archive Archive mode (copy all uid/gid information)

-L, --follow-link Always follow symbol link in SRC_PATH

范例:

#将容器内文件复制到宿主机 [root@ubuntu1804 ~]#docker run -itd centos 1311fe67e6708dac71c01f7d1752a6dcb5e85c2f1fa4ac2efcef9edfe4fb6bb5 [root@ubuntu1804 ~]#docker cp -a 1311:/etc/centos-release . [root@ubuntu1804 ~]#cat centos-release CentOS Linux release 8.1.1911 (Core) #将宿主机文件复制到容器内 [root@ubuntu1804 ~]#docker cp /etc/issue 1311:/root/ [root@ubuntu1804 ~]#docker exec 1311 cat /root/issue Ubuntu 18.04.1 LTS \n \l

使用 systemd 控制容器运行

[root@ubuntu1804 ~]#cat /lib/systemd/system/hello.service [Unit] Description=Hello World After=docker.service Requires=docker.service [Service] TimeoutStartSec=0 ExecStartPre=-/usr/bin/docker kill busybox-hello ExecStartPre=-/usr/bin/docker rm busybox-hello ExecStartPre=/usr/bin/docker pull busybox ExecStart=/usr/bin/docker run --name busybox-hello busybox /bin/sh -c "while true; do echo Hello World; sleep 1; done" ExecStop=/usr/bin/docker kill busybox-hello [Install] WantedBy=multi-user.target [root@ubuntu1804 ~]#systemctl daemon-reload [root@ubuntu1804 ~]#systemctl enable --now hello.service

传递环境变量

有些容器运行时,需要传递变量,可以使用 -e <参数> 或 –env-file <参数文件> 实现

范例: 传递变量创建MySQL

变量参考链接: https://hub.docker.com/_/mysql

#MySQL容器运行时需要指定root的口令 docker run --name mysql-test1 -v /data/mysql:/var/lib/mysql -e MYSQL_ROOT_PASSWORD=123456 -e MYSQL_DATABASE=wordpress -e MYSQL_USER=wpuser -e MYSQL_PASSWORD=123456 -d -p 3306:3306 mysql:5.7.30 docker run --name mysql-test2 -v /root/mysql/:/etc/mysql/conf.d -v /data/mysql2:/var/lib/mysql --envfile=env.list -d -p 3307:3306 mysql:5.7.30 [root@ubuntu1804 ~]#cat mysql/mysql-test.cnf [mysqld] server-id=100 log-bin=mysql-bin [root@ubuntu1804 ~]#cat env.list MYSQL_ROOT_PASSWORD=123456 MYSQL_DATABASE=wordpress MYSQL_USER=wpuser MYSQL_PASSWORD=wppass

Docker 镜像制作和管理

Docker 镜像说明

Docker 镜像中有没有内核

从镜像大小上面来说,一个比较小的镜像只有1MB多点或几MB,而内核文件需要几十MB, 因此镜像里面是没有内核的,镜像在被启动为容器后将直接使用宿主机的内核,而镜像本身则只提供相应的

rootfs,即系统正常运行所必须的用户空间的文件系统,比如: /dev/,/proc,/bin,/etc等目录,容器当中/boot目录是空的,而/boot当中保存的就是与内核相关的文件和目录。

为什么没有内核

由于容器启动和运行过程中是直接使用了宿主机的内核,不会直接调用物理硬件,所以也不会涉及到硬件驱动,因此也无需容器内拥有自已的内核和驱动。而如果使用虚拟机技术,对应每个虚拟机都有自已独立的内核

容器中的程序后台运行会导致此容器启动后立即退出

Docker容器如果希望启动后能持续运行,就必须有一个能前台持续运行的进程,如果在容器中启动传统的服务,如:httpd,php-fpm等均为后台进程模式运行,就导致 docker 在前台没有运行的应用,这样的容器启动后会立即退出。所以一般会将服务程序以前台方式运行,对于有一些可能不知道怎么实现前台运行的程序,只需要在你启动的该程序之后添加类似于 tail ,top 这种可以前台运行的程序即可. 比较常用的方法,如 `tail -f /etc/hosts` 。

范例:

#httpd ENTRYPOINT [ "/usr/sbin/apache2" ] CMD ["-D", "FOREGROUND"] #nginx ENTRYPOINT [ "/usr/sbin/nginx", "-g", "daemon off;" ] #用脚本运行容器 cat run_haproxy.sh #!/bin/bash haproxy -f /etc/haproxy/haproxy.cfg tail -f /etc/hosts tail -n1 Dockerfile CMD ["run_haproxy.sh"]

docker 镜像生命周期

制作镜像方式

Docker 镜像制作类似于虚拟机的镜像(模版)制作,即按照公司的实际业务需求将需要安装的软件、相关配置等基础环境配置完成,然后将其做成镜像,最后再批量从镜像批量生成容器实例,这样可以极大的简化相同环境的部署工作.

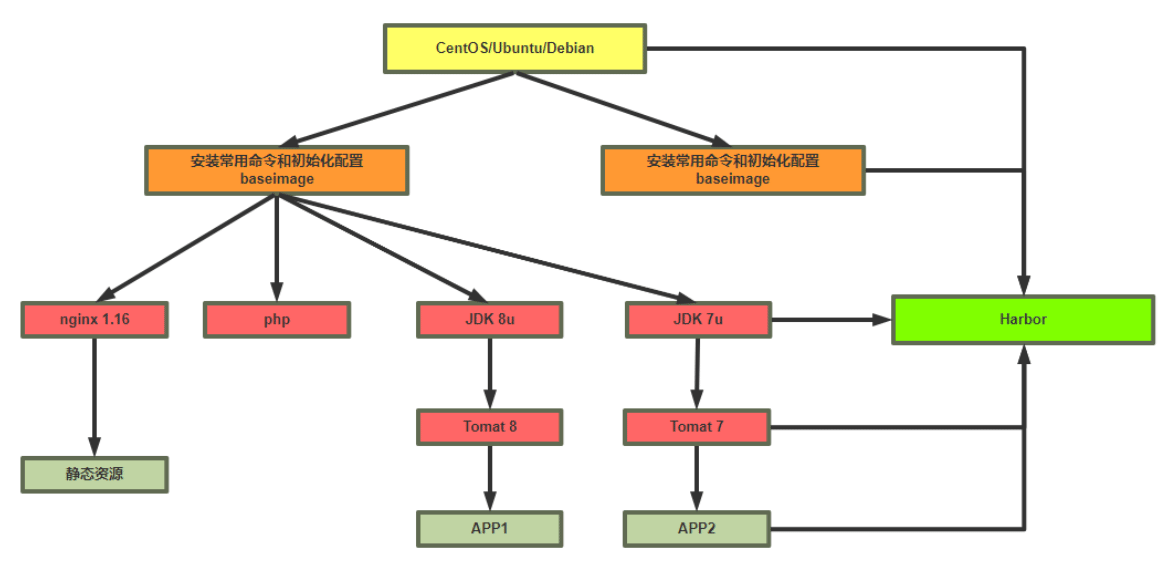

Docker的镜像制作分为手动制作(基于容器)和自动制作(基于DockerFile),企业通常都是基于Dockerfile制作镜像

docker commit #通过修改现有容器,将之手动构建为镜像 docker build #通过Dockerfile文件,批量构建为镜像

将现有容器通过 docker commit 手动构建镜像

基于容器手动制作镜像步骤

docker commit 格式

docker commit [OPTIONS] CONTAINER [REPOSITORY[:TAG]] #选项 -a, --author string Author (e.g., "John Hannibal Smith <[email protected]>") -c, --change list Apply Dockerfile instruction to the created image -m, --message string Commit message -p, --pause Pause container during commit (default true) #说明: 制作镜像和CONTAINER状态无关,停止状态也可以制作镜像 如果没有指定[REPOSITORY[:TAG]],REPOSITORY和TAG都为<none> 提交的时候标记TAG号: 生产当中常用,后期可以根据TAG标记创建不同版本的镜像以及创建不同版本的容器

基于容器手动制作镜像步骤具体如下:

- 下载一个系统的官方基础镜像,如: CentOS 或 Ubuntu

- 基于基础镜像启动一个容器,并进入到容器

- 在容器里面做配置操作

- 安装基础命令

- 配置运行环境

- 安装服务和配置服务

- 放业务程序代码

- 安装基础命令

- 提交为一个新镜像 docker commit

- 基于自己的的镜像创建容器并测试访问

实战案例: 基于 busybox 制作 httpd 镜像

[root@ubuntu1804 ~]#docker run -it --name b1 busybox / # ls bin dev etc home proc root sys tmp usr var / # mkdir /data/html -p / # echo httpd website in busybox > /data/html/index.html #格式1 [root@ubuntu1804 ~]#docker commit -a "user1<[email protected]>" -c 'CMD /bin/httpd -fv -h /data/html' -c "EXPOSE 80" b1 httpd-busybox:v1.0 #格式2 [root@ubuntu1804 ~]#docker commit -a "user1<[email protected]>" -c 'CMD ["/bin/httpd", "-f", "-v","-h", "/data/html"]' -c "EXPOSE 80" b1 httpdbusybox:v1.0 [root@ubuntu1804 ~]#docker run -d -P --name httpd01 httpd-busybox:v1.0 #对应格式1 [root@ubuntu1804 ~]#docker inspect -f "{{.Config.Cmd}}" httpd01 [/bin/sh -c /bin/httpd -f -h /data/html] #对应格式2 [root@ubuntu1804 ~]#docker inspect -f "{{.Config.Cmd}}" httpd01 [/bin/httpd -f -h /data/html] #再次制作镜像v2.0版 [root@ubuntu1804 ~]#docker commit -a "user1<[email protected]>" b1 httpdbusybox:v2.0 [root@ubuntu1804 ~]#docker run -d --name web2 -p 81:80 httpd-busybox:v2.0 /bin/httpd -fv -h /data/html

利用 DockerFile 文件执行 docker build 自动构建镜像

Dockfile 使用详解

Dockerfile 介绍

DockerFile 是一种被Docker程序解释执行的脚本,由一条条的命令组成的,每条命令对应linux下面的一条命令,Docker程序将这些DockerFile指令再翻译成真正的linux命令,其有自己的书写方式和支持的命令,Docker程序读取DockerFile并根据指令生成Docker镜像,相比手动制作镜像的方式,DockerFile更能直观的展示镜像是怎么产生的,有了DockerFile,当后期有额外的需求时,只要在之前的DockerFile添加或者修改响应的命令即可重新生成新的Docker镜像,避免了重复手动制作镜像的麻烦,类似与shell脚本一样,可以方便高效的制作镜像

Docker守护程序 Dockerfile 逐一运行指令,如有必要,将每个指令的结果提交到新镜像,然后最终输出新镜像的ID。Docker守护程序将自动清理之前发送的上下文请注意,每条指令都是独立运行的,并会导致创建新镜像,比如 RUN cd /tmp 对下一条指令不会有任何影响。

Docker将尽可能重用中间镜像层(缓存),以显著加速 docker build 命令的执行过程,这由 Using cache 控制台输出中的消息指示

Dockerfile 镜像制作和使用流程

Dockerfile文件的制作镜像的分层结构

范例:

#按照业务类型或系统类型等方式划分创建目录环境,方便后期镜像比较多的时候进行分类 [root@ubuntu1804 ~]#mkdir /data/dockerfile/{web/{nginx,apache,tomcat,jdk},system/{centos,ubuntu,alpine,debian}} -p [root@ubuntu1804 ~]#tree /data/dockerfile/ /data/dockerfile ├── system │ ├── alpine │ ├── centos │ ├── debian │ └── ubuntu └── web ├── apache ├── jdk ├── nginx └── tomcat 10 directories, 0 files

Dockerfile 文件格式

Dockerfile 是一个有特定语法格式的文本文件

dockerfile 官方说明: https://docs.docker.com/engine/reference/builder/

帮助: man 5 dockerfile

Dockerfile 文件说明

- 每一行以Dockerfile的指令开头,指令不区分大小写,但是惯例使用大写

- 使用 # 开始作为注释

- 每一行只支持一条指令,每条指令可以携带多个参数

- 指令按文件的顺序从上至下进行执行

- 每个指令的执行会生成一个新的镜像层,为了减少分层和镜像大小,尽可能将多条指令合并成一条指令

- 制作镜像一般可能需要反复多次,每次执行dockfile都按顺序执行,从头开始,已经执行过的指令已经缓存,不需要再执行,如果后续有一行新的指令没执行过,其往后的指令将会重新执行,所以为加速镜像制作,将最常变化的内容放下dockerfile的文件的后面

Dockerfile 相关指令

dockerfile 文件中的常见指令:

ADD COPY ENV EXPOSE FROM LABEL STOPSIGNAL USER VOLUME WORKDIR

- FROM: 指定基础镜像

定制镜像,需要先有一个基础镜像,在这个基础镜像上进行定制。

FROM 就是指定基础镜像,此指令通常必需放在Dockerfile文件第一个非注释行。后续的指令都是运行于此基准镜像所提供的运行环境

基础镜像可以是任何可用镜像文件,默认情况下,docker build会在docker主机上查找指定的镜像文件,在其不存在时,则会从Docker Hub Registry上拉取所需的镜像文件.如果找不到指定的镜像文件,docker build会返回一个错误信息

如何选择合适的镜像呢?

对于不同的软件官方都提供了相关的docker镜像,比如: nginx、redis、mysql、httpd、tomcat等服务类的镜像,也有操作系统类,如: centos、ubuntu、debian等。建议使用官方镜像,比较安全。

格式:

FROM [--platform=<platform>] <image> [AS <name>] FROM [--platform=<platform>] <image>[:<tag>] [AS <name>] FROM [--platform=<platform>] <image>[@<digest>] [AS <name>] #说明: --platform 指定镜像的平台,比如: linux/amd64, linux/arm64, or windows/amd64 tag 和 digest是可选项,如果不指定,默认为latest

说明: 关于scratch 镜像

FROM scratch 参考链接: https://hub.docker.com/_/scratch?tab=description https://docs.docker.com/develop/develop-images/baseimages/ 该镜像是一个空的镜像,可以用于构建busybox等超小镜像,可以说是真正的从零开始构建属于自己的镜像 该镜像在构建基础镜像(例如debian和busybox)或超最小镜像(仅包含一个二进制文件及其所需内容,例如:hello-world)的上下文中最有用。范例:

FROM scratch #所有镜像的起源镜像,相当于Object类 FROM ubuntu FROM ubuntu:bionic FROM debian:buster-slim

- LABEL: 指定镜像元数据

可以指定镜像元数据,如: 镜像作者等

LABEL <key>=<value> <key>=<value> <key>=<value> ...

范例:

LABEL "com.example.vendor"="ACME Incorporated" LABEL com.example.label-with-value="foo" LABEL version="1.0" LABEL description="This text illustrates \ that label-values can span multiple lines."

一个镜像可以有多个label ,还可以写在一行中,即多标签写法,可以减少镜像的的大小

范例: 多标签写法

#一行格式 LABEL multi.label1="value1" multi.label2="value2" other="value3" #多行格式 LABEL multi.label1="value1" \ multi.label2="value2" \ other="value3"

docker inspect 命令可以查看LABEL

MAINTAINER: 指定维护者信息

此指令已过时,用LABEL代替

MAINTAINER <name>

范例:

MAINTAINER xxx <[email protected]> #用LABEL代替 LABEL maintainer="xxx <[email protected]>"

- RUN: 执行 shell命令

RUN 指令用来在构建镜像阶段需要执行 FROM 指定镜像所支持的Shell命令。

通常各种基础镜像一般都支持丰富的shell命令

注意: RUN 可以写多个,每一个RUN指令都会建立一个镜像层,所以尽可能合并成一条指令,比如将多个shell命令通过 && 连接一起成为在一条指令

每个RUN都是独立运行的,和前一个RUN无关

#shell 格式: 相当于 /bin/sh -c <命令> 此种形式支持环境变量 RUN <命令> #exec 格式: 此种形式不支持环境变量,注意:是双引号,不能是单引号 RUN ["可执行文件", "参数1", "参数2"] #exec格式可以指定其它shell RUN ["/bin/bash","-c","echo hello user1"]

说明:

shell格式中,<command>通常是一个shell命令,且以"/bin/sh -c”来运行它,这意味着此进程在容器中的PID不为1,不能接收Unix信号,因此,当使用docker stop <container>命令停止容器时,此进程接收不到SIGTERM信号 exec格式中的参数是一个JSON格式的数组,其中<executable>为要运行的命令,后面的<paramN>为传递给命令的选项或参数;然而,此种格式指定的命令不会以"/bin/sh -c"来发起,因此常见的shell操作如变量替换以及通配符(?,*等)替换将不会进行;不过,如果要运行的命令依赖于此shell特性的话,可以将其替换为类似下面的格式。 RUN ["/bin/bash", "-c", "<executable>", "<param1>"]

范例:

RUN echo '<h1>Hello, Docker!</h1>' > /usr/share/nginx/html/index.html RUN ["/bin/bash", "-c", "echo hello world"] RUN yum -y install epel-release \ && yum -y install nginx \ && rm -rf /usr/share/nginx/html/* && echo "<h1> docker test nginx </h1>" > /usr/share/nginx/html/index.html

范例: 多个 前后RUN 命令独立无关和shell命令不同

#world.txt并不存放在/app内 RUN cd /app RUN echo "hello" > world.txt

- ENV: 设置环境变量

ENV 可以定义环境变量和值,会被后续指令(如:ENV,ADD,COPY,RUN等)通过\(KEY或\){KEY}进行引用,并在容器运行时保持

#变量赋值格式1 ENV <key> <value> #此格式只能对一个key赋值,<key>之后的所有内容均会被视作其<value>的组成部分 #变量赋值格式2 ENV <key1>=<value1> <key2>=<value2> \ #此格式可以支持多个key赋值,定义多个变量建议使用,减少镜像层 <key3>=<value3> ... #如果<value>中包含空格,可以以反斜线\进行转义,也可通过对<value>加引号进行标识;另外,反斜线也可用于续行 #只使用一次变量 RUN <key>=<value> <command> #引用变量 RUN $key ..... #变量支持高级赋值格式 ${key:-word} ${kye:+word}

如果运行容器时如果需要修改变量,可以执行下面通过基于 exec 机制实现

注意: 下面方式只影响容器运行时环境,而不影响构建镜像的过程,即只能覆盖docker run时的环境变量,而不会影响docker build时环境变量的值

docker run -e|--env <key>=<value> #说明 -e, --env list #Set environment variables --env-file filename #Read in a file of environment variables范例:

示例: 两种格式功能相同

#格式1 ENV myName="John Doe" myDog=Rex\ The\ Dog \ myCat=fluffy #格式2 ENV myName John Doe ENV myDog Rex The Dog ENV myCat fluffy

范例:

ENV VERSION=1.0 DEBUG=on NAME="Happy Feet" ENV PG_MAJOR 9.3 ENV PG_VERSION 9.3.4 RUN curl -SL http://example.com/postgres-$PG_VERSION.tar.xz | tar -xJC /usr/src/postgress && … ENV PATH /usr/local/postgres-$PG_MAJOR/bin:$PATH

范例:

[root@ubuntu1804 dockerfile]#cat Dockerfile FROM busybox LABEL maintainer="xxx <[email protected]>" ENV NAME user1 RUN touch $NAME.txt [root@ubuntu1804 dockerfile]#cat build.sh #!/bin/bash # TAG=$1 docker build -t test:$TAG . [root@ubuntu1804 dockerfile]#./build.sh v5.0 [root@ubuntu1804 dockerfile]#docker run --rm --name c1 test:v5.0 env PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin HOSTNAME=d4e1f89aca71 NAME=user1 cici HOME=/root [root@ubuntu1804 dockerfile]#docker run --rm -e NAME=cici --name c1 test:v5.0 env PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin HOSTNAME=b23500aa100d NAME=cici HOME=/root

- COPY: 复制文本

复制本地宿主机的 到容器中的 。

COPY [--chown=<user>:<group>] <src>... <dest> COPY [--chown=<user>:<group>] ["<src>",... "<dest>"] #路径中有空白字符时,建议使用此格式

说明:

- 可以是多个,可以使用通配符,通配符规则满足Go的filepath.Match 规则filepath.Match 参考链接: https://golang.org/pkg/path/filepath/#Match

- 必须是build上下文中的路径(为 Dockerfile 所在目录的相对路径), 不能是其父目录中的文件

- 如果是目录,则其内部文件或子目录会被递归复制, 但目录自身不会被复制

- 如果指定了多个, 或在中使用了通配符,则必须是一个目录, 且必须以 / 结尾

- 可以是绝对路径或者是 WORKDIR 指定的相对路径

- 使用 COPY 指令,源文件的各种元数据都会保留。比如读、写、执行权限、文件变更时间等

- 如果事先不存在,它将会被自动创建,这包括其父目录路径,即递归创建目录

范例:

COPY hom* /mydir/ COPY hom?.txt /mydir/

- 可以是多个,可以使用通配符,通配符规则满足Go的filepath.Match 规则filepath.Match 参考链接: https://golang.org/pkg/path/filepath/#Match

- ADD: 复制和解包文件

该命令可认为是增强版的COPY,不仅支持COPY,还支持自动解缩。可以将复制指定的 到容器中的

ADD [--chown=<user>:<group>] <src>... <dest> ADD [--chown=<user>:<group>] ["<src>",... "<dest>"]如果是目录,只复制目录中的内容,而非目录本身

说明:

- 可以是Dockerfile所在目录的一个相对路径;也可是一个 URL;还可是一个 tar 文件(自动解压)

- 可以是绝对路径或者是 WORKDIR 指定的相对路径

- 如果是一个 URL ,下载后的文件权限自动设置为 600

- 如果为URL且不以/结尾,则指定的文件将被下载并直接被创建为,如果以 / 结尾,则文件名URL指定的文件将被直接下载并保存为/< filename>

- 如果是一个本地文件系统上的打包文件,如: gz, bz2 ,xz ,它将被解包 ,其行为类似于"tar -x"命令,但是通过URL获取到的tar文件将不会自动展开

- 如果有多个,或其间接或直接使用了通配符,则必须是一个以/结尾的目录路径;如果不以/结尾,则其被视作一个普通文件,的内容将被直接写入到

范例:

ADD test relativeDir/ # adds "test" to `WORKDIR`/relativeDir/ ADD test /absoluteDir/ # adds "test" to /absoluteDir/ ADD --chown=55:mygroup files* /somedir/ ADD --chown=bin files* /somedir/ ADD --chown=1 files* /somedir/ ADD --chown=10:11 files* /somedir/ ADD ubuntu-xenial-core-cloudimg-amd64-root.tar.gz /

- 可以是Dockerfile所在目录的一个相对路径;也可是一个 URL;还可是一个 tar 文件(自动解压)

- CMD: 容器启动命令

一个容器中需要持续运行的进程一般只有一个,CMD 用来指定启动容器时默认执行的一个命令,且其运行结束后,容器也会停止,所以一般CMD 指定的命令为持续运行且为前台命令.

- 如果docker run没有指定任何的执行命令或者dockerfile里面也没有ENTRYPOINT,那么开启容器时就会使用执行CMD指定的默认的命令

- 前面介绍过的 RUN 命令是在构建镜像进执行的命令,注意二者的不同之处

- 每个 Dockerfile 只能有一条 CMD 命令。如指定了多条,只有最后一条被执行

- 如果用户启动容器时用 docker run xxx 指定运行的命令,则会覆盖 CMD 指定的命令

- 如果 Dockerfile 中有 ENTRYPOINT 命令,CMD 充当其默认参数

# 使用 exec 执行,推荐方式,第一个参数必须是命令的全路径,此种形式不支持环境变量 CMD ["executable","param1","param2"] # 在 /bin/sh 中执行,提供给需要交互的应用;此种形式支持环境变量 CMD command param1 param2 # 提供给 ENTRYPOINT 命令的默认参数 CMD ["param1","param2"]

范例:

CMD ["nginx", "-g", "daemon off;"]

范例:

cat Dockerfile FROM ubuntu:18.04 LABEL maintainer="xxx <[email protected]>" RUN apt update \ && apt -y install curl \ && rm -rf /var/lib/apt/lists/* CMD [ "curl", "-s","https://ip.cn"] [root@centos8 ubuntu]#podman run 9b {"ip": "111.199.187.36", "country": "北京市", "city": "联通"} #cat /etc/etc/issue覆盖了curl命令 [root@centos8 ubuntu]#podman run 9b cat /etc/issue Ubuntu 18.04.4 LTS \n \l

- 如果docker run没有指定任何的执行命令或者dockerfile里面也没有ENTRYPOINT,那么开启容器时就会使用执行CMD指定的默认的命令

- ENTRYPOINT: 入口点

功能类似于CMD,配置容器启动后执行的命令及参数

# 使用 exec 执行 ENTRYPOINT ["executable", "param1", "param2"] # shell中执行 ENTRYPOINT command param1 param2

- ENTRYPOINT 不能被 docker run 提供的参数覆盖,而是追加,即如果docker run 命令有参数,那么参数全部都会作为ENTRYPOINT的参数

- 如果docker run 后面没有额外参数,但是dockerfile中的CMD里有(即上面CMD的第三种用法),即Dockerfile中即有CMD也有ENTRYPOINT,那么CMD的全部内容会作为ENTRYPOINT的参数

- 如果docker run 后面有额外参数,同时Dockerfile中即有CMD也有ENTRYPOINT,那么docker run后面的参数覆盖掉CMD参数内容,最终作为ENTRYPOINT的参数

- 可以通过docker run –entrypoint string 参数在运行时替换,注意string不要加空格

- 使用CMD要在运行时重新写命令本身,然后在后面才能追加运行参数,ENTRYPOINT则可以运行时无需重写命令就可以直接接受新参数

- 每个 Dockerfile 中只能有一个 ENTRYPOINT,当指定多个时,只有最后一个生效

范例:

[root@ubuntu1804 ~]#docker run -it --entrypoint cat alpine /etc/issue Welcome to Alpine Linux 3.12 Kernel \r on an \m (\l) [root@ubuntu1804 dockerfile]#cat Dockerfile FROM ubuntu:18.04 RUN apt update \ && apt -y install curl \ && rm -rf /var/lib/apt/lists/* ENTRYPOINT [ "curl", "-s","https://ip.cn"] [root@centos8 dockerfile]#podman run -it --rm f68e006 {"ip": "111.199.187.36", "country": "北京市", "city": "联通"} #追加-i参数 [root@centos8 dockerfile]#podman run -it --rm f68e006 -i HTTP/2 200 date: Sun, 23 Feb 2020 08:05:19 GMT content-type: application/json; charset=UTF-8 set-cookie: __cfduid=d4a22496ea6f3b2861763354f8ca600711582445119; expires=Tue, 24-Mar-20 08:05:19 GMT; path=/; domain=.ip.cn; HttpOnly; SameSite=Lax cf-cache-status: DYNAMIC expect-ct: max-age=604800, report-uri="https://report-uri.cloudflare.com/cdncgi/beacon/expect-ct" alt-svc: h3-25=":443"; ma=86400, h3-24=":443"; ma=86400, h3-23=":443"; ma=86400 server: cloudflare cf-ray: 5697b1ac1862eb41-LAX {"ip": "111.199.187.36", "country": "北京市", "city": "联通"}

范例: 利用脚本实现指定环境变量动态生成配置文件内容

[root@ubuntu1804 ~]#echo 'Nginx Website in Dockerfile' > index.html [root@ubuntu1804 ~]#cat Dockerfile FROM nginx:1.16-alpine LABEL maintainer="xxx <[email protected]>" ENV DOC_ROOT='/data/website/' ADD index.html ${DOC_ROOT} ADD entrypoint.sh /bin/ EXPOSE 80/tcp 8080 #HEALTHCHECK --start-period=3s CMD wget -0 - -q http://${IP:-0.0.0.0}: {PORT:-80}/ CMD ["/usr/sbin/nginx","-g", "daemon off;"] #CMD指令的内容都成为了ENTRYPOINT的参数 ENTRYPOINT [ "/bin/entrypoint.sh"] [root@ubuntu1804 ~]#cat entrypoint.sh #!/bin/sh cat > /etc/nginx/conf.d/www.conf <<EOF server { server_name ${HOSTNAME}; listen ${IP:-0.0.0.0}:${PORT:-80}; root ${DOC_ROOT:-/usr/share/nginx/html}; } EOF exec "$@" [root@ubuntu1804 ~]#chmod +x entrypoint.sh [root@ubuntu1804 ~]#docker build -t nginx:v1.0 . [root@ubuntu1804 ~]#docker run --name n1 --rm -P -e "PORT=8080" -e "HOSTNAME=www.xxx.org" nginx:v1.0