Python:爬虫技术

- TAGS: Python

概述

爬虫,应该称为网络爬虫,也叫网页蜘蛛、网络机器人、网络蚂蚁等。

搜索引擎,就是网络爬虫的应用者。

为什么到了今天,反而这个词汇被频繁的提起呢?有搜索引擎不就够了吗?

实际上,大数据时代的到了,所有的企业都希望通过海量数据发现其中的价值。

所以,需要爬取对特定网站、特定类别的数据,而搜索引擎不能提供这样的功能,因此,需要自己开发爬虫来解决。

1991年,CERN诞生第一个WWW网站。慢慢地更多的网站涌现出来来。

网站多了,不方便找。最早,人工收集各种网站分门别类组织成网页。但是不能知道这么多网站的网页中是否有关心的数据。由此,出现了爬虫程序。

爬虫是一个程序,使用HTTP协议。网站只需要提供一个网页,往往是首页,从首页开始获取有用的数据,通过首页中的链接继续探索其他页面,将这些页面内容传输给爬虫程序。

有了爬虫,就出现了雅虎这样的搜索引擎站点。后来,拉里佩奇、谢盖而布林,凭借搜索引擎算法于1998年创建了谷歌公司。

保存?

- Hadoop 大数据 HDFS, Mapreduce, HBASE

内容分词,一篇文章所有可能关键字->这篇文章的映射 存入倒排索引库

- solr, ElasticSearch

pagerank 算法,排名问题

爬虫分类

1.通用爬虫

常见就是搜索引擎,无差别的搜集数据、存储、提取关键字、构建索引库,给用户提供搜索接口。

爬取一般流程

- 初始化一批URL,将这些URL放到带爬队列

- 从队列取出这些URL,通过DNS解析IP,对IP对应的站点下载HTML页面,保存到本地服务器中,爬取完的URL放到已爬取队列。

- 分析这些网页内容,找出网页里面的其他关心的URL链接,继续执行第2步,直到爬取条件结束。

搜索引擎如何获取一个网站的URL

- 新网站主动提交给搜索引擎

- 通过其他网站页面中设置的外链接

- 搜索引擎和DNS服务商合作,获取最新收录的网站

2. 聚焦爬虫

有针对性的编写特定领域数据的爬取程序,针对某些类别数据采集的爬虫,是面向主题的爬虫

Robots协议

指定一个robots.txt文件,告诉爬虫引擎什么可以爬取

- / 表示网站根目录,表示网站所有目录。

- Allow 允许爬取的目录

- Disallow 禁止爬取的目录

- 可以使用通配符

robots是一个君子协定,"爬亦有道"

这个协议为了让搜索引擎更有效率搜索自己内容,提供了Sitemap这样的文件。Sitemap往往是一个XML文件,提供了网站想让大家爬取的内容的更新信息。

这个文件禁止爬取的往往又是可能我们感兴趣的内容,反而泄露了这些地址。

示例:淘宝的robotshttp://www.taobao.com/robots.txt

User-agent: Baiduspider Allow: /article Allow: /oshtml Allow: /ershou Allow: /$ Disallow: /product/ Disallow: / User-Agent: Googlebot Allow: /article Allow: /oshtml Allow: /product Allow: /spu Allow: /dianpu Allow: /oversea Allow: /list Allow: /ershou Allow: /$ Disallow: / User-agent: Bingbot Allow: /article Allow: /oshtml Allow: /product Allow: /spu Allow: /dianpu Allow: /oversea Allow: /list Allow: /ershou Allow: /$ Disallow: / User-Agent: 360Spider Allow: /article Allow: /oshtml Allow: /ershou Disallow: / User-Agent: Yisouspider Allow: /article Allow: /oshtml Allow: /ershou Disallow: / User-Agent: Sogouspider Allow: /article Allow: /oshtml Allow: /product Allow: /ershou Disallow: / User-Agent: Yahoo! Slurp Allow: /product Allow: /spu Allow: /dianpu Allow: /oversea Allow: /list Allow: /ershou Allow: /$ Disallow: / User-Agent: * Disallow: /

示例马蜂窝tobotshttp://www.mafengwo.cn/robots.txt

User-agent: * Disallow: / Disallow: /poi/detail.php Sitemap: http://www.mafengwo.cn/sitemapIndex.xml

法律知识

中国爬虫违法违规案例汇总: https://github.com/HiddenStrawberry/Crawler_Illegal_Cases_In_China

单位犯罪和个人犯罪的关系

首先了解一下单位犯罪。除了自然人犯罪,还有单位犯罪,是指公司、企业、事业单位、机关、团体为单位谋取不利益,经单位决策机构或者负责人决定实施的,法律规定应当负刑事责任的危害社会的行行为。

我国刑法对单位犯罪原则上采取双罚制度,即单位犯罪的为,对单位判处罚金,并对其直接负责的主管人员和其他直接责任人员判处刑罚。相关司法解释规定,在审理单位故意犯罪案件时,对其直接负责的主管人员和其他直接责任人员,可不区分主犯、从犯,按照其在单位犯罪中所起的作用判处刑罚。

因此,公司犯罪有可能会牵连员工,尤其是案件中对非法获取数据有直接责任的爬虫工程师。这也是为什么当事人在公公司人小言微但还是被批捕的原因。

其次,是否可以"不知者不为罪"来辩解?刑法原则之一是法无明文规定不为罪,并没有"不知者不为罪"。主观上的恶意是衡量犯罪的要素之一,结合客观上的行为来推理主观恶意。破解别人的服务器,获取别人不公开的信息,不能说没有恶意,不能以不懂法来糖塞。

重点: 什么样的爬虫是违法?

如果爬虫程序采集到公民的姓名、身份证件号码、通信通讯取关系方式、住址、账号密码、财产状况、行踪轨迹等个人信息,并将之用于非法途径的,则肯定构成非法获取公民个人信息的违法行为。

除此之外,根据相关规定,对于违反国家有关规定,向他人出售或者提供公民个人信息,情节严重的,窃取或者以其他方法非法获取公民个人信息的,均可构成成"侵犯公民个人信息罪",处三年以下有期徒刑或者拘役,并处或者单处罚金;情节特别严重的,处三年以上七年以下有期徒刑,并处罚金。

重点关注:下列情况下,爬虫有可能违法,严重的甚甚至构成犯罪。

- 爬虫程序规避网站经营者设置的反爬虫措施或者破解服务器防抓取措施,非法获取相关信息,情节严重的,有可能能构成"非法获取计算机信息系统数据罪"。

- 爬虫程序干扰被访问的网站或系统正常运营,后果严重的,触犯刑法,构成"破坏计算机信息系统罪"

- 爬虫采集的信息属于公民个人信息的,有可能构成非法获取公民个人信息的违法行为,情节严重的,有可能构成"侵犯公民个人信息罪"。

HTTP请求和响应处理

其实爬取网页就是通过HTTP协议访问网页,不过通过浏览器反问往往是人的行为,把这种行为变成使用程序来访问。

urllib包

urllib是标准库,它一个工具包模块,包含下面模块来处理url:

- urllib.request 用于打开和读写url

- urllib.error 包含了由urllib.request引起的异常

- urllib.parse 用于解析url

- urllib.robotparser 分析robots.txt文件

Python2中提供了urllib和urllib2。urllib提供较为底层的接口,urllib2对urllib进行了进一步封装。

Python3中将urllib合并到了urllib2中,并更名为标准库urllib包。

urllib.request模块

模块定义了在基本和摘要式身份验证、重定向、cookies等应用中打开Url(主要是HTTP)的函数和类。

urlopen方法

urlopen(url,data=None)

- url是链接地址字符串,或请求类的实例

- data提交的数据,如果data为Non发起的 GET 请求,否则发起 POST 请求。见

urllib.request.Request#get_method - 返回http.client.HTTPResponse类的相遇对象,这是一个类文件对象。

from urllib.request import urlopen from http.client import HTTPResponse # 很简陋 # request 发起请求都和它有关 # urlopen(url, data=None) # data不为None就是POST请求 # 打开一个url返回一个相应对象,类文件对象 # 下面链接访问后会有跳转 response:HTTPResponse = urlopen('https://www.bing.com') # request -> response GET with response: print(type(response), response) #http.client.HTTPResponse类文件对象 print(response.status, response.reason) # 状态 200 OK print(response.headers) # response.headers 和 response.info()是一个东西 print(response.geturl()) # 返回真正的URL 301 302 重定向后的url https://cn.bing.com/ print(response.read()) # bytes # bytes -> str? print(response.isclosed()) print(response.closed)

上例,通过urllib.request.urlopen方法,发起一个HTTP的GET请求,WEB服务器返回了网页内容。

响应的数据被封装到类文件对象中,可以通过read方法、readline方法、readlines方法获取数据,status和reason属性表示返回的状态码,info方法返回头信息,等等。

注意url的变化,说明重定向过。

User-Agent问题

上例代码非常精简,即可以获得网站的响应数据。但目前urlopen方法通过url字符串和data发起HTTP的请求。如果想修改HTTP头,例如useragent,就的借助其他方式。

原码中构造的useragen如下:

# urllib.request.OpenerDirector class OpenerDirector: def __init__(self): client_version = "Python-urllib/%s" % __version__ self.addheaders = [('User-agent', client_version)]

当前显示为Python-urlib/3.13

有些网站是反爬虫的,所以要把爬虫伪装成浏览器。顺便打开一个浏览器,复制李立群的UA值,用来伪装。

https://httpbin.org/#/HTTP_Methods/get_get

from urllib.request import urlopen from http.client import HTTPResponse # 很简陋 # request 发起请求都和它有关 # urlopen(url, data=None) # data不为None就是POST请求 # 判断爬虫最简单的方式,通用user-agent解读、通过行为判断(正常人不可能点那么快) # 1. 伪装 ua = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/138.0.0.0 Safari/537.36' # site = 'https://www.bing.com' site = 'https://httpbin.org/get' response:HTTPResponse = urlopen(site) # request -> response GET # 每一个request请求时都会带上 with response: print(type(response), response) #http.client.HTTPResponse类文件对象 print(response.status, response.reason) # 状态 200 OK print(response.headers) # response.headers 和 response.info()是一个东西 print(response.geturl()) # 返回真正的URL 301 302 重定向后的url print(response.read()) # bytes # bytes -> str? # 请求头 "User-Agent": "Python-urllib/3.13" print(response.isclosed()) print(response.closed)

Request类

Request(url,data=None,headers={})

- 初始化方法,构造一个请求对象。

- 可添加一个header的字典。

- data参数决定是GET还是POST请求,参看Request.get_method()方法

obj.add_header(key,val)为header增加一个键值对。

from urllib.request import urlopen, Request from http.client import HTTPResponse # 很简陋 import random # request 发起请求都和它有关 # urlopen(url, data=None) # data不为None就是POST请求 site = 'https://www.bing.com' site = 'https://httpbin.org/get' # 判断爬虫最简单的方式,通用user-agent解读、通过行为判断(正常人不可能点那么快) # 1. 伪装 ua_list = [ "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/138.0.0.0 Safari/537.36", # chrome "Mozilla/5.0 (Windows; U; Windows NT 6.1; zh-CN) AppleWebKit/537.36 (KHTML, like Gecko) Version/5.0.1 Safari/537.36", # safafi "Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:50.0) Gecko/20100101 Firefox/50.0", # Firefox "Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; Trident/5.0)" # IE ] ua = random.choice(ua_list) # 构造request对象 request = Request(site) request.add_header('User-Agent', ua) # 很重要,通过它可以对移动端做出更友好的体验 Native App, Web App http请求 response:HTTPResponse = urlopen(request, timeout=20) # request对象或者url都可以 # 每一个request请求时都会带上 with response: print(type(response), response) #http.client.HTTPResponse类文件对象 print(response.status, response.reason) # 状态 200 OK print(response.headers) # response.headers 和 response.info()是一个东西 print(response.geturl()) # 返回真正的URL 301 302 重定向后的url print(response.read()) # bytes # bytes -> str? # 请求头 "User-Agent": "Python-urllib/3.13" print(response.isclosed()) print(response.closed)

urllib.parse模块

该模块可以完成对url的编解码

- parse.urlencode({key:value}) #对查询字符串进行编码

from urllib import parse u = parse.urlencode({ "url":"http://www.xx.com/python", "p_url":"http://www.xx.com/python?id=1&name=张三" }) print(u) # 运行结果 url=http%3A%2F%2Fwww.xx.com%2Fpython&p_url=http%3A%2F%2Fwww.xx.com%2Fpython%3Fid%3D1%26name%3D%E5%BC%A0%E4%B8%89

从运行结果来看冒号、斜杠、&、等号、问号等符号全部被编码了,%之后实际上是单字节十六进制表示的值。

一般来说url中的地址部分,一般不需要使用中文路径,但是参数部分,不管GET还是POST方法,提交的数据中,可能有斜杆、等号、问号等符号,这样这些字符表示数据,不表示元字符。如果直接发给服务器端,就会导致接收方无法判断谁是元字符,谁是数据了。为了安全,一般会将数据部分的字符做url编码,这样就不会有歧义了。

后来可以传送中文,同样会做编码,一般先按照字符集的encoding要求转换成字节序列,每一个字节对应的十六进制字符串前加上百分号即可。

# 页面使用utf-8编码 # https://www.baidu.com/s?wd=中 # 上面的url编码后,如下 # https://www.baidu.com/s?wd=%E4%B8%AD from urllib import parse u = parse.urlencode({"wd":"中"}) #编码 url= "https://www.baidu.com/s?{}".format(u) print(url) print("中".encode("utf-8")) # b'xe4\xb8\xad' print(parse.unquote(u)) #解码 print(parse.unquote(url))

提交方法method

常用的HTTP交互数据的方法是GET、POST

- GET方法,数据是通过URL传递的,也就是说数据是在HTTP报文的header部分。

- POST方法,数据是放在HTTP报文的body部分提交的。

- 数据是键值对形式,多个参数质检使用&符号链接。例如a=1&b=abc

GET方法

链接 必应 搜索引擎官网,获取一个搜索的URL http://cn.bing.com/search?q=jasper

需求

- 请写程序完成对关键字bing搜索,将返回的结果保存到一个网页文件。

from urllib.request import Request, urlopen from urllib import parse baseurl = 'https://cn.bing.com/search' params = parse.urlencode({ 'q':'jasper' }) url = "{}?{}".format(baseurl, params) print(url) ua = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/138.0.0.0 Safari/537.36' request = Request(url, headers={'user-agent':ua}) with urlopen(request) as response: # print(response.read()) with open('d:/tmp/a.html', 'wb') as f: f.write(response.read())

POST方法

测试网站

from urllib.request import Request, urlopen from urllib import parse import simplejson url = 'https://httpbin.org/post' params = parse.urlencode({ 'q':'jasper' }) ua = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/138.0.0.0 Safari/537.36' request = Request(url, headers={ 'X-REQUEST':'CICI', 'user-agent':ua }) with urlopen(request, params.encode('utf-8')) as response: print(simplejson.loads(response.read()))

执行结果

{

'args': {

},

'data': '',

'files': {

},

'form': {

'q': 'jasper'

},

'headers': {

'Accept-Encoding': 'identity',

'Content-Length': '8',

'Content-Type': 'application/x-www-form-urlencoded',

'Host': 'httpbin.org',

'User-Agent': 'Mozilla/5.0(WindowsNT10.0;Win64;x64)AppleWebKit/537.36(KHTML,

likeGecko)Chrome/138.0.0.0Safari/537.36',

'X-Amzn-Trace-Id': 'Root=1-68932b41-6306d8875659ae8129ecb0ad',

'X-Request': 'CICI'

},

'json': None,

'origin': '101.71.195.151',

'url': 'https: //httpbin.org/post'

}

处理JSON数据

XMLHttpRequest(简称xhr),是浏览器提供的JS对象,通过它可以请求到服务器上的数据资源。

访问:https://movie.douban.com/ 查看“豆瓣电影”,中的热门电影, 通过分析,我们知道这部分内容,是通过AJAX从后台拿到的JSON数据并插入到网页。

- 浏览器F12,过滤XHR,js请求返回json数据。如

- https://movie.douban.com/j/search_subjects?type=movie&tag=%E7%83%AD%E9%97%A8&page_limit=50&page_start=0

%E7%83%AD%E9%97%A8是utf-8编码的中文”热门”- tag 标签”热门”,表示热门电影

- type 数据类型,movie是电影

- page_limit表示返回数据的总数

- page_start 表示数据偏移

- https://movie.douban.com/j/search_subjects?type=movie&tag=%E7%83%AD%E9%97%A8&page_limit=50&page_start=0

服务器返回json数据如下(略,轮播组件,共50条数据)

from urllib.request import Request, urlopen from urllib import parse import json url = 'https://httpbin.org/post' url = 'https://movie.douban.com/j/search_subjects' params = parse.urlencode({ "tag":"热门", "type": "movie", "page_limit": 5, "page_start": 0 # 偏移 }) url = "{}?{}".format(url, params) ua = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/138.0.0.0 Safari/537.36' # POST request = Request(url, headers={ 'user-agent':ua }) with urlopen(request, params.encode('utf-8')) as response: # urlopen(url, data) data不为None就是POST请求 print(response.status, response.reason, '++++') j = json.loads(response.read()) print(len(j['subjects'])) print('-'*30)

HTTPS证书忽略

HTTPS使用SSL安全套层协议,在传输层对网络数据进行加密。HTTPS使用的时候需要证书,而证书需要CA认证。

CA(Certificate Authority)是数字证书认证中心的简称,是指发放、管理、废除数字证书的机构。

CA是受信任的第三方,有CA签发的证书具有可信任。如果用户由于信任了CA签发的证书导致的损失,可以追究CA的法律责任。

CA是层级结构,下级CA信任上级CA,且有上级CA颁发给下级CA证书并认证。

一些网站,例如淘宝,使用HTTPS加密数据更加安全。

以前旧版本12306网站需要下载证书

from urllib.request import Request,urlopen # request = Request("http://www.12306.cn/mormhweb/") #可以访问 # request = Request("https://www.baidu.com/") #可以访问 request = Request("https://www.12306.cn/mormhweb/") #旧版本报SSL认证异常 request.add_header( "User-agent", "Mozilla/5.0 (Windows; U; Windows NT 6.1; zh-CN) AppleWebKit/537.36 (KHTML, like Gecko) Version/5.0.1 Safari/537.36" ) # ssl.CertificateError: hostname 'www.12306.cn' doesn't match either of ...... with urlopen(request) as res: print(res._method) print(res.read())

通过HTTPS访问12306的时候,失败的原因在于12306的证书未通过CA认证,1它是自己生成的证书,不可信。而其它网站访问,如https://www.baidu.com/%E5%B9%B6%E6%B2%A1%E6%9C%89%E6%8F%90%E7%A4%BA%E7%9A%84%E5%8E%9F%E5%9B%A0%EF%BC%8C%E5%AE%83%E7%9A%84%E8%AF%81%E4%B9%A6%E7%9A%84%E5%8F%91%E8%A1%8C%E8%80%85%E5%8F%97%E4%BF%A1%E4%BB%BB%EF%BC%8C%E4%B8%94%E6%97%A9%E5%B0%B1%E5%AD%98%E5%82%A8%E5%9C%A8%E5%BD%93%E5%89%8D%E7%B3%BB%E7%BB%9F%E4%B8%AD。

现在12306证书是可信机构颁发的了。

遇到这种问题,解决思路:忽略证书不安全信息

from urllib.request import Request,urlopen import ssl #导入ssl模块 # request = Request("http://www.12306.cn/mormhweb/") #可以访问 # request = Request("https://www.baidu.com/") #可以访问 request = Request("https://www.12306.cn/mormhweb/") #旧版本报SSL认证异常 request.add_header( "User-agent", "Mozilla/5.0 (Windows; U; Windows NT 6.1; zh-CN) AppleWebKit/537.36 (KHTML, like Gecko) Version/5.0.1 Safari/537.36" ) # 忽略不信任的证书 context = ssl._create_unverified_context() res = urlopen(request,context=context) # ssl.CertificateError: hostname 'www.12306.cn' doesn't match either of ...... with res: print(res._method) print(res.geturl()) print(res.read().decode())

urllib3库

https://urllib3.readthedocs.io/en/latest/

标准库urlib缺少了一些关键的功能,非标准库的第三方库urllib3提供了,比如说连接池管理。

安装

pip install urllib3

测试一下网站访问,https://movie.douban.com

import urllib3 from urllib3 import PoolManager, HTTPResponse # pool = PoolManager() # http 对象 url = 'https://movie.douban.com/' ua = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/138.0.0.0 Safari/537.36' with PoolManager() as http: res:HTTPResponse = http.request('GET',url, headers={ 'user-agent':ua }) # print(type(res), res) print(res.status, res.reason) print(res.headers) with open('d:/tmp/a.html', 'wb') as f: f.write(res.data)

requests库**

requests使用了urllib3,但是API更加友好,推荐使用。

很多人做爬虫时基本都用requests,前面讲的都是基本原理,底层实现。

安装

pip install requests

测试一下网站访问,https://movie.douban.com

import requests ua = "Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/57.0.2987.133 Safari/537.36" url = "https://movie.douban.com/" response = requests.request("GET",url,headers={"User-Agent":ua}) with response: print(type(response)) print(response.url) print(response.status_code) print(response.request.headers) #请求头 print(response.headers) #响应头 response.encoding = "utf-8" print(response.text[:200]) #HTML的内容 with open('d:/movie.html',"w",encoding='utf-8') as f: f.write(response.text)

requests默认使用Session对象,是为了多次和服务器端交互中保留会话的信息,例如:cookie。

#直接使用Session import requests # pool = PoolManager() # http 对象 base_url = 'https://movie.douban.com/' ua = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/138.0.0.0 Safari/537.36' # 在同一个会话里发起2次请求 with requests.Session() as session: for url in [base_url, base_url]: response = session.get(base_url, headers={'user-agent':ua}) # response = requests.get(base_url, headers={'user-agent': ua}) #观察两种方式区别 # print(type(response), response) # print(response.__enter__()) with response: print(response.status_code, response.reason) print(response.encoding) print(response.cookies) print('=' * 30) print(*response.request.headers.items(), sep='\n') print('=' * 30) # print(*response.headers.items(), sep='\n') # print(response.content) # 内容 html文本 bytes # print(response.text) # 内容 html文本, content + encoding

使用session访问,第二次带上了cookie

HTML解析-Xpath

HTML的内容返回给浏览器,浏览器就会解析它,并对它渲染。

HTML超文本表示语言,设计的初衷就是为了超越普通文本,让文本表现力更强。

XML扩展标记语言,不是为了替代HTML,而是觉得HTML的设计中包含了过多的格式,承担了一部分数据之外的任务,所以才设计了XML只用来描述数据。

HTML和XML都有结构,使用标记形成树型的嵌套结构。DOM(Document Object Model)来解析这种嵌套树型结构,浏览器往往都提供了对DOM操作的API,可以用面向对象的方式来操作DOM。

XPath***

https://www.w3school.com.cn/xpath/index.asp 中文教程

XPath是一门在XML文档中查找信息的语言。XPath可用来在XML文档中对元素和属性进行遍历。

工具

测试工具:XMLQuire win7+需要.net框架4.0-4.5。

- 解压后,进入xmlquire\XMLQuireWin8\Application Files\XMLQuire_1_1_7_804目录下,打开XMLQuire.exe

测试XML、XPath

测试文档 books.xml

<?xml version="1.0" encoding="utf-8"?> <bookstore> <book id="bk101"> <author>Gambardella, Matthew</author> <title>XML Developer's Guide</title> <genre>Computer</genre> <price>44.95</price> <publish_date>2000-10-01</publish_date> <description>An in-depth look at creating applications with XML.</description> </book> <book id="bk102" class="bookinfo even"> <author>Ralls, Kim</author> <title>Midnight Rain</title> <genre>Fantasy</genre> <price>5.95</price> <publish_date>2000-12-16</publish_date> <description>A former architect battles corporate zombies, an evil sorceress, and her own childhood to become queen of the world.</description> </book> <book id="bk103"> <author>Corets, Eva</author> <title>Maeve Ascendant</title> <genre>Fantasy</genre> <price>5.95</price> <publish_date>2000-11-17</publish_date> <description>After the collapse of a nanotechnology society in England, the young survivors lay the foundation for a new society.</description> </book> <book id="bk104"> <author>Corets, Eva</author> <title>Oberon's Legacy</title> <genre>Fantasy</genre> <price>5.95</price> <publish_date>2001-03-10</publish_date> <description>In post-apocalypse England, the mysterious agent known only as Oberon helps to create a new life for the inhabitants of London. Sequel to Maeve Ascendant.</description> </book> </bookstore>

节点

在XPath中,有七种类型的节点:元素、属性、文本、命名空间、处理指令、注释以及文档(根)节点。

| 举例 | 说明 |

|---|---|

| <bookstore> | 元素节点 |

| <author>Corets,Eva</author> | 元素节点 |

| id="bk104" | 属性节点,id是元素节点book的属性 |

| 44.95 | 文本节点 |

节点之间的嵌套形成 父子(parent,children)关系 。

具有统一个父结点的不同节点是 兄弟(sibling)关系 。

节点选择

| 操作符或表达式 | 含义 |

|---|---|

| // | 从当前节点开始的任意层找 |

| . | 当前节点 |

| .. | 当前结点的父节点 |

| @ | 选择属性 |

| 节点名 | 选取所有这个节点名的节点 |

| * | 匹配任意元素节点 |

| @* | 匹配任意属性节点 |

| node() | 匹配任意类型的节点 |

| text() | 匹配text类型节点 |

谓语(Predicates)

- 谓语用来查找某个特定的节点或者包含某个指定的值的节点。

- 谓语被嵌在方括号中 。

- 谓语就是查询的条件。

- 即在路径选择时,在中括号内指定查询条件。

XPath轴(Axes)

轴的意思是相对于当前结点的节点集

| 轴名称 | 结果 |

|---|---|

| ancestor | 选取当前结点的所有先辈(父、祖父等) |

| ancestor-or-self | 选取当前节点的所有先辈(父、祖父等)以及当前节点本身 |

| attribute | 选取当前节点的所有属性。@id等价于attribute::id |

| child | 选取当前节点的所有子元素,title等价于child:title |

| descendant | 选取当前节点的所有后代元素(子、孙等) |

| descendant-or-self | 选取当前节点的所有后代运算(子、孙等)以及当前节点本身 |

| following | 选取文档中当前节点的结束标签之后的所有结点 |

| namespace | 选取当前节点的所有命名空间节点 |

| parent | 选取当前节点的父节点 |

| preceding | 直到所有这个节点的父辈节点,顺序选择这个父辈节点前的所有同级节点 |

| preceding-sibling | 选取当前节点之前的所有同级节点 |

| self | 选取当前节点。等驾驭self::node() |

步Step

步的语法 轴名称:节点测试[谓语]

| 例子 | 结果 |

|---|---|

| child::book | 选取所有属于当前节点的只元素的book节点 |

| attribute::lang | 选取当前节点的lang属性 |

| child::* | 选取当前节点的所有只元素 |

| attribute::* | 选取当前节点的所有属性 |

| child::text() | 选取当前节点的所有文本子节点 |

| child::node() | 选取当前节点的所有子节点 |

| descendant::book | 选取当前节点的所有book后代 |

| ancestor:book | 选择当前节点的所有book先辈 |

| ancestor-or-self::book | 选取当前节点的所有book先辈以及当前节点(如果此节点是book节点) |

| child::*/child::price | 选取当前节点的所有price孙节点 |

XPATH示例

- 以斜杠开始的称为绝对路径,表示从根开始。

- 不以斜杠开始的称为相对路径,一般都是依照当前节点来计算。当前节点在上下文环境中,当前节点很可能已经补是根节点了。

- 一般为了方便,往往xml如果层次很深,都会使用=//=来查找节点。

| 路径表达式 | 含义 |

|---|---|

| title | 选取当前节点下所有title子节点 |

| /book | 从根节点找子节点是book的,找不到 |

| book/title | 当前节点下所有子节点book下的title节点 |

| //title | 从根节点向下找任意层中title的结点 |

| book//title | 当前节点下所有book子节点下任意层次的title节点 |

| //@id | 任意层次下含有id的 属性 ,取回的是属性 |

| //book[@id] | 任意层次下含有id属性的book节点 |

| //*[@id] | 任意层下含有id属性的节点 |

| //book[@id="bk102"] | 任意层次下book节点,且含有id属性为bk102的节点。 |

| /bookstore/book[1] | 根节点bookstore下第一个book节点, 从1开始 |

| /bookstore/book[1]/@id | 根节点bookstore下的第一个book节点的id属性 |

| /bookstore/book[last()-1] | 根节点bookstore下*倒数*第二个book节点,函数last()返回最后一个元素索引 |

| /bookstore/* | 匹配根节点bookstore的所有子节点,不递归 |

| //* | 匹配所有子孙节点 |

| //*[@*] | 匹配所有有属性的节点 |

| //book[@*] | 匹配所有有属性的book节点 |

| //@* | 匹配所有属性 |

| //book/title | //price | 匹配任意层下的book下节点是title节点,或者任意层下的price |

| //book[position()=2] | 匹配book节点,取第二个 |

| //book[position()<last()-1] | 匹配book节点,取位置小于倒数第二个 |

| //book[price>40] | 匹配book节点,取节点值大于40的book节点 |

| //book[2]/node() | 匹配位置为2的book节点下的所有类型的节点 |

| //book[1]/text() | 匹配第一个book节点下的所有文本子节点 |

| //book[1]//text() | 匹配第一个book节点下的所有文本节点 |

| //*[local-name()="book"] | 匹配所有节点且不带限定名的节点名称为book的所有节点。local-name函数取不带限定名的名称。 |

| 路径表达式 | 含义 |

|---|---|

| //book/child::node() | 所有有class属性的节点 |

| //book/child::node()[local-name()='price' and text() < 10] | 所有book节点的子节点中名字叫做pricer 的 |

| 且其内容小于10的节点 | |

| 等价于//book/price[text(),10] | |

| //book[price<6]/price | |

| //book/price[text()<6] | |

| //book/child::node()[local-name()="price" and text()<6] | |

| 这三种等价 | |

| /book//*[self::title or self::price] | 所有book节点下子孙节点,且这些节点是title或者price |

| 等价于 //book//title | //book/price | |

| 也等价于=//book//*[local-name()="title" or local-name()="price"] | |

| //*[@class] | 所有有class属性的节点 |

| //*[@class="bookinfo even"] | 所有属性为“bookinfo even”的节点 |

| //*[contains(@class,'even') | 获取所有属性class中包含even字符串的节点 |

| //*[contains(local-name(),'book') | 标签名包含book的节点 |

轴少用。

函数总结

| 函数 | 含义 |

|---|---|

| local-name() | 获取不带限定名的名称。相当于指定*标签元素* |

| text() | 获取标签之间的文本内容 |

| node() | 所有节点。 |

| contains(@class,str) | 包含 |

| starts-with(local-name(),"book") | 以book开头 |

| last() | 最后一个元素索引 |

| position() | 元素索引 |

lxml

lxml是Python下功能丰富的XML、HTML解析库,性能非常好,是对libxml2和libxslt的封装。

注意,不同平台不一样,参看https://lxml.de/installation.html

lxml安装

pip install lxml

from lxml import etree # 使用etree构建HTML root = etree.Element("html") print(type(root)) print(root.tag) body = etree.Element("body") root.append(body) print(etree.tostring(root)) #增加子节点 sub = etree.SubElement(body,"child1") print(type(sub)) sub = etree.SubElement(body,"child2").append(etree.Element("child21")) html = etree.tostring(root,pretty_print=True).decode() print(html) print("- "*30) r = etree.HTML(html) #返回根节点 print(r.tag) print(r.xpath("//*[contains(local-name(),'child')]"))

- etree还提供了2个有用的函数

- etree.HTML(text)解析HTML文档,返回根节点

- anode.xpath('xpath路径')对节点使用xpath语法

范例

from lxml import etree # root = etree.Element('html') # body = etree.Element('body') # root.append(body) # print(root) # print(body) # body.append(etree.Element('div')) # p = etree.SubElement(body, 'p') # body里加个p标签 # print(etree.tostring(root, pretty_print=True)) # # b'<html>\n <body>\n <div/>\n <p/>\n </body>\n</html>\n' root = etree.HTML(b'<html>\n <body>\n <div/>\n <p>test string<p/>\n </body>\n</html>\n') print(etree.tostring(root)) print(root.xpath('//p/text()')) # 返回值 # b'<html>\n <body>\n <div/>\n <p>test string</p><p/>\n </body>\n</html>' # ['test string']

练习:爬取“口碑榜”

从豆瓣电影中获取”本周口碑榜”

- Chrome浏览器F12,选择 Elements (元素) 面板,按Ctrl+F,按xpath语法搜索

- 火狐浏览F12,按xpath语法搜索 //div[@class="billboard-bd"]//td/a/text()

<div class="billboard-bd"> <table> <tbody><tr> <td class="order">1</td> <td class="title"><a onclick="moreurl(this, {from:'mv_rk'})" href="https://movie.douban.com/subject/36809864/">南京照相馆</a></td> </tr> <tr> <td class="order">2</td> <td class="title"><a onclick="moreurl(this, {from:'mv_rk'})" href="https://movie.douban.com/subject/36448279/">罗小黑战记2</a></td> </tr>

from lxml import etree import requests url = 'https://movie.douban.com/' ua = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/138.0.0.0 Safari/537.36' response = requests.get(url, headers={'user-agent': ua}) with response: print(response.status_code) if 200 <= response.status_code < 300: print(response.text[:300]) # html内容 root = etree.HTML(response.content) # 分析html,返回DOM根节点 print(root.xpath('//div[@class="billboard-bd"]//td/a/text()'))

执行结果

200 <!DOCTYPE html> <html lang="zh-CN" class="ua-windows ua-webkit"> <head> <meta http-equiv="Content-Type" content="text/html; charset=utf-8"> <meta name="renderer" content="webkit"> <meta name="referrer" content="always"> <meta name="google-site-verification" content="ok0wCgT20tBBgo9_z ['南京照相馆', '罗小黑战记2', '戏台', '关于约会的一切', '冥婚红包', '长安的荔枝', '花漾少女杀人事件', '没事,没事,没事!', '麦克白', '邓南遮占领阜姆自由邦']

MongoDB在python中的使用

它是由C++编写的分布式文档数据库,内部使用类似于Json的bson格式。

安装

官方安装文档:https://www.mongodb.com/zh-cn/docs/manual/installation/

- MongoDB Community Server Download

- MongoDB Shell Download

# https://www.mongodb.com/zh-cn/docs/manual/tutorial/install-mongodb-on-windows-zip/ # Server D:. │ LICENSE-Community.txt │ MPL-2 │ README │ THIRD-PARTY-NOTICES │ └─bin Install-Compass.ps1 mongod.exe #Server mongod.pdb mongos.exe #Router mongos.pdb vc_redist.x64.exe # client D:. │ .sbom.json │ LICENSE-crypt-library │ LICENSE-mongosh │ mongosh.1.gz │ README │ THIRD_PARTY_NOTICES │ └─bin mongosh.exe mongosh_crypt_v1.dll

| 组件 | 文件名 |

|---|---|

| Server | mongod.exe |

| Router | mongos.exe |

| Client | mongosh 旧版为mongo.exe |

| MonitoringTools | mongostat.exe,mongotop.exe |

| importExportTools | mongodump.exe,mongorestore.exe,mongoexport.exe,mongoimport.exe |

| MiscellaneousTools | bsondump.exe,mongofiles.exe,mongooplog.exe,mongoperf.exe |

运行

./bin/mongod #没有指定数据目录,报错。 # ./bin/mongod --dbpath="d:/tmp/mongo/db"

选项说明

--bind_ip ip #逗号分隔ip地址。默认localhost --bing_ip_all #绑定所有本地ip地址 --port port #端口,默认27017 --dbpath path #数据路径,缺省为=\data\db\=。windows下缺省就是当前盘符的根目录 --logpath path #指定日志文件,替代stdout,说明默认是控制台打印日志 -f file #指定配置文件,yaml格式 注册wiendows服务 --install #注册windwos服务 --serviceName name #服务名称 --serviceDisplayName name #服务显示名

linux安装mongodb

#debian wget https://repo.mongodb.org/apt/debian/dists/bookworm/mongodb-org/8.0/main/binary-amd64/mongodb-org-server_8.0.13_amd64.deb └─$ dpkg -c ./mongodb-org-server_8.0.13_amd64.deb #查看包文件 -rw-r--r-- root/root 578 2013-12-19 13:41 ./etc/mongod.conf # 配置文件 -rw-r--r-- root/root 837 2013-12-19 13:41 ./lib/systemd/system/mongod.service # uint启动文件 -rwxr-xr-x root/root 219688608 2013-12-19 13:41 ./usr/bin/mongod vim /etc/mongod.conf net: port: 27017 bindIp: 0.0.0.0 # 启动服务 systemctl start mongod.service

配置文件

mongodb配置使用YAML格式

- 嵌套使用缩进晚餐,不支持Tab等制表符,支持空格

- 冒号后要有空格

Yaml参考https://www.w3cschool.cn/iqmrhf/dotvpozt.html

配置: https://www.mongodb.com/zh-cn/docs/manual/reference/configuration-options/ 在mongodb安装目录新建配置文件mongodb.yml。内容如下:

mongod.yml

systemLog: destination: file path: "d:/tmp/mongo/mongod.log" logAppend: true storage: dbPath: "d:/tmp/mongo/db" net: bindIp: 127.0.0.1 port: 27017

选项

- systemLog

- destination,缺省是输出日志到std,file表示输出到文件

- path,日志路径

- logAppend,true表示在已存在的日志文件追加。默认false,每次启动服务,重新创建新的日志。

- storage

- dbPath,必须指定mongodb的数据目录,目录必须存在。

- net

- bindlp,缺省绑定到127.0.0.1

- port,端口,缺省为27017,客户端连接用

windows下注册为服务的命令如下,使用了配置文件:

mongod.exe -f "D:/Application/mogodb/package/mongodb4.0/mongod.yml" --serviceName mongod --serviceDisplayName mongo --install

注意,注册服务需要管理员权限。

去掉配置文件中的配置日志信息部分。这样日志将会显示在控制台

storage:

dbPath: "d:/tmp/mongo/db"

net:

bindIp: 127.0.0.1

port: 27017

启动服务

./bin/mongod -f mongod.yml

客户端

客户端连接

客户端连接文档:

- mongosh: https://www.mongodb.com/zh-cn/docs/mongodb-shell/connect/

- compass GUI: https://www.mongodb.com/try/download/compass

./bin/mongosh "mongodb://localhost:27017" #旧版本 bin/mongo.exe #操作 help 打开帮助 show dbs 查看当前库 use blog 有就切换过去,没有就创建后切换过去。刚创建的并不在数据库列表中,需要写入数据后才能看到 db 查看当前数据库 db.users.insert({user:"tom",age:20}) db指代当前数据库;users集合名

范例

test> help Shell Help: log 'log.info(<msg>)': Write a custom info/warn/error/fatal/debug message to the log file 'log.getPath()': Gets a path to the current log file use Set current database show 'show databases'/'show dbs': Print a list of all available databases 'show collections'/'show tables': Print a list of all collections for current database 'show profile': Prints system.profile information 'show users': Print a list of all users for current database 'show roles': Print a list of all roles for current database 'show log <name>': Display log for current connection, if name is not set uses 'global' 'show logs': Print all logger names. exit Quit the MongoDB shell with exit/exit()/.exit quit Quit the MongoDB shell with quit/quit() Mongo Create a new connection and return the Mongo object. Usage: new Mongo(URI, options [optional]) connect Create a new connection and return the Database object. Usage: connect(URI, username [optional], password [optional]) it result of the last line evaluated; use to further iterate version Shell version load Loads and runs a JavaScript file into the current shell environment enableTelemetry Enables collection of anonymous usage data to improve the mongosh CLI disableTelemetry Disables collection of anonymous usage data to improve the mongosh CLI passwordPrompt Prompts the user for a password sleep Sleep for the specified number of milliseconds print Prints the contents of an object to the output printjson Alias for print() convertShardKeyToHashed Returns the hashed value for the input using the same hashing function as a hashed index. cls Clears the screen like console.clear() isInteractive Returns whether the shell will enter or has entered interactive mode For more information on usage: https://mongodb.com/docs/manual/reference/method test> show dbs admin 40.00 KiB config 108.00 KiB local 40.00 KiB test> db test test> use aaa # 没有写数据的话,退出后不会创建库。 switched to db aaa aaa> aaa> use users switched to db users users> db.users.insert({'name':'tom', 'age':20}) #插入数据 DeprecationWarning: Collection.insert() is deprecated. Use insertOne, insertMany, or bulkWrite. { acknowledged: true, insertedIds: { '0': ObjectId('6895bc37ad8daf59bceec4a9') } } users> db.users.find() [ { _id: ObjectId('6895bc37ad8daf59bceec4a9'), name: 'tom', age: 20 } ] users>

Pycharm插件 在settings/plugins中输入mongo,安装Mongo Plugin,完成后重启Pycharm。

菜单项view/Tool windows/Mongo Explorer

Python链接

Mongodb官方推荐使用pymongo。参考https://www.mongodb.com/zh-cn/docs/languages/python/pymongo-driver/current/

#pymongo-4.14.0 pip install pymongo

mongodb的链接字符串 mongodb://gdy:[email protected]:27017/test

from pymongo import MongoClient from pymongo.synchronous.database import Database url = 'mongodb://127.0.0.1:27017' client = MongoClient(url) print(client) db:Database = client['users'] # db = client.users # 与上面等价,因为MongoClient有__getitem__ __getattr__ 方法 print(type(db), db) table = db['users'] print(type(table), table) result = table.find() # select * from users.users print(type(result), *result) client.close() # with client:

执行结果

MongoClient(host=['127.0.0.1:27017'], document_class=dict, tz_aware=False, connect=True) <class 'pymongo.synchronous.database.Database'> Database(MongoClient(host=['127.0.0.1:27017'], document_class=dict, tz_aware=False, connect=True), 'users') <class 'pymongo.synchronous.collection.Collection'> Collection(Database(MongoClient(host=['127.0.0.1:27017'], document_class=dict, tz_aware=False, connect=True), 'users'), 'users') <class 'pymongo.synchronous.cursor.Cursor'> {'_id': ObjectId('6895bc37ad8daf59bceec4a9'), 'name': 'tom', 'age': 20}

即能用属性访问,又能像key一样访问,一定用到了魔术方法的 __getattr__、__getitem__

基本概念

MongoDB中可以创建使用多个库,但有一些数据库名是保留的,可以直接访问这些特殊作用的数据库。

- admin: 从权限的角度来看,这是"root"数据库。要是将一个用户添加到这个数据库,这个用户自动继承所有数据库的权限。一些特定的服务器端命令也只能从这个数据库运行,比如列出所有的数据库或者关闭服务器。

- local: 这个数据永远不会被赋值,可以用来存储限于本地单台服务器的任意集合

- config: 当Mongo用于分片设置时,config数据库在内部使用,用于保存分片的相关信息。

| RDBMS | MongoDB |

|---|---|

| Database | Database |

| Table | Collection |

| Row | Document |

| Column | Field |

| Join | Embedded Document嵌入文档或Reference引用 |

| Primary Key | 主键(MongoDB提供了Key为_id) |

插入数据

每条数据插入后都有一个唯一key,属性 _id 唯一标识一个文档。没有没有显示指明该属性,会自动生成一个Objectld类型的 _id 属性。

pymongo.collection.Collection类

- db.collection.insert_one(dict)->InsertOneResult #单行插入

- dict是一个字典

- InsertOneResult:f返回结果ObjectId对象,即=_id=的值

- db.collection.insert_many([dict,…])->[InsertOneResult,…]

#多行插入

- 第一个参数是个列表,列表中记录需要插入的文档类型即dict

- 返回结果,被插入的对象所获得的id

from pymongo import MongoClient from pymongo.synchronous.database import Database url = 'mongodb://127.0.0.1:27017' client = MongoClient(url) db:Database = client['users'] table = db['users'] # C # 单条插入 r = table.insert_one({'id':'1','name':'ben', 'age':20}) # _id print(r.inserted_id) #68961acd2a6de1bd5c0fd597 # 批量插入 r = table.insert_many([ {'id':257, 'name':'tom', 'age':32}, {'id':258, 'name':'jerry', 'age':48} ]) print(r.inserted_ids) #[ObjectId('68961ace2a6de1bd5c0fd598'), ObjectId('68961ace2a6de1bd5c0fd599')] r = table.insert_one({'id':'3','name':'sam', 'age':16}) # _id print(r.inserted_id) # 68961ace2a6de1bd5c0fd59a result = table.find() # select * from users.users print(type(result), *result) client.close()

每条数据插入后都有一个唯一key,属性 _id 唯一标识一个文档。没有显式指明该属性,会自动生成一个ObjectId类型的 _id 属性。

ObjectID由12个字节组成

- 4个字节时间戳

- 3个字节机器识别码

- 2个字节进程id

- 3个字节随机数

import datetime id = '68961ace2a6de1bd5c0fd59a' x = id[:8] # 时间戳提取 print(x) print(0x68961ace) print(int('0x68961ace', 16)) print(datetime.datetime.fromtimestamp(0x68961ace)) print('=' * 30) y = int.from_bytes(bytes.fromhex(x), 'big') #大端模式 print(y) print(datetime.datetime.fromtimestamp(y)) # 也可以使用函数获取 import bson #json z = bson.ObjectId(id) print(z) print(z.generation_time)

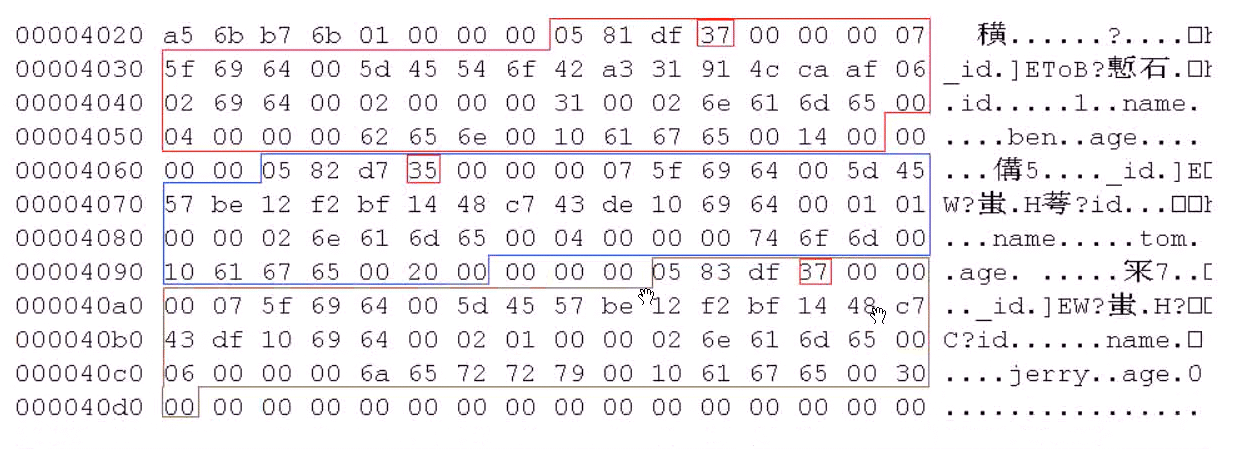

文档

每一条记录对应一个文档,其格式使用BSON。BSON即Binary Json。

BSON二进制格式如下:

查看"\db\collection-4-*.wt"对应的二进制格式

00 00 05 82 d7 35 00 00 00 07 5f 69 64 00 5d 45 35 表示文档二精制数据长度 07 表示MongoDB中特殊数据类型ObjectID 5f 69 64 ,ascii码_id 57 be 12 f2 bf 14 48 c7 43 de 10 69 64 00 01 01 5d 45 57 be 12 f2 bf 14 48 c7 43 de,ObjectId(‘5d4557be12f2bf1448c743de')_id的值 10 69 64,10表示类型int-32, 69 64是ascii码id 0101小端模式,十进制257

mongodb数据类型参考 https://docs.mongodb.com/v3.6/reference/bson-types/

00 00 02 6e 61 6d 65 00 04 00 00 00 74 6f 6d 00

- 02 表示数据类型UTF-8 String

- 6e 61 6d 65 表示字符串name

- 04, 表示字符串长度

- 74 6f 6d 00,表示字符串tom和结束符

10 61 67 65 00 20 00

- 10,表示数据类型int-32

- 61 67 65,表示字符串age

- 20,表示十进制32

文档

- 文档中,使用键值对

- 文档中的键/值对时*有序*的

- 键是字符串

- 区分大小写 ,使用UTF-8字符

- 键不能含有\0(空字符)。这个字符用来表示键字符串的结尾

.和$有特别的意义,只有在特定环境下才能使用- 以下划线

_开头的键是保留的,例如:_id

- 值可以是:

- 字符串,32位或64位整数、双精度、时间戳(毫秒)、布尔型、null

- 字节数组、BSON数组、BSON对象

查询数据

pymongo.collection.Collection类

db.collection.find_one(dict)->result 查询单条数据 db.collection.find(dict)->resutl 查询多条数据

- dict,使用查询操作符组成的字典

- result,返回的结果集

单条查询

find_on第一参数是filter, 相当于SQL的where子句。

from pymongo import MongoClient from pymongo.collection import Collection from bson.objectid import ObjectId client = MongoClient("mongodb://127.0.0.1:27017") db = client["blog"] #指定数据库 users:Collection = db.users #集合 # 查询 result = users.find_one({"name":"tom"}) print(type(result),result) # 使用key查询 result2 = users.find_one({"_id":ObjectId("5d539433c1b3dcb23654814d")}) print(type(result2),result2) #查不到,返回None result3 = users.find_one({"name":"tommy"}) print(type(result3),result3)1.2.3.4.5.6.7.8.9.10.11.12.13.14.15.16.17.18.19.

多条查询

from pymongo import MongoClient from pymongo.collection import Collection client = MongoClient("mongodb://127.0.0.1:27017") db = client["blog"] #指定数据库 users:Collection = db.users #集合 # 多条查询 results = users.find({"name":"tom"}) print(type(results)) print(results) print("- "*30) for x in results: print(type(x),x)

查询操作符

https://www.mongodb.com/zh-cn/docs/manual/reference/operator/query/

| 比较符号 | 含义 | 示例 |

|---|---|---|

| $lt | 小于 | {"age":{"$lt":20}} |

| $gt | 大于 | {"age":{"$gt":20}} |

| $lte | 小于等于 | {"age":{"$lte":20}} |

| $gte | 大于等于 | {"age":{"$gte":20}} |

| $ne | 不等于 | {"age":{"$ne":20}} |

| $eq | 等于,可以不用增符号 | {"age":{"$eq":20}} |

| $in | 在范围内 | {"age":{"$in":[20,23]}} |

| $nin | 不在范围内 | {"age":{"$nin":[20,30]]}} |

| 逻辑符号 | 含义 | 示例 |

|---|---|---|

| $and | 与 | {"$and":[{"name":"tom"},{"age":{"$gt":20}}]} |

| $or | 或 | {'$or':[ {'age':{'$lt':20}}, {'age':{'$gt':40}}]} |

| $not | 非 | {'name':{'$not':{'$eq':'tom'}}} |

| 元素 | 含义 | 示例 |

|---|---|---|

| $exists | 文档中是否有这个字段 | {'Name':{'$exists':True}} |

| $type | 字段是否是指定的类型 | {'age':{'$type':16}} |

常用类型

- 字符串类型编码为2,别名为string

- 整型编码为16,别名为int

- 长整型编码为18,别名为long

https://docs.mongodb.com/manual/reference/operator/query/type/#op._S_type

| 操作符 | 含义 | 示例 |

|---|---|---|

| $regex | 文档中字段内容匹配 | {"name":{"$regex":"^t"}} |

| $mod | 取模 | {"age":{"$mod":[10,2]}}模10余2 |

范例

from pymongo import MongoClient from pymongo.synchronous.database import Database url = 'mongodb://127.0.0.1:27017' client = MongoClient(url) db:Database = client['users'] table = db['users'] # db.users # 操作符 # result = table.find({'age':{"$gt":20}}) # select * from users.users where name='tom' and age > 20 # result = table.find({'age':{'$nin':[20, 16]}}) # result = table.find({'$and':[ # {'name':'tom'}, {'age':{'$gt':20}} # ]}) # result = table.find({'name':'tom', 'age':{'$gt':20}}) #与上面等价 # result = table.find({'$or':[ # {'age':{'$lt':20}}, {'age':{'$gt':40}} # ]}) # result = table.find({'name':{'$not':{'$eq':'tom'}}}) # result = table.find({'id':{'$type':16}}) # result = table.find({'Name':{'$exists':True}}) # result = table.find({'name':{'$regex':'^t'}}) result = table.find({'age':{'$mod':[10, 2]}}) print(*result, sep='\n') client.close()

投影

from pymongo import MongoClient from pymongo.synchronous.database import Database url = 'mongodb://127.0.0.1:27017' client = MongoClient(url) db:Database = client['users'] table = db['users'] # db.users # 投影 # result = table.find({'age':{'$gt':20}}, ('name',)) # result = table.find({'age':{'$gt':20}}, ['name', 'id']) #允许 result = table.find({'age':{'$gt':20}}, {'name':0, 'age':False}) #排除。 0为排除,非0为允许。但不能混写。 for x in result: print(type(x), x) client.close()

可以使用列表、元组、字典描述字段,或排除投影的字段。

统计

- db.collection.find(条件字典).count() 统计次数(已过时)

- db.collection.count_documents(条件字典)

from pymongo import MongoClient from pymongo.collection import Collection client = MongoClient("mongodb://127.0.0.1:27017") db = client["blog"] #指定数据库 users:Collection = db.users #集合 # 统计 # 被弃用 # count = users.find({"age":{"$gt":10}}).count() #求出age>10的数量 count = users.count_documents({"age":{"$gt":10}}) print(count) #返回结果41.2.3.4.5.6.7.8.9.10.11.12.13.14.

result = table.find({'age':{'$gt':20}}).distinct('name') #去 重

聚合

https://www.mongodb.com/zh-cn/docs/manual/aggregation/

from pymongo import MongoClient from pymongo.synchronous.database import Database url = 'mongodb://127.0.0.1:27017' client = MongoClient(url) db:Database = client['users'] table = db['users'] # db.users # 聚合 result = table.aggregate([ {'$match':{'age':{'$gte':20}}}, #过滤 { '$count':'age'} ]) print(*result) result = table.count_documents({'age':{'$gte':20}}) print(result) client.close()

from pymongo import MongoClient from pymongo.synchronous.database import Database url = 'mongodb://127.0.0.1:27017' client = MongoClient(url) db:Database = client['users'] table = db['users'] # db.users # 聚合 result = table.aggregate([ {'$match':{'age':{'$gte':5}}}, {'$group':{'_id':'$name', 'res':{'$sum':'$age'}}} # 注意前面加$。 按name分组,res为age合 ]) print(*result) client.close()

排序

- db.collection.find().sort(字段名,排序规则)

- db.collection.find().sort(list)

from pymongo import MongoClient, ASCENDING, DESCENDING from pymongo.synchronous.database import Database url = 'mongodb://127.0.0.1:27017' client = MongoClient(url) db:Database = client['users'] table = db['users'] # db.users # 排序 result = table.find().sort('age', DESCENDING) print(*list(result), sep='\n') print('=' * 30) result2 = table.find().sort([ ('name', DESCENDING), # name降序 ('age', ASCENDING) # age升序 ]) print(*result2, sep='\n') client.close()

分页

- db.collection.find().skip(n).limit(m) #分页,查询结果中跳过前n个,最多显示m个

- skip(n):从查询结果中跳过前面指定n个

- limit(m):从查询结果中最多只显示m个

- skip跳过几个,limit限制结果个数

from pymongo import MongoClient from pymongo.collection import Collection client = MongoClient("mongodb://127.0.0.1:27017") db = client["blog"] #指定数据库 users:Collection = db.users #集合 # 分页 results = users.find() print(*list(results),sep="\n") print("- "*30) results1 = users.find().skip(2) #跳过前2个 print(*list(results1),sep="\n") print("- "*30) results2 = users.find().skip(1).limit(2) #跳过前1个最多显示2个 print(*list(results2),sep="\n") print("- "*30)

更新

| 更新操作符 | 含义 | 示例 |

|---|---|---|

| $inc | 对给定字段数字值增减 | {"$inc":{"age":-5}}对age的值-5 |

| $set | 设置字段值,如果字段不存在则创建 | {"$set":{"gender":"M"}} |

| $unset | 移除字段 | {"$unset":{"Name":""}} |

- db.collection.updateOne(查询条件dict,更新dict)方法只更新查询结果集中的第一个

- db.collection.update_many(查询条件dict,更新dict)方法多行更新

- db.collection.replace_one(查询条件,新文档dict) 更新一个文档,会将匹配到的第一个结果中的文档替换为新文档。

- 替换文档,更新除

_id外的所有字段

update_one更新第一个示例

from pymongo import MongoClient from pymongo.synchronous.database import Database url = 'mongodb://127.0.0.1:27017' client = MongoClient(url) db:Database = client['users'] table = db['users'] # db.users # U print(*table.find(), sep='\n') print('-' * 30) # 更新,将name为tom的结果中第一行文档中age减5 r = table.update_one({'name':'tom'}, {'$inc':{'age': -5}}) print(type(r), r.upserted_id, r.modified_count, r.matched_count) print(*table.find(), sep='\n') client.close()

update_many更新多行

from pymongo import MongoClient from pymongo.collection import Collection client = MongoClient("mongodb://127.0.0.1:27017") db = client["blog"] #指定数据库 users:Collection = db.users #集合 print(*list(users.find()),sep="\n") print("- "*30) # 更新,将name为tom的字段都添加一个gender等于m的属性 result = users.update_many({"name":"tom"},{"$set":{"gender":"M"}}) print(type(result),result) print(result.matched_count,result.modified_count) print("- "*30) print(*list(users.find()),sep="\n") print("- "*30) # 更新,将有name为tom的文档中包含Name属性的删除 result = users.update_many({"name":"tom"},{"$unset":{"Name":""}}) print(type(result),result) print(result.matched_count,result.modified_count) print("- "*30) print(*list(users.find()),sep="\n")

replace_one替换一个文档

- 更新除

_id字段外的所有字段

from pymongo import MongoClient from pymongo.collection import Collection client = MongoClient("mongodb://127.0.0.1:27017") db = client["blog"] #指定数据库 users:Collection = db.users #集合 print(*list(users.find()),sep="\n") print("- "*30) # 替换文档 result = users.replace_one({"name":"tom"},{"id":200,"name":"sam"}) #完全替换 print(type(result),result) print("- "*30) print(*list(users.find()),sep="\n")

全文索引

https://www.mongodb.com/zh-cn/docs/manual/text-search/

https://www.mongodb.com/zh-cn/docs/manual/core/indexes/create-index/

from pymongo import MongoClient, ASCENDING, DESCENDING from pymongo.synchronous.database import Database url = 'mongodb://127.0.0.1:27017' client = MongoClient(url) db:Database = client['users'] table = db['users'] # db.users # 创建全文索引 r = table.create_index([('name', 'text'), ('age', DESCENDING)]) print(type(r), r) print(*table.find(), sep='\n') client.close()

from pymongo import MongoClient, ASCENDING, DESCENDING from pymongo.synchronous.database import Database url = 'mongodb://127.0.0.1:27017' client = MongoClient(url) db:Database = client['users'] table = db['users'] # db.users # # 创建全文索引 # r = table.create_index([('name', 'text'), ('age', DESCENDING)]) # print(type(r), r) # 全文搜索 r = table.find({'$text':{'$search': 'tom china'}}) # 搜索包含 tom或china的文档 print(*r, sep='\n') client.close()

删除

- db.collection.remove(条件dict) #删除,已过时的方法

- db.collection.delete_one(条件dict) #将满足条件的结果删除第一行

- db.collection.delete_many(条件dict)#将满足条件的结果全部删除

- db.collection.delete_many({})删除所有文档,慎用

from pymongo import MongoClient from pymongo.collection import Collection from pymongo.results import DeleteResult client = MongoClient("mongodb://127.0.0.1:27017") db = client["blog"] #指定数据库 users:Collection = db.users #集合 print(*list(users.find()),sep="\n") print("- "*30) # 删除age为20的文档,只删除一条 result:DeleteResult = users.delete_one({"age":20}) print(type(result),result.deleted_count) print("- "*30) print(*list(users.find()),sep="\n") # 删除所有存在age字段的文档 result2:DeleteResult = users.delete_many({"age":{"$exists":True}}) print(type(result2),result2.deleted_count) print("- "*30) print(*list(users.find()),sep="\n")

HTML解析-BeautifulSoup4

BeautifulSoup4

BeautifulSoup可以从HTML、XML中提取数据,目前BS4在持续开发。

https://www.crummy.com/software/BeautifulSoup/

官方中文文档https://www.crummy.com/software/BeautifulSoup/bs4/doc.zh/

安装

pip install bs4 #pip install beautifulsoup4 pip install lxml

初始化

BeautifulSoup(markup=““,features=None)

- markup,被解析对象,可以是文件对象或者html字符串

- feature指定解析器

- return:返回一个文档对象

from bs4 import BeautifulSoup #文件对象 soup = BeautifulSoup(open("test.html")) # 标记字符串 soup = BeautifulSoup("<html>data</html>")

可以不指定解析器,就依赖系统已经安装的解析器库了。

| 解析器 | 使用方法 | 优势 | 劣势 |

|---|---|---|---|

| Python标准库 | BeautifulSoup(markup,"html.parser") | Python的内置标准库执行速度适中文档容错能力强 | Python 2.7.3、3.2.2前 的版本中文档容错能力差 |

| lxml HTML 解析器 | BeautifulSoup(markup,"lxml") | 速度快文档容错能力强 | 需要安装C语言库 |

| lxml XML 解析器 | BeautifulSoup(markup,["lxml","xml"])BeautifulSoup(markup,"xml") | 速度快唯一支持XML的解析器 | 需要安装C语言库 |

| html5lib | BeautifulSoup(markup,"html5lib") | 最好的容错性以浏览器的方式解析文档生成HTML5格式的文档 | 速度慢不依赖外部扩展 |

- BeautifulSoup(markup,"html.parser")使用Python标准库,容错差且性能一般。

- BeautifulSoup(markup,"lxml")容错能力强,速度快。需要安装系统C库。

- 推荐使用lxml作为解析器,效率高。

- 需要手动指定解析器,以保证代码在所有运行环境中解析器一致。

- 使用下面内容构建test.html使用bs4解析它

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8"> <title>首页</title> </head> <body> <h1>TEST</h1> <div id="main"> <h3 class="title highlight"><a href="http://www.python.org">python</a>高级班</h3> <div class="content"> <p id="first">字典</p> <p id="second">列表</p> <input type="hidden" name="_csrf" value="absdoia23lkso234r23oslfn"> <!-- comment --> <img id="bg1" src="http://www.cici.com/"> <img id="bg2" src="http://httpbin.org/"> </div> </div> <p>bottom</p> </body>

from bs4 import BeautifulSoup with open('test.html', encoding='utf-8') as f: doc = BeautifulSoup(f, 'lxml') print(doc.prettify())

将html对象转化为DOM树,剩下是如何定位数据了。

四种对象

BeautifulSoup将HTML文档解析成复杂的树型结构,每个节点都是Python的对象,可分为4种:

- BeautifulSoup、Tag、NavigableString、Comment

BeautifulSoup对象

代表整个文档。

Tag对象

对应着HTML中的标签。有2个常用的属性:

- name:Tag对象的名称,就是标签名称

- attrs:标签的属性字典

- 多值属性,对于class属性可能是下面的形式,

<h3 class="title highlight">python高级班</h3>这个属性就是多值({"class":["title","highlight"]}) - 属性可以被修改、删除

- 多值属性,对于class属性可能是下面的形式,

- BeautifulSoup.prettify() #带格式输出解析的文档对象(即有缩进的输出),注意:直接输出BeautifulSoup会直接输出解析的文档对象,没有格式。

- BeautifulSoup.div #输出匹配到的第一个div对象中的内容,返回对象是bs4.element.Tag类型

- BeautifulSoup.h3.get("class") #获取文档中第一个标签为h3对象中class属性值

from bs4 import BeautifulSoup with open("test.html",encoding="utf-8") as f: soup = BeautifulSoup(f,"lxml") print(soup.builder) print(0,soup) #输出整个解析的文档对象(不带格式) print(1,soup.prettify()) #按照格式输出文档内容 print("- "*30) div = soup.div print(2, div, type(div)) #类型bs4.element.Tag,Tag对象 print(3, div.name, div.attrs) # 属性获取 print(div.attrs['id'], div.attrs.get('id'), div.get('id'), div['id']) # 4种一样 #print(3, div['class']) #KeyError, div没有class属性 print(3, div.get('class')) #没有返回None h3 = soup.h3 print(4, h3.get('class'), h3["class"], h3.attrs['class'], h3.attrs.get('class')) #多值属性 ['title', 'highlight'] print(5,soup.img.get("src")) #获取img中src属性值 soup.img["src"] = "http://www.ciciupdate.com" #修改值 print(5,soup.img["src"]) print(6,soup.a) #找不到返回None del soup.h3["class"] #删除属性 print(4,soup.h3.get("class"))

注意:我们一般不使用声明这种方式来操作HTML,此代码时为了熟悉对象类型

范例

from bs4 import BeautifulSoup from bs4.element import Tag with open('test.html', encoding='utf-8') as f: doc = BeautifulSoup(f, 'lxml') # print(doc.prettify()) #按照格式输出文档内容 # print(type(doc)) # soup 对象 # Tag object <=> soup object x:Tag = doc.p # soup.find('p') __getattr__ 找p标签 print(type(x), x, x.name) # bs4.element.Tag <p id="first">字典</p> # y = doc.div.div # print(y) print(x.attrs, type(x.attrs)) print(x.attrs.get('id'), x.attrs['id']) print(x.get('id'), x['id']) # Tag __getitem__ print('-' * 30) y = doc.h3 print(type(y.attrs), y.attrs) # class 多值字典 print(y.attrs.get('class')) print(y.get('class'), y['class']) print('=' * 30) img = doc.div.img print(img.get('src')) img['src'] = 'https://baidu.com' # Tag __setitem__ print(img.get('src')) del img['src'] print(img.get('src', 'nothing'))

NavigableString

如果只想输出标记的文本,而不关心标记的话,就要使用NavigableString.

print(soup.div.p.string) #第一个div下第一个p的字符串 print(soup.p.string) #同上

范例

from bs4 import BeautifulSoup from bs4.element import Tag with open('test.html', encoding='utf-8') as f: doc = BeautifulSoup(f, 'lxml') print(doc.p.string) print(doc.div.string) # 仅有一个文本类型节点 print(doc.h3.a.string, type(doc.h3.a.string)) # python <class 'bs4.element.NavigableString'>

注释对象

这就是HTML中的注释,它被BeautifulSoup解析后对应Comment对象。

遍历文档树

在文档树中找到关心的内容才是日常的工资,也就是说如何遍历树中的节点。使用上面的test.html来测试

使用Tag

- soup.div可以找到从根节点开始查找第一个div节点,返回一个Tag对象

- soup.div.p说明从根节点开始找到第一个div后返回一个Tag对象,这个Tag对象下继续找第一个p,找到返回Tag对象

- soup.p返回了文字“字典”,而不是文字“bottom”说明遍历时 深度优先 ,返回也是Tag对象

遍历直接子节点

- Tag.contents #将对象的所有类型直接子节点以列表方式输出

- Tag.children #返回子节点的迭代器

- Tag.children #等价于Tag.contents

遍历所有子孙节点

- Tag.descendants #返回节点的所有类型子孙节点,可以看出迭代次序是深度优先

from bs4 import BeautifulSoup from bs4.element import Tag with open("test.html",encoding="utf-8") as f: soup = BeautifulSoup(f,"lxml") print(soup.p.string) print(soup.div.contents) #直接子标签列表 print("- "*30) for i in soup.div.children: #直接子标签可迭代对象 print(i.name) print("- "*30) print(list(map( lambda x:x.name if x.name else x, soup.div.descendants #所有子孙 )))

遍历字符串

在前面的例子中,soup.div.string返回None,是因为string要求soup.div只能有一个NavigableString类型子节点,也就是这样 <div>only string</div> 。

如果div有很多子孙节点,如何提取字符串?

from bs4 import BeautifulSoup from bs4.element import Tag with open("test.html",encoding="utf-8") as f: soup = BeautifulSoup(f,"lxml") print(soup.div.string) #返回None,因为多余1个子节点 print("".join(soup.div.strings) #返回迭代器,带多余的空白字符 print("".join(soup.div.stripped_strings)) #返回迭代器,去除多余空白字符

遍历祖先节点

- BeautifulSoup.parent #获取根节点的父结点,必定返回None,根节点没有父结点

- Tag.parent #获取第一个Tag的父结点

- Tag.parent.parent.get("id") #获取第一个tag的父结点的父结点的id属性

- Tag.parents #获取Tag节点的所有父结点,由近及远

from bs4 import BeautifulSoup from bs4.element import Tag with open("test.html",encoding="utf-8") as f: soup = BeautifulSoup(f,"lxml") print(type(soup)) print(soup.parent) #None 根节点没有父节点 print(soup.div.parent.name) #body ,第一个div的父节点 print(soup.p.parent.parent.get("id")) #取id属性, main print("- "*30) print(list(map(lambda x:x.name,soup.p.parents))) #父迭代器,由近及远

遍历兄弟节点

- Tag.next_sibling #第一个Tag元素的下一个(下面)兄弟节点,注意:可能是一个文本节点

- Tag.previous_sibling #第一个Tag元素之前的兄弟节点(上面),注意:可能是一个文本节点

- Tag.next_siblings #获取Tag元素的下面的所有兄弟节点

print('{} [{}]'.format(1, soup.p.next_sibling)) #第一个p元素的下一个兄弟节点,注意可能是一个文本节点 print('{} [{}]'.format(2, soup.previous_sibling)) print(list(soup.p.next_siblings)) #所有同级兄弟,包括文本。previous_siblings

遍历其他元素*

- Tag.next_element 是下一个可被解析的对象(字符串或tag),和下一个兄弟节点next_sibling不一样

- Tag.next_elements #返回所有下一个可被解析的对象,是个可迭代对象。

from bs4 import BeautifulSoup with open("test.html",encoding="utf-8") as f: soup = BeautifulSoup(f,"lxml") print(type(soup),type(soup.p)) print(soup.p.next_element) #返回"字典"2个字 print(soup.p.next_element.next_element.encode()) print(soup.p.next_element.next_element.next_element) print(list(soup.p.next_elements)) print("- "*30) #对比差异 print(list(soup.p.next_elements)) print(list(soup.p.next_siblings))

范例

from bs4 import BeautifulSoup from bs4.element import Tag with open('test.html', encoding='utf-8') as f: doc = BeautifulSoup(f, 'lxml') print(doc.div.contents) print('-' * 30) print(*doc.div.children, sep='||') print(doc.parent) print(doc.div.parent.name) print(doc.div.parent.attrs) print(*map(lambda x:x.name, doc.div.p.parents)) # 只有Tag类型 print('+' * 30) print(*doc.div.descendants, sep='|||') # 所有层次的子孙,也包括文本 print('============') # 下一个元素 print(doc.div.p.next_sibling) # 同辈的标签对象,包括文本 print(doc.div.p.next_sibling.next_sibling) print(doc.div.p.next_sibling.next_sibling.next_sibling) print(doc.div.p.next_sibling.next_sibling.next_sibling.next_sibling) print(*doc.div.p.next_siblings, sep="***") print('~' * 30) print(doc.div.p.next_element) # 字典 print(doc.div.p.next_element.next_element) # \n print(doc.div.p.next_element.next_element.next_element) # p print(doc.div.p.next_element.next_element.next_element.next_element) # 列表 print('=' * 30) print(*doc.div.p.next_elements, sep='&&&')

搜索文档树

find系有很多分发,请执行查询帮助

find_all(name=None,attrs={},recursive=True,string=None,limit=None,**kwargs) #立即返回一个列表

name参数

官方称为 fiter过滤器 ,这个参数可以是一下

1 字符串:一个标签名称的字符串,会按照这个字符串全长匹配标签名

print(soup.find_all('p'))#返回文档中所有p标签

2 正则表达式对象:按照”正则表达式对象”的模式匹配标签名

import re print(soup.find_all(re.compile("^h\d"))) #标签名以h开头后接数字

3 列表:或关系查找列表中的每个字符串

print(soup.find_all(["p","h1","h3"])) #或关系,找出列表所有的标签 print(soup.find_all(re.compile(r"^p|h|\d$"))) #使用正则表达式完成

4 True或None,则find_all返回全部非字符串节点、非注释节点,就是Tag标签类型

from bs4 import BeautifulSoup with open("test.html",encoding="utf-8") as f: soup = BeautifulSoup(f,"lxml") print(list(map(lambda x: x.name, soup.find_all(True)))) print(list(map(lambda x: x.name, soup.find_all(None)))) print(list(map(lambda x: x.name, soup.find_all())))

源码中确实上面三种情况都返回的Tag类型

5 函数

- 如果使用以上过滤器还不能提取想要的节点,可以使用函数,此函数仅只能*接收一个参数*。

- 如果这个函数返回True,表示当前节点配置;返回False则是不匹配。

- 示例:找出所有class属性且有多个值的节点(测试html中符合这个条件只有h3标签)

from bs4 import BeautifulSoup from bs4.element import Tag def many_classes(tag:Tag): # print(type(tag)) # print(type(tag.attrs)) return len(tag.attrs.get("class",[])) > 1 with open("test.html",encoding="utf-8") as f: soup = BeautifulSoup(f,"lxml") print(soup.find_all(many_classes))

范例: 找到出所有class属性且有多个值的节点

from bs4 import BeautifulSoup from bs4.element import Tag import re # 请提取属性值是2个的标签对象 # def test(tag:Tag): # # print('+++++++++++++') # if isinstance(tag, Tag): # # print(type(tag), tag.name, tag.attrs.get('class')) # attr = tag.get('class') # if isinstance(attr, list): # if len(attr) >1: # print(tag.name) # return True # return False # def test(tag:Tag): # return True if isinstance(tag, Tag) and isinstance(tag.get('class'), list) and len(tag.get('class')) >1 else False # def test(tag:Tag): # return isinstance(tag, Tag) and isinstance(tag.get('class'), list) and len(tag.get('class')) >1 def many_values(tag:Tag): return isinstance(tag, Tag) and len(tag.get('class', [])) >1 with open('test.html', encoding='utf-8') as f: doc = BeautifulSoup(f, 'lxml') # BeautifulSoup Tag拥有 find find_all方法 # 方法1 # x = doc.find_all('div') # 找div标签 # print(type(x), x) # print('-' * 30) # for i in x: # print(type(i), i) # print('<>'*30) # print(doc.find_all('p')) # 方法2 print(doc.find_all(re.compile(r'h\d|p'))) # 包含有h数字的标签或者包含p的标签 # 方法3 print(doc.find_all(['p', 'a'])) # p 标签或a标签 print(doc.find_all(re.compile(r'^(a|p)$'))) # p 标签或a标签 print(doc.find_all(['p', 'a', re.compile(r'h\d')])) # p 标签或a标签或者包含有h数字的标签 # 方法4 print(*map(lambda x:x.name, doc.find_all(None))) # find_all => Tag类型 # 方法5 print(doc.find_all(many_values))

keyword传参

- 使用关键字传参,如果参数名不是find系函数已定义的位置参数名,参数会被kwargs收集并被 当做标签的属性 来搜索。

- 属性的传参可以是字符串、正则表达式对象、True、列表。

from bs4 import BeautifulSoup import re with open("test.html",encoding="utf-8") as f: soup = BeautifulSoup(f,"lxml") print(soup.find_all(id="first")) #id为first的所有结点列表 print(1,"- "*30) print(soup.find_all(id=re.compile("\w+"))) #相当于找有di的所有节点 print(2,"- " * 30) print(soup.find_all(id=True)) #所有有id的节点 print(3,"- " * 30) print(list(map(lambda x:x["id"],soup.find_all(id=True)))) print(4,"- " * 30) print(soup.find_all(id=["first",re.compile(r"^sec")])) #指定id的名称列表 print(5,"- " * 30) print(soup.find_all(id=True,src=True)) #相当于条件and,既有id又有src属性的节点列表

范例

import re from bs4 import BeautifulSoup def test(t): print('++++') if t: print(type(t), t) return True return False with open('test.html', encoding='utf-8') as f: doc = BeautifulSoup(f, 'lxml') # print(doc.find_all(id='main')) # **kwargs print(doc.find_all(id='first')) print('-' * 30) print(doc.find_all(src=True, id=True)) # and print(doc.find_all(id=['second', re.compile(r'\d$')])) # or关系 print('-'*30) print(*doc.find_all(id=test), sep='||||||||') # 返回符合条件的Tag对象

css的class的特殊处理

- class是Python关键字,所以使用

class_。class是多值属性,可以匹配其中任意一个,也可以完全匹配。

print(soup.find_all(class_="content")) print(soup.find_all(class_="title")) #可以使用任意一个css类 print(soup.find_all(class_="highlight")) #可以使用任意一个css类 print(soup.find_all(class_="highlight title")) #顺序错了,找不到 print(soup.find_all(class_="title highlight")) #顺序一致,找到。就是字符串完全匹配

范例

from bs4 import BeautifulSoup import re with open('test.html', encoding='utf-8') as f: doc = BeautifulSoup(f, 'lxml') print(doc.find_all(class_=True)) print(doc.find_all(class_='highlight')) # 全字符全长匹配。 匹配 print(doc.find_all(class_='highlight title')) # 字符不匹配返回空 print(doc.find_all(class_='title highlight')) # 匹配 print('-' * 30) print(doc.find_all(class_=re.compile(r'e$')))

attrs参数

- attrs接收一个字典,字典的key为属性名,value可以是字符串、正则表达式对象、True、列表。可以多个属性

print(soup.find_all(attrs={"class":"title"})) print(soup.find_all(attrs={"class":"highlight"})) print(soup.find_all(attrs={"class":"title highlight"})) print(soup.find_all(attrs={"id":True})) print(soup.find_all(attrs={"id":re.compile(r"\d$")})) print(list(map(lambda x:x.name,soup.find_all(attrs={"id":True,"src":True})))) #并且and关系

范例

from bs4 import BeautifulSoup import re def test(t): print('++++') if t: print(type(t), t) return True return False with open('test.html', encoding='utf-8') as f: doc = BeautifulSoup(f, 'lxml') print(doc.find_all( 'p', # p标签 attrs={'id':[re.compile(r'sec'), 'first']} # id包含sec或者等于first )) # 满足p标签并且属性匹配

string参数

- 可以通过string参数搜索文档中的字符串内容,接受字符串、正则表达式对象、True、列表。旧版本为text参数

from bs4 import BeautifulSoup import re with open("test.html",encoding="utf-8") as f: soup = BeautifulSoup(f,"lxml") print(list(map(lambda x:(type(x),x),soup.find_all(string=re.compile("\w+"))))) #返回文本类节点 print("- "*30) print(list(map(lambda x:(type(x),x),soup.find_all(string=re.compile("[a-z]+"))))) print("- "*30) print(soup.find_all(re.compile(r"^(h|p)"), string=re.compile("[a-z]+"))) #相当于过滤Tag对象,并看它的string是否符合text参数要求,返回Tag对象

范例:

from bs4 import BeautifulSoup import re with open('test.html', encoding='utf-8') as f: doc = BeautifulSoup(f, 'lxml') print(doc.find_all(string=True)) # 独立使用string参数,返回元素是字符串 print(list(map(lambda x:x.strip(), filter(lambda x:len(x.strip()) != 0, doc.find_all(string=True))))) print(doc.find_all(string=re.compile(r'[a-zA-Z]+'))) print('=' * 30) # string不独立使用,返回就是Tag类型对象 print(doc.find_all(href=True, string=re.compile(r'[a-zA-Z]+'))) #执行结果 # ['html', '\n', '\n', '\n', '首页', '\n', '\n', '\n', 'TEST', '\n', '\n', 'python', '高级班', '\n', '\n', '字典', '\n', '列表', '\n', '\n', ' comment ', '\n', '\n', '\n', '\n', '\n', 'bottom', '\n'] # ['html', '首页', 'TEST', 'python', '高级班', '字典', '列表', 'comment', 'bottom'] # ['html', 'TEST', 'python', ' comment ', 'bottom'] # [<a href="http://www.python.org">python</a>]

limit参数

显示返回结果的数量

print(soup.find_all(id=True,limit=3)) #返回列表中有3个结果

recursive参数

- 默认是递归搜索所有子孙节点,如果不需要请设置为False

简化写法

find_all()是非常常用的方法,可以简化省略掉

from bs4 import BeautifulSoup import re with open("test.html",encoding="utf-8") as f: soup = BeautifulSoup(f,"lxml") print(soup("img")) #所有img标签对象的列表,等价于soup.find_all("img") print(soup.img) #深度优先第一个img, 调用的soup.find('img) print(soup.h3) print(soup.h3.find_all(string=True)) #返回文本 print(soup.h3(string=True)) #返回文本,和上面等价 print(soup("p", string=True)) #返回a标签对象 print(soup.find_all("img",attrs={"id":"bg1"})) print(soup("img",attrs={"id":"bg1"})) #find_all的省略 print(soup("img",attrs={"id":re.compile("1")}))

范例

from bs4 import BeautifulSoup import re with open('test.html', encoding='utf-8') as f: doc = BeautifulSoup(f, 'lxml') print(doc.div.div) # 本质使用 __getattr__, 内部调用的find print(doc.find('div').find('div')) print('=' * 30) print(doc.find_all('p')) # 简写doc('p') print(doc('p')) # 使用__call__,内部调用find_all

find方法

find(name,attrs,recursive,string,**kwargs)

- 参数几乎和find_all一样。

- 找到了,find_all返回一个列表,而find返回一个单值,元素对象。

- 找不到,find_all返回一个空列表,而find返回一个None。

print(soup.find("img",attrs={"id":"bg1"}).attrs.get("src","cici")) print(soup.find("img",attrs={"id":"bg1"}).get("src")) #简化了attrs print(soup.find("img",attrs={"id":"bg1"})["src"])

CSS选择器

- 和JQuery一样,可以使用CSS选择器来 查找节点

- 使用soup.select()方法,select方法支持大部分CSS选择器,返回列表。

- CSS中,标签名直接使用,类名前加

.点号,id名前加#井号。 - BeautifulSoup.select("css选择器")

from bs4 import BeautifulSoup with open("test.html",encoding="utf-8") as f: soup = BeautifulSoup(f,"lxml") #元素选择器 print(1,soup.select("p")) #所有的p标签 #类选择器 print(2,soup.select(".title")) #使用了伪类 #直接子标签是p的同类型的所有p标签中的第二个 #(同类型)同标签名p的第2个,nth-of-type,且要求是数字 #最新版本实现更多伪类支持 #参考soupsieve.css_parser.CSSParser.parse_pseudo_class print(3,soup.select("div.content >p:nth-of-type(2)")) # id选择器 print(4,soup.select("p#second")) print(5,soup.select("#bg1")) #后代选择器 print(6,soup.select("div p")) # div下逐层找p print(7,soup.select("div div p")) #div下逐层找div下逐层找p #子选择器,直接后代 print(8,soup.select("div > p")) #div下直接子标签的p,有2个 #相邻兄弟选择器 print(9, soup.select("div p:nth-of-type(1) + [src]")) #返回[] print(9, soup.select("div p:nth-of-type(1) + p")) # 返回p标签 print(9, soup.select("div > p:nth-of-type(2) + input")) # 返回input Tag print(9, soup.select("div > p:nth-of-type(2) + [type]")) # 同上 #普通兄弟选择器 print(10, soup.select("div p:nth-of-type(1) ~ [src]")) #返回2个img #属性选择器 print(11,soup.select("[src]")) #有属性src print(12,soup.select("[src='/']")) #属性src等于/ print(13,soup.select("[src='http://www.cici.com/']")) #完全匹配 print(14,soup.select("[src^='http://www']")) #以http://www开头 print(15,soup.select("[src$='com/']")) #以com/结尾 print(16,soup.select("img[src*='cici']")) #包含cici print(17,soup.select("img[src*='.com']")) #包含.com print(18,soup.select("[class='title highlight']")) #完全匹配calss等于'title highlight' print(19,soup.select("[class~=title]")) #多值属性中有一个title

范例

from bs4 import BeautifulSoup import re with open('test.html', encoding='utf-8') as f: doc = BeautifulSoup(f, 'lxml') # html解析3种方法 lxml xpath; bs4 find*; bs4 select css selector # 1 标签选择器 print(doc.select('p')) # 相当于写xpath # 2 id print(doc.select('p#first')) # 3 group print(doc.select('p#first,p#second')) # 4 class print(doc.select('.title')) # 5 后代 descendants print(doc.select('div h3')) print(doc.select('div > h3')) # 6 伪类 pseudo-class print(doc.select('div.content > p:nth-of-type(2)')) # 7 sibling # + 直接兄弟 print(doc.select('div.content > p:nth-of-type(2) + input')) # ~ 后续兄弟 print(doc.select('div.content > p:nth-of-type(2) ~ input')) print(doc.select('div.content > p:nth-of-type(2) ~ img')) # 8 属性 attribute print(doc.select('[src],a[href]')) # 匹配src属性或者a标签中具有href属性的 print(doc.select('[id=bg2]')) print(doc.select('[class="title highlight"]')) print(doc.select('[class~="title"]')) # 匹配多值属性中的一个 print(doc.select('[class*="title"]')) # 包含title print(doc.select('[class^="title"]')) # 前面有title print(doc.select('[class$="highlight"]')) # 后面有highlight

获取文本内容

- 搜索节点的目的往往是为了提取该节点的文本内容,一般不需要HTML标记,只需要文字

from bs4 import BeautifulSoup with open("test.html",encoding="utf-8") as f: soup = BeautifulSoup(f,"lxml") # 元素选择器 ele = soup.select("div") #所有的div标签 print(type(ele)) print(ele[0].string) #内容仅仅只能是文本类型,否则返回None print(list(ele[0].strings)) #迭代保留空白字符 print(list(ele[0].stripped_strings)) #迭代不保留空白字符 print("- "*30) print(ele[0]) print("- " * 30) print(list(ele[0].text))#本质上就是get_text(),保留空白字符的strings print(list(ele[0].get_text())) #迭代并join,保留空白字符,strip默认为False print(list(ele[0].get_text(strip=True))) #迭代并join,不保留空白字符

范例

from bs4 import BeautifulSoup import re with open('test.html', encoding='utf-8') as f: doc = BeautifulSoup(f, 'lxml') print(doc.find('div').string) print(*doc.find('div').strings) print(doc.find('div').text) print(*doc.find('div').stripped_strings, sep=',') print(doc.find('div').get_text(separator=',' , strip=True))

- bs4.element.Tag#string源码

class Tag(PageElement): @property def string(self): if len(self.contents) != 1: return None child = self.contents[0] if isinstance(child, NavigableString): return child return child.string @string.setter def string(self, string): self.clear() self.append(string.__class__(string)) def _all_strings(self, strip=False, types=(NavigableString, CData)): for descendant in self.descendants: if ( (types is None and not isinstance(descendant, NavigableString)) or (types is not None and type(descendant) not in types)): continue if strip: descendant = descendant.strip() if len(descendant) == 0: continue yield descendant strings = property(_all_strings) @property def stripped_strings(self): for string in self._all_strings(True): yield string def get_text(self, separator="", strip=False, types=(NavigableString, CData)): return separator.join([s for s in self._all_strings( strip, types=types)]) getText = get_text text = property(get_text)

Json解析

拿到一个Json字符串,如果想提取其中的部分内容,就需要遍历了。在遍历过程中进行判断。

还有一种方式,类似于XPath,叫做jsonPath。

安装

pip install jsonpath

参考:

- 官网 https://goessner.net/articles/JsonPath/

- https://github.com/json-path/JsonPath

- https://github.com/alibaba/fastjson/wiki/JSONPath

| XPath | JsonPath | 说明 | |

|---|---|---|---|

/ |

$ |

根元素 | |

. |

@ |

当前节点 | |

/ |

.=或者[]= |

获取子节点 | |

.. |

不支持 | 父节点 | |

// |

.. |

任意层次 | |

* |

* |

通配符,匹配任意节点 | |

@ |

不支持 | json中没有属性 | |

[] |

[] |

下标操作 | |

| = | = | [,] |

XPath是或操作,JSONPath allows alternate names or array indices as a set. |

| 不支持 | [start:stop:step] |

切片 | |

[] |

?() |

过滤操作 | |

| 不支持 | () |

表达式计算 | |

() |

不支持 | 分组 |

- 综合示例,使用豆瓣电影的热门电影的Jsonhttps://movie.douban.com/j/search_subjects?type=movie&tag=%E7%83%AD%E9%97%A8&page_limit=10&page_start=0

{

"subjects":[

{

"rate":"8.8",

"cover_x":1500,

"title":"寄生虫",

"url":"https://movie.douban.com/subject/27010768/",

"playable":false,

"cover":"https://img3.doubanio.com/view/photo/s_ratio_poster/public/p2561439800.jpg",

"id":"27010768",

"cover_y":2138,

"is_new":false

},

{

"rate":"7.7",

"cover_x":1500,

"title":"恶人传",

"url":"https://movie.douban.com/subject/30211551/",

"playable":false,

"cover":"https://img3.doubanio.com/view/photo/s_ratio_poster/public/p2555084871.jpg",

"id":"30211551",

"cover_y":2145,

"is_new":false

},

{

"rate":"6.6",

"cover_x":1500,

"title":"异地母子情",

"url":"https://movie.douban.com/subject/26261189/",

"playable":false,

"cover":"https://img3.doubanio.com/view/photo/s_ratio_poster/public/p2562107493.jpg",

"id":"26261189",

"cover_y":2222,

"is_new":true

},

{

"rate":"6.7",

"cover_x":2025,

"title":"我的生命之光",

"url":"https://movie.douban.com/subject/26962841/",

"playable":false,

"cover":"https://img3.doubanio.com/view/photo/s_ratio_poster/public/p2563625370.jpg",

"id":"26962841",

"cover_y":3000,

"is_new":true

},

{

"rate":"7.3",

"cover_x":2025,

"title":"皮肤",

"url":"https://movie.douban.com/subject/27041467/",

"playable":false,

"cover":"https://img1.doubanio.com/view/photo/s_ratio_poster/public/p2559479239.jpg",

"id":"27041467",

"cover_y":3000,

"is_new":true

},

{

"rate":"8.9",

"cover_x":2000,

"title":"绿皮书",

"url":"https://movie.douban.com/subject/27060077/",

"playable":true,

"cover":"https://img3.doubanio.com/view/photo/s_ratio_poster/public/p2549177902.jpg",

"id":"27060077",

"cover_y":3167,

"is_new":false

},

{

"rate":"8.0",

"cover_x":3600,

"title":"疾速备战",

"url":"https://movie.douban.com/subject/26909790/",

"playable":false,

"cover":"https://img3.doubanio.com/view/photo/s_ratio_poster/public/p2551393832.jpg",

"id":"26909790",

"cover_y":5550,

"is_new":false

},

{

"rate":"7.9",

"cover_x":1786,

"title":"流浪地球",

"url":"https://movie.douban.com/subject/26266893/",

"playable":true,

"cover":"https://img3.doubanio.com/view/photo/s_ratio_poster/public/p2545472803.jpg",

"id":"26266893",

"cover_y":2500,

"is_new":false

},

{

"rate":"8.2",

"cover_x":684,

"title":"沦落人",

"url":"https://movie.douban.com/subject/30140231/",

"playable":false,

"cover":"https://img3.doubanio.com/view/photo/s_ratio_poster/public/p2555952192.jpg",

"id":"30140231",

"cover_y":960,

"is_new":false

},

{

"rate":"6.4",

"cover_x":960,

"title":"疯狂的外星人",

"url":"https://movie.douban.com/subject/25986662/",

"playable":true,

"cover":"https://img1.doubanio.com/view/photo/s_ratio_poster/public/p2541901817.jpg",

"id":"25986662",

"cover_y":1359,

"is_new":false

}

]

}

from jsonpath import jsonpath import requests import json ua = "Mozilla/5.0 (Windows; U; Windows NT 6.1; zh-CN) AppleWebKit/537.36 (KHTML, like Gecko) Version/5.0.1 Safari/537.36" url = "https://movie.douban.com/j/search_subjects?type=movie&tag=%E7%83%AD%E9%97%A8&page_limit=10&page_start=0" with requests.get(url,headers={"User-agent":ua}) as response: if response.status_code==200: text = response.text print(text[:100]) js = json.loads(text) print(str(js)[:100]) #json转换为Python数据结构 #知道所有电影的名称 rs1 = jsonpath(js,"$..title") #从根目录开始,任意层次的title属性 print(rs1) #找到所有subjects rs2 = jsonpath(js,"$..subjects") print(len(rs2),str(rs2[0])[:100]) #由于太长,取前100个字符 print("- " * 30) # 找到所有得分高于8分的电影名称 # 根下任意层的subjects的子节点rate大于字符串8 rs3 = jsonpath(js,'$..subjects[?(@.rate > "8")]') #?()是过滤器 print(rs3) print("- "*30) #根下任意层的subjects的子节点rate大于字符串8的节点的子节点title rs4 = jsonpath(js,'$..subjects[?(@.rate > "8")].title') print(rs4) print("- " * 30) #切片 rs5 = jsonpath(js,"$..subjects[?(@.rate > '6')].title") print(rs5[:2])

范例

from jsonpath import jsonpath import json import requests # url = 'https://movie.douban.com/j/search_subjects?type=movie&tag=%E7%83%AD%E9%97%A8&page_limit=10&page_start=0' # # headers = { # 'User-agent': "Mozilla/5.0 (Windows; U; Windows NT 6.1; zh-CN) AppleWebKit/537.36 (KHTML, like Gecko) Version/5.0.1 Safari/537.36" # } # # with requests.get(url, headers=headers) as response: # if response.status_code == 200: # # text = response.text # # print(type(text), text) # with open('a.json', 'wb') as f: # f.write(response.content) with open('a.json', encoding='utf8') as f: j = json.loads(f.read()) x = jsonpath(j, '$..title') # 内部异常不抛出,错了就False print(x) # 拿到所有title和url print(jsonpath(j, '$..title,url')) # xpath //tite|//url # 获取8分以上 # 找到所有得分高于8分的电影名称 # 根下任意层的subjects的子节点rate大于字符串8 print(jsonpath(j, '$..subjects[?(@.rate > "8")]')) # 8分以上信息 print(jsonpath(j, '$..subjects[?(@.rate > "8")].title,url')) # 8分以上title,url print(jsonpath(j, '$..subjects[?(@.rate > "8")].title,url')[:2]) # 8分以上title和url,切片

RabbitMQ

RabbitMQ是由LShift提供的一个Advanced Message Queuing Protocol (AMQP)的开源实现,由以高性能、健壮以及可伸缩性出名的Erlang写成,因此也是继承了这些些优点。

很成熟,久经考验,应用广泛。

文档详细,客户端丰富,几乎常用语言都有RabbitMQ的开发库

部署

安装

https://www.rabbitmq.com/docs/install-rpm

- 选择RPM包下载,选择对应平台,本次安装在Rocky,其他平台类似。

由于使用了erlang语言开发,所以需要erlang的包。erlang和RabbitMQ的兼容性,参考https://www.rabbitmq.com/docs/which-erlang#compatibility-matrix

- 下载 rabbitmq-server-3.7.16-1.el7.noarch.rpm、erlang-21.3.8.6-1.el7.x86_64.rpm。socat在CentOS中源中有。

yum -y install erlang-21.3.8.6-1.el7.x86_64.rpm rabbitmq-server-3.7.16-1.el7.noarch.rpm

- 查看安装的文件

[root@xdd ~]# rpm -ql rabbitmq-server /etc/logrotate.d/rabbitmq-server /etc/profile.d/rabbitmqctl-autocomplete.sh /etc/rabbitmq /usr/lib/ocf/resource.d/rabbitmq/rabbitmq-server /usr/lib/ocf/resource.d/rabbitmq/rabbitmq-server-ha /usr/lib/rabbitmq/autocomplete/bash_autocomplete.sh /usr/lib/rabbitmq/autocomplete/zsh_autocomplete.sh /usr/lib/rabbitmq/bin/cuttlefish /usr/lib/rabbitmq/bin/rabbitmq-defaults

配置

环境配置

- 使用系统环境变量,如果没有使用rabbitmq-env.conf中定义环境变量,否则使用缺省值

RABBITMQ_NODE_IP_ADDRESS the empty string, meaning that it should bind to all network interfaces. RABBITMQ_NODE_PORT 5672 RABBITMQ_DIST_PORT RABBITMQ_NODE_PORT + 20000 #内部节点和客户端工具通信用 RABBITMQ_CONFIG_FILE 配置文件路径默认为/etc/rabbitmq/rabbitmq

环境变量文件,可以不配置

工作特性配置文件

- rabbitmq.config配置文件

- 3.7支持新旧两种配置文件格式

- erlang配置文件格式,为了兼容继续采用

- sysctl格式,如果不需要兼容,RabbitMQ鼓励使用。 (这个文件也可以不配置)

插件管理

列出所有可用插件

rabbitmq-plugins list

- 启动WEB管理插件,会依赖启用其他几个插件。

rabbitmq-plugins enable rabbitmq_management

启动服务

systemctl start rabbitmq-server

[root@xdd ~]# ss -tanl | grep 5672 LISTEN 0 128 *:25672 *:* LISTEN 0 128 *:15672 *:* LISTEN 0 128 :::5672 :::* [root@xdd ~]#

容器方式启动服务

# 拉取docker镜像 docker pull rabbitmq:management mkdir -p docker/rabbitmq docker run -d --name=rabbitmq \ -v ./docker/rabbitmq:/var/lib/rabbitmq \ -p 15672:15672 -p 5672:5672 \ -e RABBITMQ_DEFAULT_USER=admin \ -e RABBITMQ_DEFAULT_PASS=admin \ rabbitmq:management # http://<IP>:15672 用户名和密码: admin

用户管理

- 开始登陆WEB界面, http://<ip>:15672

- 使用guest/guest只能本地登陆,远程登录会报错

rabbitmqctl命令

└─$ docker exec -i rabbitmq rabbitmqctl rabbitmqctl [--node <node>] [--timeout <timeout>] [--longnames] [--quiet] <command> [<command options>] Users: add_user 添加用户 authenticate_user Attempts to authenticate a user. Exits with a non-zero code if authentication fails. change_password 修改用户名,密码 clear_password Clears (resets) password and disables password login for a user clear_user_limits Clears user connection/channel limits delete_user 删除用户 list_user_limits Displays configured user limits list_users 列出用户 set_user_limits Sets user limits set_user_tags 设置用户tag docker exec -i rabbitmq rabbitmqctl help add_user

- 添加用户:

rabbitmqctl add_user username password - 删除用户:

rabbitmqctl delete_user username - 更改密码:

rabbitmqctl change_password username newpassword - 设置权限Tags,其实就是分配组:

rabbitmqctl set_user_tags username tag

用户tag

- management 用户可以访问管理插件

- policymaker 用户可以访问管理插件并管理他们有权访问的虚拟主机的策略和参数。

- monitoring 用户可以访问管理插件并查看所有连接和通道以及节点相关信息。

- administrator 用户可以执行监控可以执行的所有操作,管理用户、虚拟主机和权限,关闭其他用户的连接,以及管理所有虚拟主机的策略和参数。

设置jasper用户为管理员tag后登陆

rabbitmqctl add_user jasper 123456 #添加jasper用户 rabbitmqctl list_users #查看所有用户 rabbitmqctl set_user_tags jasper administrator #设置admin用户为管理员用户

- tag的意义如下:

- administrator可以管理用户、权限、虚拟主机。

- 基本信息(web管理端口15672,协议端口5672)

- 虚拟主机

- 缺省虚拟主机,默认只能是guest用户在本机链接,下图新建的用户gdy默认无法访问任何虚拟主机

虚拟主机

/ 为确实虚拟主机

缺省虚拟主机,默认只是guest用户在本机连接。新建用户默认无法访问任何虚拟主机。

这里我们使用jasper用户在Admin页面中创建一个虚拟主机 test。

Pika库

Pika是纯Python实现的支持AMQP协议的库

pip install pika

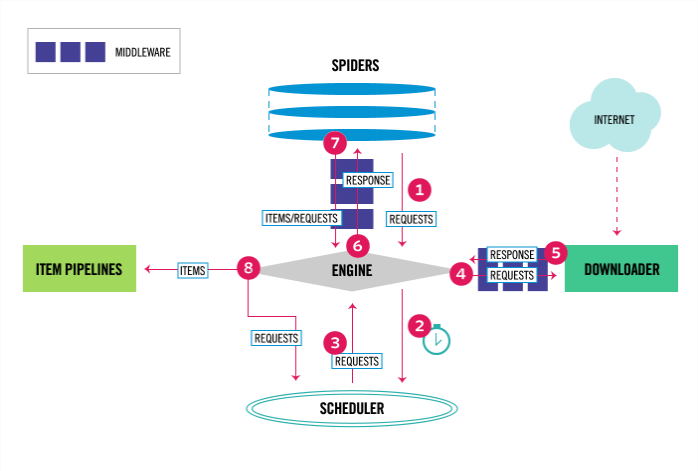

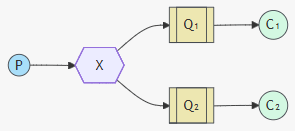

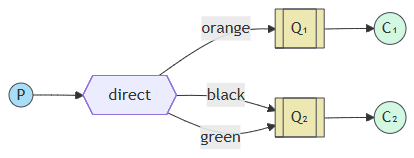

RabbitMQ工作原理及应用

工作模式

参考官网 https://www.rabbitmq.com/tutorials

- 简单列表模式

- 工作队列模式

- 发布文章模式

- 路由模式

- 话题模式

- RPC模式

名词解释

| 名词 | 说明 |

|---|---|

| Server | 服务器。 |

| 接受客户端连接,实现消息队列及路由功能的进程(服务),也称为消息代理 | |

| 注意:客户端可用生产者,也可以是消费者,它们都需要连接到Server | |

| Connection | 网络物理连接 |

| Channel | 一个连接允许多个客户端连接 |

| Exchange | 交换器。接收生产者发来的消息,决定如何 路由 给服务器中的队列。 |

| 常用的类型有:direct(point-to-point) 路由模式; topic(publish-subscribe) ; fanout(multicast)广播模式 | |

| Message | 消息 |

| Message Queue | 消息队列,数据的存储载体 |

| Bind | 绑定。 |

| 建立消息队列和交换器之间的关系,也就是说交换器拿到数据,把什么样的数据送给哪个队列 | |

| Virtual Host | 虚拟主机。 |

| 一批交换器、消息队列和相关对象的集合。为了多用户互不干扰,使用虚拟主机分组交换机,消息队列 | |

| Topic | 主题、话题 |

| Broker | 可等价为Server |

1.队列 *

- 这种模式就是最简单的生产者消费者模型,消息队列就是一个FIFO的队列

- 生产者send.py,消费者receie.py

- 官方例子:https://www.rabbitmq.com/tutorials/tutorial-one-python.html

参照官方例子,写一个小程序

# send.py import pika from pika.adapters.blocking_connection import BlockingChannel #构建用户名密码对象 credential = pika.PlainCredentials("jasper","123456") # 配置链接参数 params = pika.ConnectionParameters( "192.168.61.108",#ip地址 5672, #端口 "test",#虚拟机 credential #用户名密码 ) # # 第二种建立连接方式 # params = pika.URLParameters("amqp://jasper:[email protected]:5672/test") # 建立连接 connection = pika.BlockingConnection(params) with connection: # 建立通道 channel:BlockingChannel = connection.channel() #创建一个队列,queue命名为hello,如果queue不存在,消息将被dropped channel.queue_declare(queue="hello") channel.basic_publish( exchange="",#使用缺省exchange routing_key="hello", #routing_key必须指定,这里要求和目标queue一致 body="Hello world" #消息 ) print("消息发送成功Sent Message OK")

测试通过。去服务管理界面查看Exchanges和Queues。

注意:出现如下运行结果

pika.exceptions.ProbableAuthenticationError: (403, 'ACCESS_REFUSED - Login was refused using authentication mechanism PLAIN. For details see the broker logfile.')

- 访问被拒绝,还是权限问题,原因还是guest用户只能访问localhost上的缺省虚拟主机

解决办法

- 缺省虚拟主机,默认只能在本机访问,不要修改为远程访问,是安全的考虑。

- 因此,在Admin中Virtual hosts中,新建一个虚拟主机test。

- 注意:新建的test虚拟主机的Users是谁,本次是gdy用户

在ConnectionParameters中没有用户名、密码填写的参数,它使用参数credentials传入,这个需要构建一个pika.credentials.Credentials对象。

URLParameters,也可以使用URL创建参数

# amqp://username:password@host:port/<virtual_host>[?query-string] parameters = pika.URLParameters('amqp://guest:guest@rabbit-server1:5672/%2F') # %2F指代/,就是缺省虚拟主机

- queue_declare声明一个queue,有必要的话,创建它。

- basic_publish exchange为空就使用缺省exchange,如果找不到指定的exchange,抛异常

使用缺省exchange,就必须指定routing_key,使用它找到queue

修改上面生产者代码,让生产者连续发送send Message。在web端查看Queues中Ready的变化